本記事では、LLM研究全体の背景と現状、そして将来展望を網羅的に整理する調査論文をもとに、LLMの基礎を振り返ります。初回は代表的なモデルについて深掘りし、前回はモデルの構築法について深掘りしました。

初回の記事:大規模言語モデル(LLM)のこれまでとこれから① -代表的なモデル編-

前回の記事:大規模言語モデル(LLM)のこれまでとこれから② -モデル構築編-

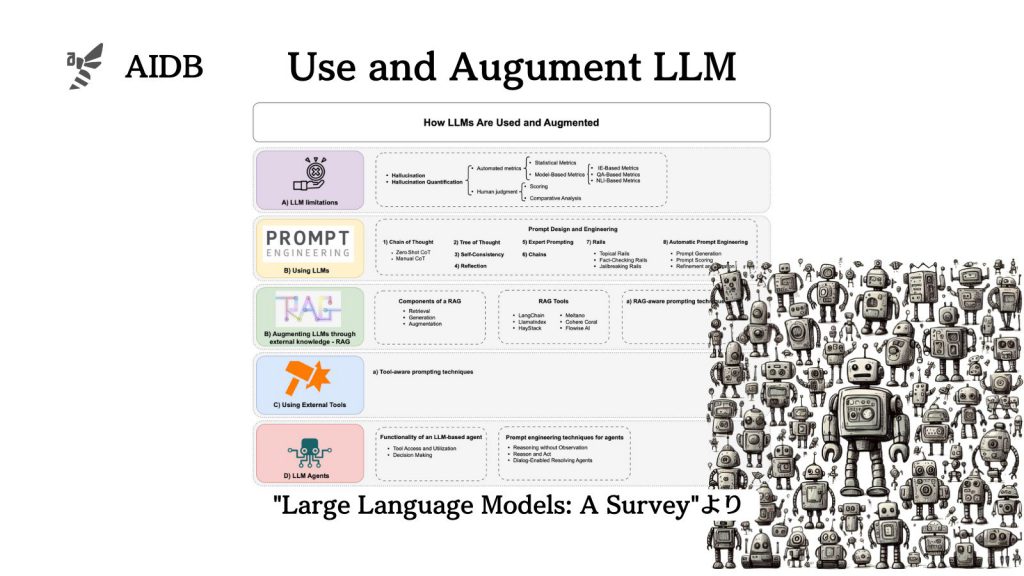

今回は、モデルの使用法・拡張法、そして主なデータセットについて深掘りします。

参照論文情報

- タイトル:Large Language Models: A Survey

- 著者:Shervin Minaee, Tomas Mikolov, Narjes Nikzad, Meysam Chenaghlu, Richard Socher, Xavier Amatriain, Jianfeng Gao

- 所属:論文には所属機関が示されていないため各機関から有志の研究グループが結成されたことが推測されます。

- URL:https://doi.org/10.48550/arXiv.2402.06196

前回のおさらい

前回は、以下の項目に沿ってLLMの構築方法について触れました。

- 主流となっているLLMの構造

- データクリーニング

- トークン化

- 位置エンコーディング

- モデルの事前学習

- ファインチューニングと指示チューニング

- アライメント

- デコーディングの戦略

- コスト効率に優れた開発と運用

本記事では、モデルの使用方法や拡張(強化)方法や主なデータセットにフォーカスします。

LLMは基本的なプロンプト(指示)だけでも使用可能ですが、その能力を最大限に活用したり、欠点を補うためには、さらなる工夫が必要になります。

今回はまず、