NVIDIAの研究者らは、Llama-2などをベースに「ChatQA」という質問応答タスクに強いモデルを作成し、GPT-4と同等の精度を持つと報告しています。

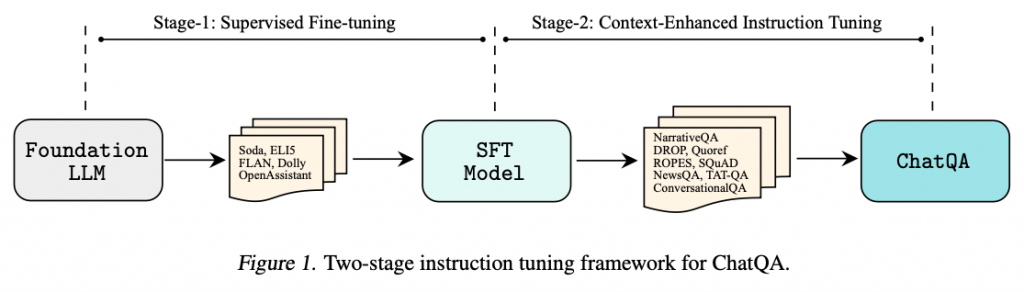

指示チューニング(モデルをタスクに適応させること)を2段階で行うことにより、LLMの質問応答タスクのゼロショット性能が大幅に改善されるとのことです。

参照論文情報

- タイトル:ChatQA: Building GPT-4 Level Conversational QA Models

- 著者:Zihan Liu, Wei Ping, Rajarshi Roy, Peng Xu, Chankyu Lee, Mohammad Shoeybi, Bryan Catanzaro

- 所属:NVIDIA

- URL:https://doi.org/10.48550/arXiv.2401.10225

研究背景

質問応答はLLMのアプリケーション(例えばChatGPT)で最も好まれている使い方の一つです。GPT-4をはじめとしたLLMは質問応答タスクに秀でており、さまざまな製品開発や研究に大きな影響を与えています。

モデルの質問応答能力には以下の要素が大事だと考えられています。

- 会話形式で直接やりとりできる

- 特定のデータセットに依存していない

- 様々な分野に対応できる

- ゼロショットで回答を生成できる

- 長文のドキュメントを参照できる

- RAGに対応している(情報を検索して統合できる)

質問応答能力で最も強いモデルであるGPT-4はクローズドな商用モデルであり、匹敵するほど精度の高いモデルを手元で構築できるノウハウが求められています。

そのような背景の中、NVIDIAの研究者らはLLMがゼロショットで会話型の質問応答タスクを行う能力を向上させるため、2段階の指示チューニング手法とデータ収集の方法論を編み出しました。

そして、その方法論に基づいて「ChatQAモデル」ファミリーを構築し、最先端のモデルと比較して結果を報告しています。

下記では手法の概要、実験結果などを紹介します。

方法論

今回研究者らは、