本企画では、AIDBのX (旧Twitter) で紹介されたいくつかの最新AI研究を、ダイジェスト形式でお届けします。

普段の有料会員向け記事では、技術的な切り口から研究を詳しく紹介していますが、この企画では科学的な知識として楽しめるよう、テーマの概要をわかりやすくお伝えします。

今週は、AIが集まると自然と“暗黙のルール”を作り始める話、人間の言葉でドローンを飛ばせる新技術、感情知能テストで人間を超えるAIの能力、言語を超えた抽象思考の兆候、AI専用のウェブインターフェースの提案、自ら学び成長する“自己進化型モデル”、そしてAIと人が仕事をどう分担するべきかに関する実践的な分析など、AIが“社会でどう生き、どう関わるか”を深く考えさせられる7本です。

研究に対する反応が気になる方は、ぜひAIDBのXアカウント (@ai_database)で紹介ポストもご覧ください。中には多くの引用やコメントが寄せられた話題もあります。

また、一部はPosfieにも掲載されており、読者のリアクションをまとめたページもあわせて公開しています。

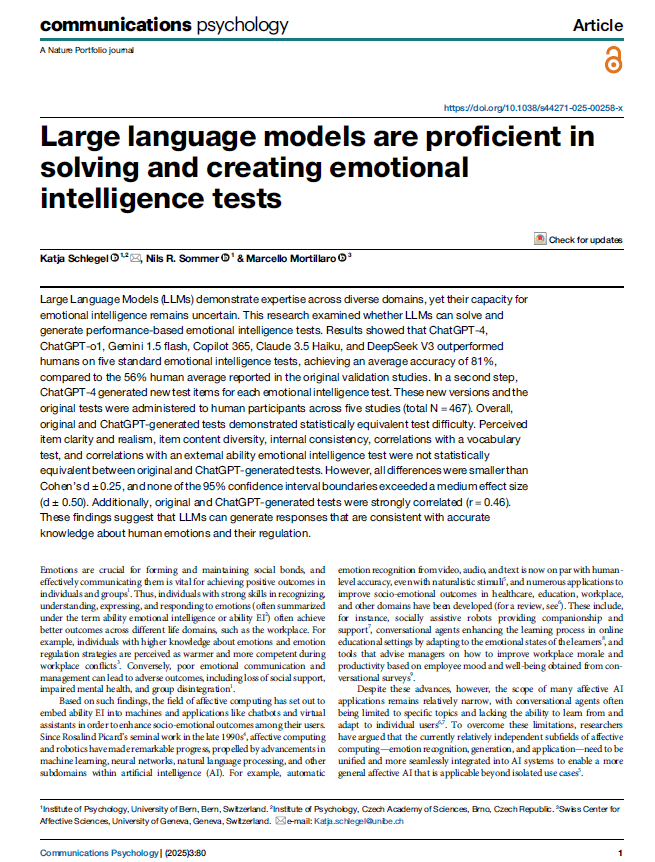

AIが集まると生まれる「暗黙のルール」、LLMが見せた集団のクセと偏り

AIが集まると人間のような「暗黙のルール」を勝手に作り出すとのこと。

研究チームは、LLMに「同じ文字を選ぶと得点、違う文字だと減点」というシンプルなゲームをさせました。

AIたちは、回数を重ねるうちに、誰かに指示されたわけでもないのに、全員が同じ文字を選ぶようになりました。

まるで「この文字を使おう」という暗黙の合意ができたかのようです。

さらに面白いのは、AIも集団になると特定の文字を好む傾向が強く出てきた点です。

人間でも集団になると特定の行動に偏ることがあるのと似ています。

また、一度定着したルールを覆すには、少数でも強く主張するAIの存在が重要でした。

ただし、どのくらいの人数が必要かはAIの種類によって大きく異なりました。

この研究から得られる示唆は、AIが人間社会に入り込んだとき、個別のAIが公平であっても、集団になると予想外の偏りやルールが生まれる可能性があるということです。

つまり、個々のAIだけでなく、集団としてのふるまいまで含めて考える必要があります。

この論文はScience系列の論文誌Science Advancesに掲載されました。

参考文献

Emergent social conventions and collective bias in LLM populations

https://www.science.org/doi/10.1126/sciadv.adu9368

Ariel Flint Ashery, Luca Maria Aiello, Andrea Baronchelli

City St George’s, University of London, IT University of Copenhagen, Pioneer Centre for AI, The Alan Turing Institute

関連記事

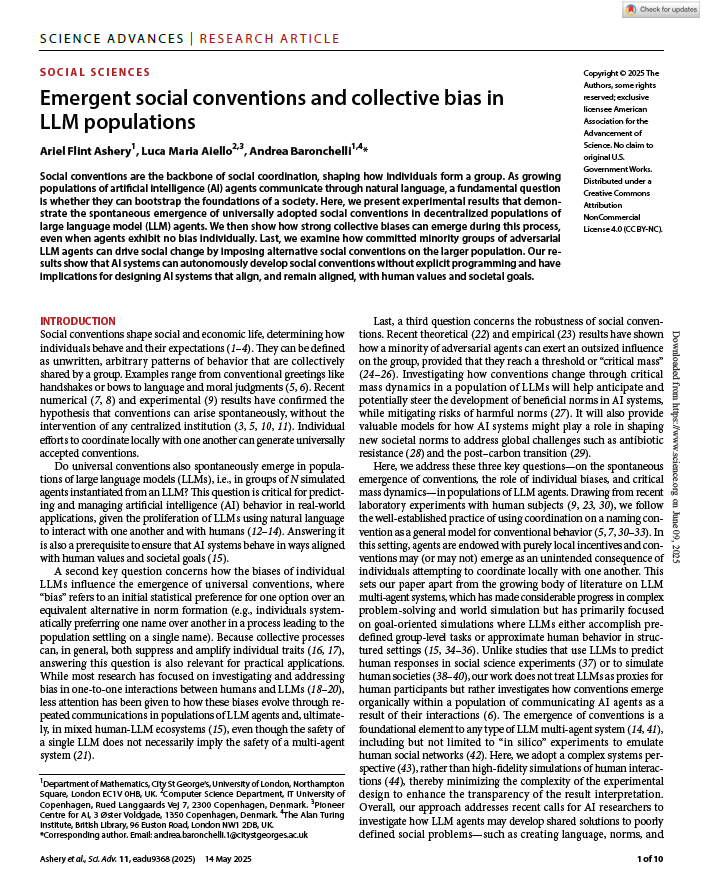

話しかけるだけで動くドローン、自然言語で操縦できる新システムの挑戦

「ドローンに人間の言葉で指示を出せるシステム」を作ったとのこと。

たとえば「あの赤い箱のところまで飛んで行って」といった指示で、ドローンが自動的に目標を見つけて飛行できるようになります。

仕組みとしては、LLMと画像認識モデルを組み合わせです。LLMが人間の指示を理解して飛行コマンドに変換し、画像認識モデルがカメラ映像から目標物を探します。

現時点ではまだミッション達成率も研究段階水準であり、実用化には更なる改良が必要な状況です。

しかしこうした技術が発展すると、倉庫での在庫確認や設備点検など、産業用途でドローンがより使いやすくなる可能性があります。

システムはオープンソースで公開されているため(対応する実機があれば)誰でも試せます。

参考文献

Taking Flight with Dialogue: Enabling Natural Language Control for PX4-based Drone Agent

https://arxiv.org/abs/2506.07509

Shoon Kit Lim, Melissa Jia Ying Chong, Jing Huey Khor, Ting Yang Ling

University of Southampton Malaysia, University of Southampton

関連記事

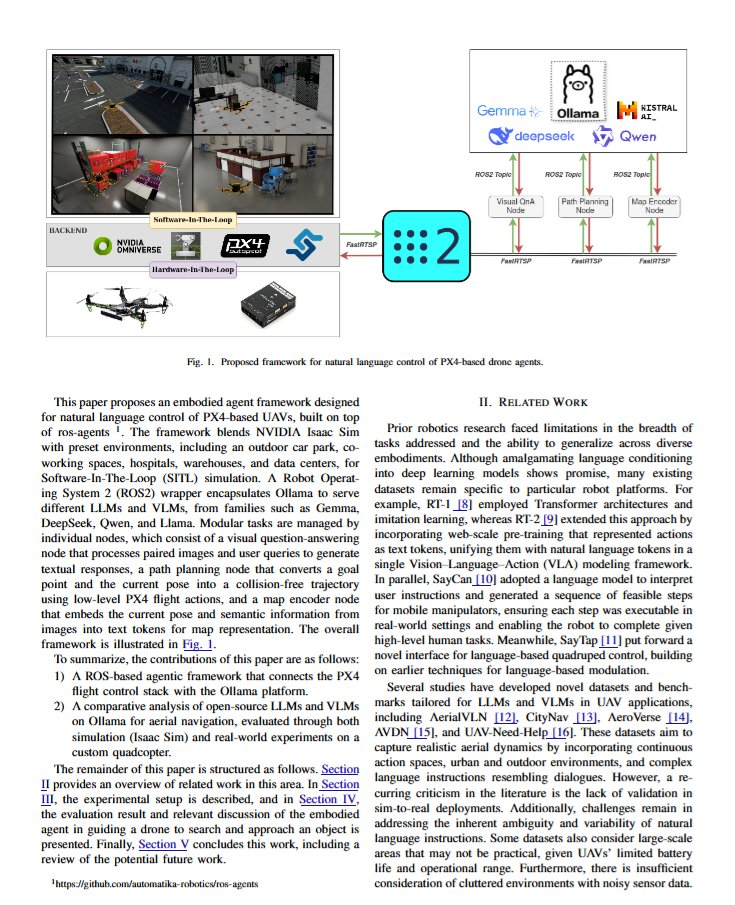

AIは“感情のテスト”もお手のもの? 人間以上に感情を読み解くLLMの実力

AIが人間の感情を理解する能力を調べたところ、最近のLLMはどれも人間の平均点を大きく上回ったとのこと。

研究者たちは、人間が受ける感情知能テストを複数のAIに受けさせました。

その結果、人間の正答率が平均56%だったのに対し、AIは81%の正答率を記録しました。

また「新しい感情知能テストを作ってみて」というタスクに対し、元のテストとほぼ同じ品質のテスト問題を作ることも確認。

人間の参加者467人に両方のテストを受けてもらったところ、難易度や信頼性において大きな違いはありませんでした。

いまのAIは平均的な人間よりも感情的な状況を正確に理解し、適切な対応方法を判断できるという解釈にいたります。

感情に関わるストーリーを創作する能力すら持ち合わせています。

ただし、AIが実際に感情を「感じる」わけではなく、あくまで感情に関する知識や判断力において優れているということです。

とはいえ、カスタマーサービス、あるいは教育や医療などの分野で感情的に適切な対応をする役目をAIが担える可能性が高まってきました。

なお、国や文化によって理解レベルが変動することも注意点です。

Nature communications psychology誌掲載論文より。

参考文献

Large language models are proficient in solving and creating emotional intelligence tests

https://www.nature.com/articles/s44271-025-00258-x

Katja Schlegel, Nils R. Sommer & Marcello Mortillaro

University of Bern, Czech Academy of Sciences, University of Geneva

関連記事

AIが言葉を超えた抽象思考を手に入れた

人が複数の言語を話すとき、ことばを超えた概念に基づいて考えます。

(例えば頭の中で「愛」は、英語の「love」と同じ抽象的な概念を指しています)

LLMも、発達するにつれて、こうした”特定の言語に依存しない「共通の思考回路」”のようなものが形成されていることが分かりました。

つまり最近のAIは言語を学習する過程で人のような「抽象思考」を獲得している可能性があるとの報告です。

興味深いことに、この共通思考回路に関わるニューロンはモデル全体のわずか1%未満しかありません。

しかし、この小さな部分を無効化すると、モデルの全言語での性能が劇的に低下するそうです。

人の脳の大事な部分を損傷すると言語能力に広く影響するのと似ています。

最新のモデルほど、この共通思考回路が発達しているとのことです。

これは、AIは単に言語を暗記しているのではないのではなく「考える」能力を身につけつつあることを示唆するのではないかと述べられています。

参考文献

The Emergence of Abstract Thought in Large Language Models Beyond Any Language

https://arxiv.org/abs/2506.09890

Yuxin Chen, Yiran Zhao, Yang Zhang, An Zhang, Kenji Kawaguchi, Shafiq Joty, Junnan Li, Tat-Seng Chua, Michael Qizhe Shieh, Wenxuan Zhang

National University of Singapore, Salesforce AI Research, Peking University, Singapore University of Technology and Design

AIが使いやすいウェブを設計する新しい発想が登場

「ウェブのためのエージェントではなく“エージェントのためのウェブ”を作ろう」とのこと。

人間とAIでは情報の処理方法や必要な機能が全く違うのに、人間用に作られたインターフェースを無理やり使わせているのが現状です。

(スクリーンショットでは隠れた情報が見えず、HTMLの生データは情報量が膨大すぎてコストが跳ね上がる)

安全性についても、AIがブラウザを通じてパスワードやクレジットカード情報にアクセスできてしまうリスクを解決する必要があります。

また、大量のAIがアクセスするとウェブサイトが重くなる恐れも。

そのため、人間用のウェブとは別にAIエージェント専用のウェブインターフェース(「AWI」)を新たに開発すべきだと提案されています。

AI研究者だけでなく、ウェブ開発者、セキュリティ専門家、ユーザーインターフェース設計者など、幅広い専門家が協力して取り組むべきとの主張です。

参考文献

Build the web for agents, not agents for the web

https://arxiv.org/abs/2506.10953

Xing Han Lù, Gaurav Kamath, Marius Mosbach, Siva Reddy

McGill University, Mila – Quebec AI Institute

関連記事

AIが自分を育てる時代へ、「自己進化型モデル」の衝撃

自らファインチューニングデータを生成し、重みを更新する能力を持つ言語モデルの仕組みを開発したとのMITの報告。

平たく言うと新しいタスクや知識に適応するよう自らの体を作り替えるAIの発明です。

基本的に、既存のAIは人間が用意したデータをそのまま学習するしかありません。今回のAIは新しい情報を受け取ったとき、その情報を自分なりに理解しやすい形に書き直してから学習します。

この仕組みで生み出されるファインチューニングデータは、既存の大規模モデルによる合成データよりも効果的であったそうです。

全く解けなかった問題が72.5%も解けるようになったり、知識の記憶テストで大幅に成績が向上したりすることも確認済みとのこと。

2028年頃には人間が書いた文章がインターネット上で枯渇すると予測されているため、AIが自分で学習材料を作り出す能力は非常に重要になると考えられています。

参考文献

Self-Adapting Language Models

https://arxiv.org/abs/2506.10943

Adam Zweiger, Jyothish Pari, Han Guo, Ekin Akyürek, Yoon Kim, Pulkit Agrawal

MIT

関連記事

AIと仕事を分け合う時代へ 働き手が望む協力とすれ違う自動化の現実

スタンフォード大学研究者らの報告によると、労働者の多くは「AIに仕事を手伝ってほしい」と思っているが、完全に仕事を奪われたい訳ではないとのこと。

そして労働者が「これはAIにやってもらいたい」と思っている仕事とAI技術者が「これはAIで自動化できる」と思っている仕事は全然一致していないのが現状のようです。

つまり、技術的には可能でも労働者が望まない自動化がたくさんあり、逆に労働者が望んでいるのに技術がまだ追いついていない分野もたくさんあるということです。

また人々は、AIと”対等なパートナーとして”働きたいと考える傾向にあります。

AIが全部やってくれるのでもなく、人間が全部やるのでもなく、お互いの得意分野を活かして協力したい。

(ただし、つまらない作業や繰り返し作業をAIにやってもらい、自分はもっと価値のある仕事に集中したい。と考えています)

いずれにせよ求められるスキルは変わってきています。「データを分析する」「情報を処理する」といった仕事はAIが得意になってきているので、代わりに「人とのコミュニケーション」「チームをまとめる」といった人間らしいスキルがより重要になってきています。

参考文献

Future of Work with AI Agents: Auditing Automation and Augmentation Potential across the U.S. Workforce

https://arxiv.org/abs/2506.06576

Yijia Shao, Humishka Zope, Yucheng Jiang, Jiaxin Pei, David Nguyen, Erik Brynjolfsson, Diyi Yang

Stanford University

関連記事

まとめ

AIは、正しく動く道具から、社会の中で「どう関わるか」「どう生きるか」まで問われる存在になってきています。自律的にルールを作ったり、人と自然に会話したり、感情を理解して対応したりと、いまのAIは思考や判断のかたちそのものを進化させつつあります。言語を超えた抽象的な理解、自分で学び方を編み出す力、人との協働のあり方に関する問いなど、そこには“使われる側”にとどまらないAIの姿が見えはじめています。

私たちは今、AIが何をできるかだけでなく、何を感じ取り、どう協力しようとしているのかという“内面”に目を向ける段階にきているのかもしれません。

このシリーズでは引き続き、そんな変わりゆくAIの姿を、科学のまなざしでやさしくひもといていきます。

次回も、AIたちの進化の先にある未来を一緒に見つめていきましょう。

最新の科学ニュースをご覧になりたい方はAIDBのX (旧Twitter) もぜひチェックしてみてください。