東京大学と株式会社オルタナティヴ・マシンの研究チームは、「大規模言語モデル(LLM)は物理的な世界とどのように結びつくのだろうか?」といった問いに着目しました。

そこで、GPT-4をヒューマノイドロボット「Alter3」と統合することで、この問いに応える試みを行いました。

実験の結果、ロボットはGPT-4によって生成された指示に基づき、人間のような動作と感情表現を示すことができたとの報告が行われています。

本記事では、研究の詳細を見ていきます。

参照論文情報

- タイトル:From Text to Motion: Grounding GPT-4 in a Humanoid Robot “Alter3”

- 著者:Takahide Yoshida, Atsushi Masumori, Takashi Ikegami

- 所属:東京大学, 株式会社オルタナティヴ・マシン

- URL:https://doi.org/10.48550/arXiv.2312.06571

- GitHub:https://tnoinkwms.github.io/ALTER-LLM/

本記事の関連研究:GPT-4との対話でタスクプランニングを行うロボットシステムフレームワークが発明されました。

研究背景

最近の大規模言語モデル(LLM)の進歩は非常に注目されており、中でもGPT-4は特に文脈を理解する点で際立っています。ただし、高度なLLMはテキストを通じて人間のような行動を示す能力は持っていますが、実際の物理的な行動にはまだ及ばないのが現状です。

一方で、研究と開発の分野では、LLMの豊富な知識をヒューマノイドロボットに適用することで新しい可能性を探ることが期待されています。最近では、そういったAIとロボティクスの統合が注目を集めています。

今後は、ロボットの機能と独立性を向上させることが必要とされており、LLMをロボットに適用するのは一つの手段です。しかし、LLMはまだハードウェアの制御には関与していないため、ロボットの制御方法に新たなアプローチが求められています。

本記事の関連研究:ロボットが「初めて見る環境」で「初めて聞く指示」に対しても行動をとれるようにする

研究のメインアイデア

LLMとヒューマノイドロボットの統合

この研究の主要なテーマは、GPT-4とヒューマノイドロボット「Alter3」を連携させることでした。

LLMの広範な知識と言語処理能力をロボットに組み込むことで、自然言語による新たな動作生成を目指しています。

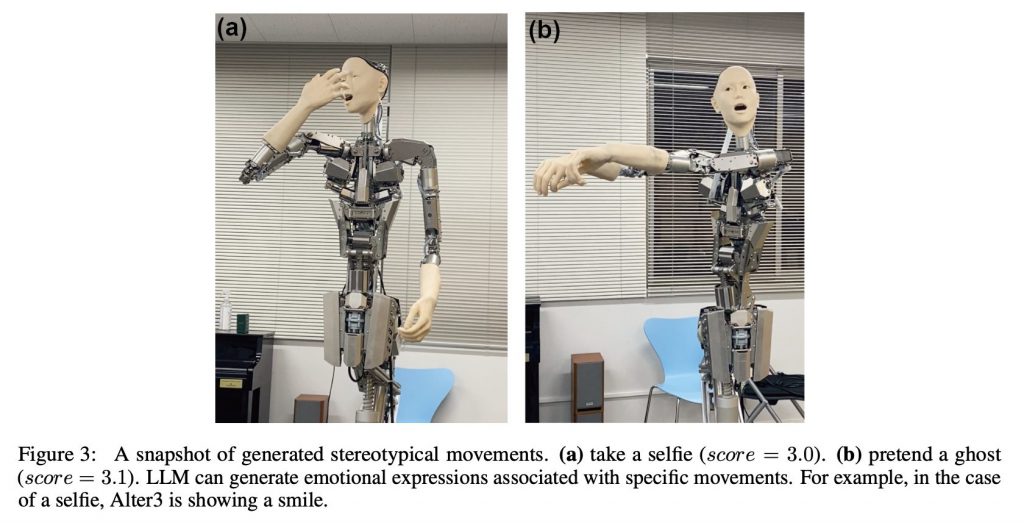

下の画像は、ロボットがGPT-4を通じて人間の動作と感情を再現する様子を切り取ったものです。研究では、このような能力が人間とロボットの相互作用において重要な役割を果たすと考えられています。

物理的世界へのLLMの応用

LLMは従来、テキストやコード生成に限定されていましたが、本研究では機械的な動作に応用することで、応用範囲の拡張を図っています。

GPT-4の知識や能力を、実世界の動作へと変換する上で、ヒューマノイドロボットが媒介的な役割を果たしているという見方ができますね。

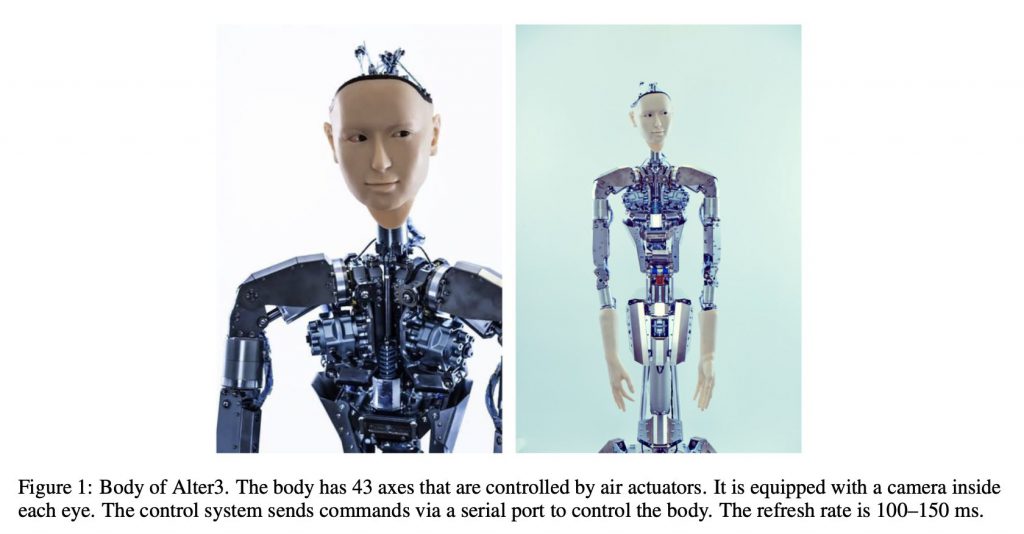

下記画像は、Alter3が、言語モデルが生成した指示を物理的な動きへと変換するための構造を有している様子を表しています。43の軸を駆使して、人間の動きを模倣します。なお、カメラを内蔵し、シリアルポート経由で制御されます。

人間らしい行動と感情表現の模倣

また研究者らはLLMを通じて、人間らしい動作や感情表現をロボットが行うようになることを目指しました。

将来的には人間とロボットが、より自然で豊かな相互作用を行なっていくと考えています。

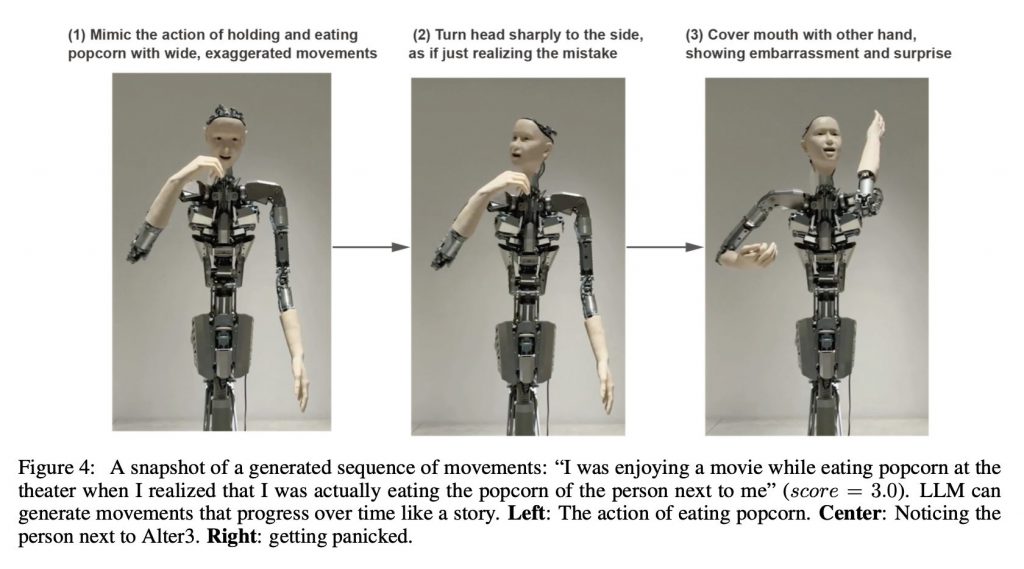

下の写真は、映画を観ながらポップコーンを食べるという状況を、Alter3がどのように演じるかを段階的に示しています。人間の行動を模倣するロボットの印象的なワンシーンです。

本記事の関連研究:仮想世界でサッカーを学んだロボットが実世界で上手にサッカーをプレイ DeepMindが研究報告

実験の内容

ロボット「Alter3」への自然言語プロンプトの指示

実験では、