DeepMindの研究チームは、現在の大規模言語モデル(LLM)は人間によって生成されたデータに過度に依存しており、LLMの発展にとって望ましい状況ではないと考えました。

この問題に対処するために、彼らはLLMが自律的に高品質な訓練データを生成し、データセットを自ら拡充する「自己学習」アプローチの有効性を検証しました。

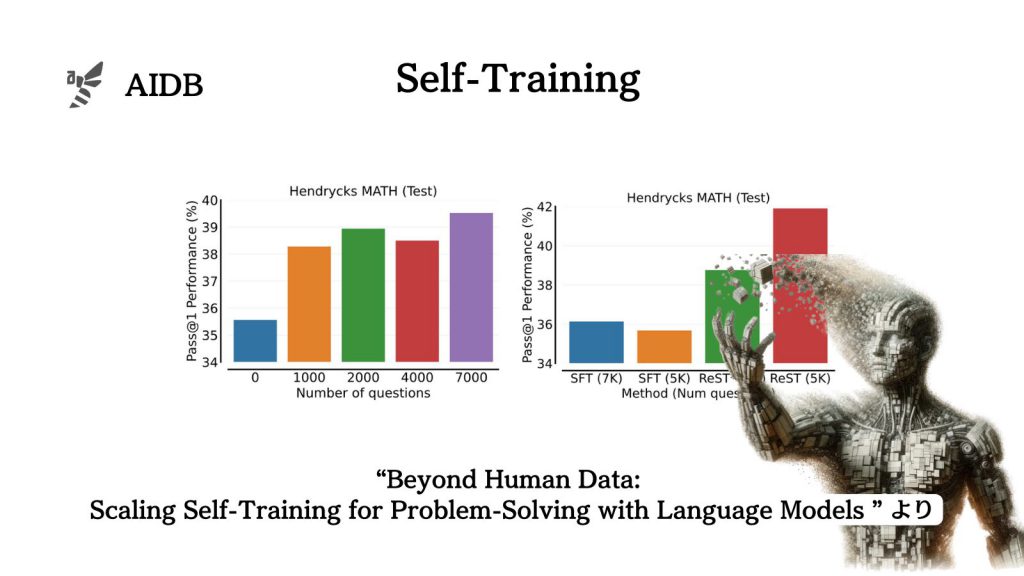

実施された実験では、自己生成データによって、数学やコード生成の分野におけるLLMの能力が顕著に向上したことが確認されました。

本記事では、研究内容を詳しく見ていきます。

参照論文情報

- タイトル:Beyond Human Data: Scaling Self-Training for Problem-Solving with Language Models

- 著者:Avi Singh et al.(多数)

- 所属:Google DeepMind

- URL:https://doi.org/10.48550/arXiv.2312.06585

自己学習の登場以前における課題

この研究の背景として、既存の言語モデルが人間生成データに依存しているゆえの限界があります。新しい学習法の必要性につながる流れです。

言語モデルの人間生成データへの依存

現状の言語モデルは、人間が生成したデータによってファインチューニングする方法が一般的なアプローチになっています。しかしこの方法では、データの量と多様性、質によってモデルの限界が決まってしまいます。

データ収集の課題

高品質な人間生成データを収集すれば問題ない(あるいは収集するのが鍵である)とも言われていますが、複雑な問題解決タスクにおいてデータ収集は大きなボトルネックとなりえます。多大なリソースと専門知識をもってしても、完全な解決に至らないことがあり、課題ははっきりしているのにプロジェクトが前に進まないといった状況に陥る恐れがあります。

そのため、仮にモデル生成データの品質が保証されれば、拡張性とコスト効率の面で有望な代替手段となりえます。

既存の自己教師あり学習法の限界

既存の自己教師あり学習法である監督されたファインチューニング(Supervised Fine-Tuning, SFT)にもネックとなる要因があります。この学習法においては、データセットから人間生成の出力に対して、負の損失を最小化することでポリシーを訓練しています。

オンライン強化学習(RL)メソッドを使用して損失を直接最適化するには、訓練中に何度もポリシーの更新とサンプリングが必要となります。しかし、新しいサンプルの連続的なフローに対するファインチューニングの計算コストは、時に大規模なポリシーネットワークでの大きな障壁になります。

そこでReST(Reinforced Self-Training)という新しい自己学習手法が台頭しています。今回、DeepMindの研究者らは、ReSTのアプローチに工夫を加え、正しさを検証しやすい分野で有効性の検証を行うことにしました。

本記事の関連研究:従来の小さなニューラルネットワークでも「メタ学習」でChatGPTを凌駕するほど高度な生成AIができるとの報告、Nature誌

今回のメインアイデア

今回紹介する研究のメインアイデアは、言語モデルが自ら高品質なデータを生成する自己学習のアプローチを工夫し、有効性を確かめることです。人間生成データへの依存を減らし、問題解決能力を向上させるための試みです。

自己学習アプローチの導入

前述したように、従来の言語モデルは、人間生成データにファインチューニングされていますが、その性能は人間データによって左右されてしまいます。

そこでDeepMindの研究者らは、まずは数学問題など正しさを検証できるタスクにおいて、人間データを超えることができるかを探求することにしました。

ReST(Reinforced Self-Training)の概要

研究者らが考案した自己学習アプローチは、モデルが自身でサンプルを生成し、これらのサンプルをスコアリングメカニズムで評価するものです。

このアプローチは期待値最大化に基づく強化学習の一種です。期待値ステップ(E-step)と最大化ステップ(M-step)を交互に行うことで達成されるとのことです。

生成(E-step):言語モデルは各入力に対して複数の出力サンプルを生成します。

改善(M-step):元の言語モデルを、前の生成ステップからのトレーニングデータセットに基づいて教師ありファインチューニングし、次の生成ステップで使用します。

ReSTの応用とその成果

ReSTは、これまでにも、機械翻訳、意味解析、好みの整合性、基本的な推論など、多様なドメインでの言語モデルの強化に成功しています。

今回は、数学的推論能力とコード生成能力の検証に用いられ、ReSTにより能力が大幅に向上したことが明らかになりました(詳細は後述します)。モデル生成データに基づいてファインチューニングされたモデルは、人間生成データに基づいてトレーニングされたモデルに比べて顕著に大きな性能向上を達成しているとのことです。

要するに、基本的なReST自体は以前から存在するアプローチですが、これまでは限定的な範囲や状況で評価されていました。しかしDeepMindのこの研究は、より広範囲の問題解決タスクでReSTの効果を示すことに成功しています。

本記事の関連研究:AGI(汎用人工知能)の原則6箇条とレベル5段階

実験された内容のまとめ

使用されたデータセット

実験は、