Google DeepMindなどの研究者たちは、GPT-4をはじめとする大規模言語モデル(LLM)がタスクごとに適切な推論プロセスを自ら考えることができるようにするプロンプト手法を開発しました。

実験では従来の方法と比較して最大42%の性能向上が確認され、計算コストも10〜40倍削減されることが示されました。

参照論文情報

- タイトル:Self-Discover: Large Language Models Self-Compose Reasoning Structures

- 著者:Pei Zhou, Jay Pujara, Xiang Ren, Xinyun Chen, Heng-Tze Cheng, Quoc V. Le, Ed H. Chi, Denny Zhou, Swaroop Mishra, Huaixiu Steven Zheng

- 所属:University of Southern California, Google DeepMind

背景

LLMで複雑な問題解決を行うことがますます期待されており、推論能力を高めるアプローチが求められています。

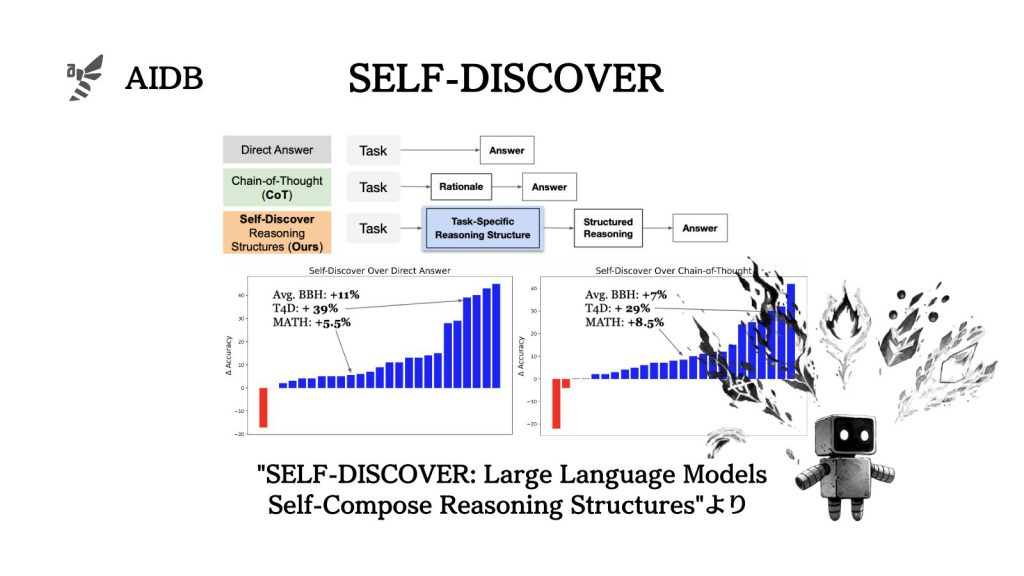

そこで、様々なプロンプト手法が提案されてきました。これまでの研究では、人間が問題を解決する際のステップバイステップのアプローチや、複雑な問題をサブ問題に分解して解決するプロセスなどに注目が集まってきました。しかし各タスクにおける前提に細かく対応しているわけではありません。つまり、タスク固有の推論構造を見落とす傾向がありました。

このような背景から、各タスクに特有の推論構造を自己発見して効率的に問題を解決する新たなアプローチが必要とされていました。

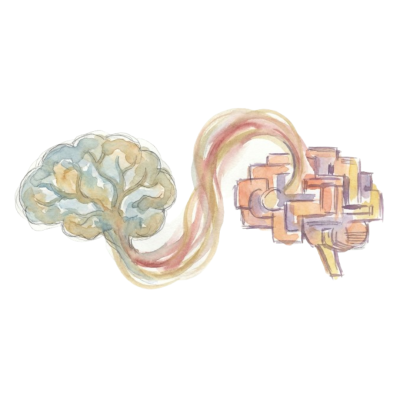

そこでGoogle DeepMindなどの研究者らは、ニーズに応えるためにSELF-DISCOVERという手法を考案しました。本手法は、LLMが自ら推論プログラムを内部で構築し、問題を解決するプロセスを辿るものです。人間が新しい問題に直面したときに過去の知識や経験を活用して解決策を導き出すプロセスに触発されて考案しています。

実験ではその性能が多角的に確かめられています。

下記では方法論と実験結果を見ていきます。

方法論

SELF-DISCOVERの具体的な手順は以下のように2つの段階に分けられます。