本記事では、AIによる情報取得だけを対象にWebページの内容を守る手法を紹介します。

一般的な手法では、LLMによるリアルタイムな情報再利用への完全な対応が難しい。一方で、Webの公開性は維持したい。そうした際の手段を持つ必要があります。

AIによりコンテンツを再構成されてしまうこと、無断引用への対処を設計レベルで考える試みです。

現代の情報設計を考えるうえで、応用の幅を持つアプローチとして検討する価値があります。

背景

生成AI、LLMを活用したサービスは、情報検索や文章生成の手段として広く使われるようになってきました。質問に答えてくれる精度も高く、もはやWebサイトを自分で訪れて調べ直す機会は減ってきた、と感じている方も多いかもしれません。

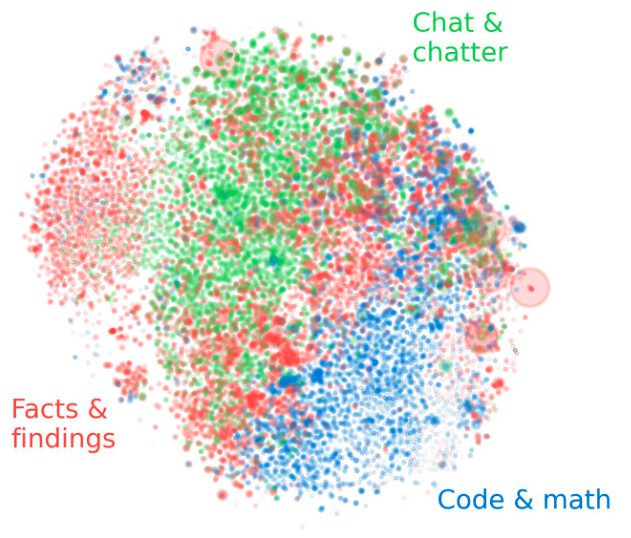

しかし、その利便性の裏では、コンテンツの作り手にとって看過できない問題が浮かび上がっています。LLMはWeb検索を通じて最新の情報を取り込み、それを使って回答を生成する機能を持つようになっています。つまり、誰かが書いた記事やWebページが、ユーザーの目に触れないままLLMの回答に反映されているという状況が発生しています。

この仕組みでは、元のコンテンツが誰によって作られたのかが見えなくなり、Webサイトの訪問数も伸びにくくなります。情報提供の努力が報われず、長期的には独自の視点や専門性をもつ発信者の減少にもつながりかねません。とくに、個人や小規模な組織によるコンテンツは、知らぬ間に抽出・再配信されやすい傾向にあり、大手と比べて防御手段が限られているという課題もあります。

これまでの防御策としては、robots.txtでクローラーを拒否したり、問題が起きてから通報するしかないというのが一般的でした。しかし、リアルタイムでユーザーの問いに応じてWebを参照するLLMに対しては、こうした方法では効果が不十分であることがわかってきました。

そこで研究者たちは、Webコンテンツの制作者自身が能動的に守りの手段を持てるような防御策のあり方を模索しています。LLM時代の情報公開を見据えた構造設計と言えます。

以下で詳しく紹介します。