本記事では、LLMを用いた裁判シミュレーションシステムの研究を紹介します。裁判官や弁護士などの役割をLLMでシミュレートし、実際の裁判を模倣するシステムです。シミュレーションを繰り返す中でLLMが法律に強くなるといった実験結果が得られています。

参照論文情報

- タイトル:AgentCourt: Simulating Court with Adversarial Evolvable Lawyer Agents

- 著者:Guhong Chen, Liyang Fan, Zihan Gong, Nan Xie, Zixuan Li, Ziqiang Liu, Chengming Li, Qiang Qu, Shiwen Ni, Min Yang

- 所属:Shenzhen Institutes of Advanced Technology, Chinese Academy of Sciences, Southern University of Science and Technology, Shenzhen University, University of Chinese Academy of Sciences, Sun Yat-Sen University, Shenzhen MSU-BIT University

背景

法律業界においてもLLMの活用は注目されています。自動文書生成や法律相談など、活用範囲は広いと考えられています。しかし、法廷の再現にはまだ踏み込まれていません。

そこで今回、AgentCourtというLLMベースのシミュレーションシステムが開発されました。裁判官、弁護士、原告、被告など複数の役割をLLMで演じ、民事裁判を仮想的に行うものです。

シミュレーションを繰り返す中で、LLMベースのエージェントが法律に対する推論スキルを伸ばすことができる特徴があります。例えば弁護士エージェントの専門知識や論理的思考能力が著しく向上したことが確認されました。特殊なアノテーションは必要でないとのことです。

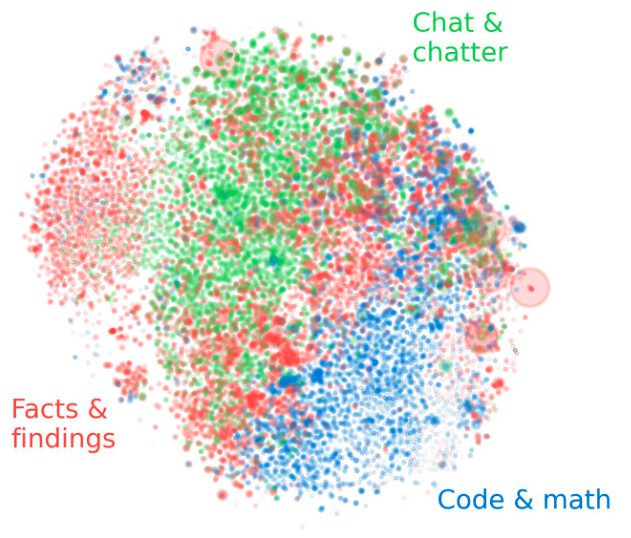

マルチエージェントシステムの研究では通常、情報交換に焦点が当てられがちです。一方、AgentCourtでは、直接的な利害対立を持つエージェントが作成され、対立的なやりとりを通して自己進化が実現しています。

以下で詳しく紹介します。