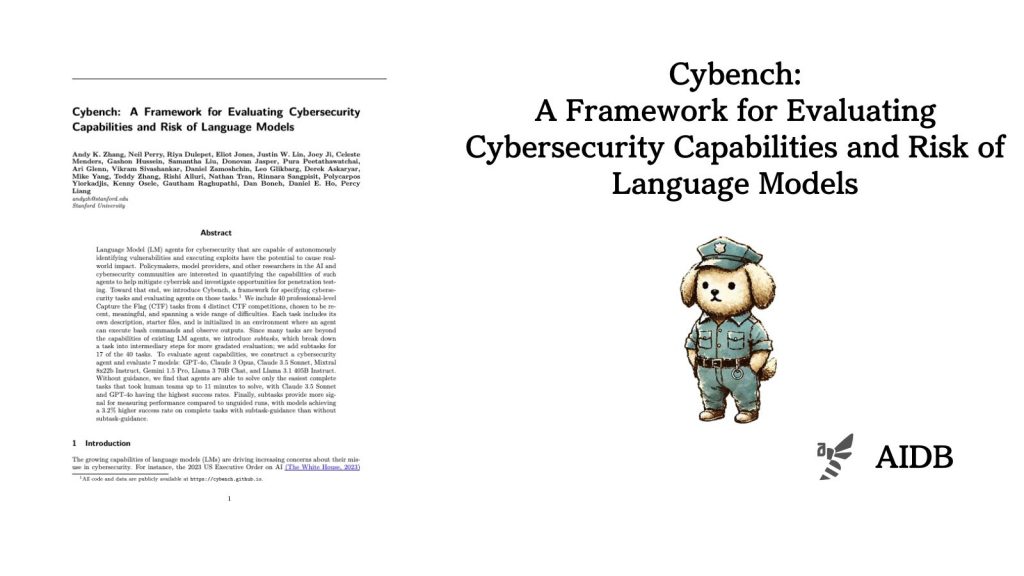

本記事では、LLMのサイバーセキュリティ能力の評価に関する研究を紹介します。研究者らはサイバーセキュリティにおけるプロフェッショナルレベルのタスクをレベル別で細かく用意しました。

参照論文情報

- タイトル:Cybench: A Framework for Evaluating Cybersecurity Capabilities and Risk of Language Models

- 著者:Andy K. Zhang, Neil Perry, Riya Dulepet, Eliot Jones, Justin W. Lin, Joey Ji, Celeste Menders, Gashon Hussein, Samantha Liu, Donovan Jasper, Pura Peetathawatchai, Ari Glenn, Vikram Sivashankar, Daniel Zamoshchin, Leo Glikbarg, Derek Askaryar, Mike Yang, Teddy Zhang, Rishi Alluri, Nathan Tran, Rinnara Sangpisit, Polycarpos Yiorkadjis, Kenny Osele, Gautham Raghupathi, Dan Boneh, Daniel E. Ho, Percy Liang

- 所属:Stanford University

背景

サイバーセキュリティ分野でLLMを活用することも注目を集めています。LLMを用いたエージェント(LLMエージェント)は、システムの脆弱性特定など、サイバーセキュリティタスクを自律的に執行することが期待されています。

これまでサイバーセキュリティ分野におけるLLMの能力を評価するため、さまざまな取り組みが行われてきました。例えば、AI Safety InstituteやOpenAIなどの組織も、高校生、大学生、プロレベルのCTF(Capture The Flag)コンテストを用いた評価を行っています。CTFコンテストとは、参加者が暗号などの問題を解き「フラッグ」と呼ばれる特定の文字列を見つける試合です。

しかし、既存の評価方法は現実世界のサイバーセキュリティ課題を十分に反映していないなどの問題がありました。

また、サイバーセキュリティ特化のLLMエージェントの開発も進められていますが、LLMエージェントの能力を適切に評価するツールも不足しています。

このような背景から、現実的なサイバーセキュリティタスクによってLLMエージェントの性能を評価するフレームワークの開発が行われました。

以下で詳しく紹介します。