LLMをファインチューニングしたとき、幻覚(ハルシネーション)誤った情報の生成にはどう影響するのかが調査されました。指示に従うタスクや人間のフィードバックを通じて、望ましい行動をとるように調整することを「微調整」または「ファインチューニング」と呼びます。

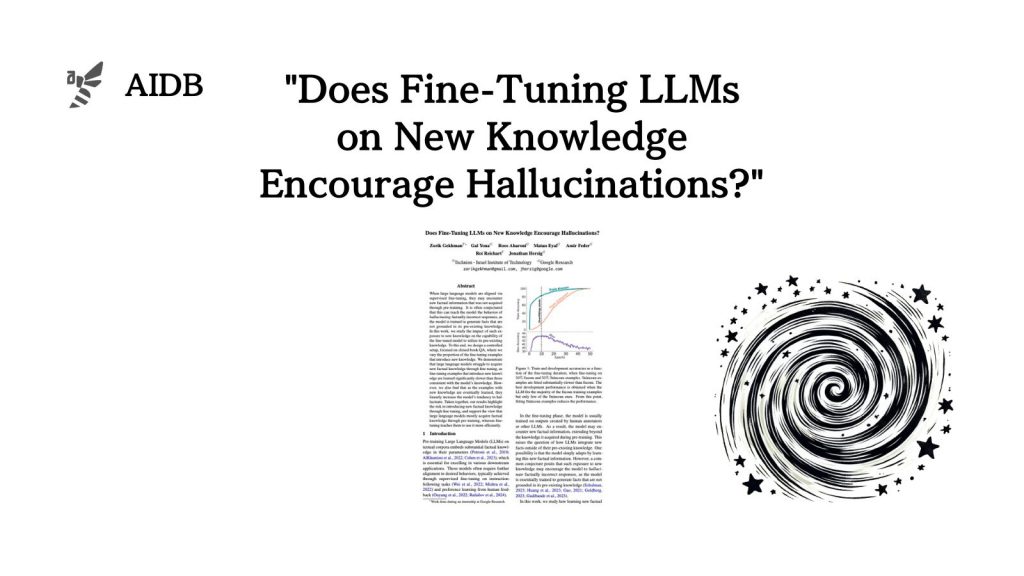

参照論文情報

- タイトル:Does Fine-Tuning LLMs on New Knowledge Encourage Hallucinations?

- 著者:Zorik Gekhman, Gal Yona, Roee Aharoni, Matan Eyal, Amir Feder, Roi Reichart, Jonathan Herzig

- 所属:Technion – Israel Institute of Technology, Google Research

背景

モデルは微調整中に新しい事実に遭遇することがあります。そして、新しい知識に触れることが、いわゆる「ハルシネーション」を引き起こす可能性があると考えられています。モデルが事実とは異なる誤った応答を生成する現象です。

事前学習においては知識を効果的に利用する方法を学びますが、微調整を通じて新しい知識を取得するのは難しいのではないかと議論されていますが、明確な答えは出ていません。

そこで今回研究者らは、新しい知識がLLMの性能に与える影響を詳細に調査することにしました。