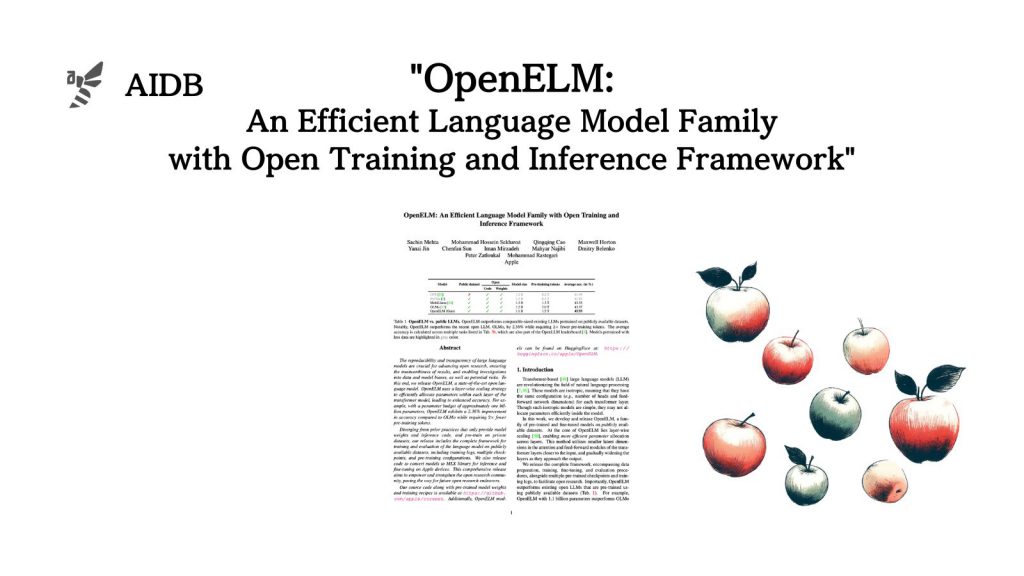

Appleが公開した最新のオープンソース小型LLMに関する研究を紹介します。

OpenELMは、layer-wise scalingと呼ばれる手法を用いることで、限られたパラメータ数でも高い性能を達成しています。また、事前学習に使用したデータセットや学習の詳細、評価方法なども公開されており、透明性の高い研究となっています。

本記事では、OpenELMの特徴的なアーキテクチャ、事前学習の内容、評価実験の結果などを詳しく見ていきます。さらに、OpenELMをiPhoneやiPadなどのApple製品上で動作させるためのMLXライブラリへの変換手法についても触れていきます。

参照論文情報

- タイトル:OpenELM: An Efficient Language Model Family with Open Training and Inference Framework

- 著者:Sachin Mehta, Mohammad Hossein Sekhavat, Qingqing Cao, Maxwell Horton, Yanzi Jin, Chenfan Sun, Iman Mirzadeh, Mahyar Najibi, Dmitry Belenko, Peter Zatloukal, Mohammad Rastegari

- 所属:Apple

背景

これまで、AppleがAIモデルをオープンに公開することはほとんどありませんでした。しかしこの度スタンスを一気に変え、オープンソースLLMの「OpenELM」を公開しました。Appleは今回の公開の目的を「オープンな研究コミュニティを支援し、発展させること」としています。

今回のリリースでは、以下のサイズのOpenELMが公開されました。

- 270M

- 450M

- 1.1B

- 3B

モデルは非常に軽量であり、iPhoneやiPad上でも動作できるとのことです。OpenELMは軽量でありながら、同程度のサイズのオープンLLMと比較して、高性能であることが分かります。

加えて、OpenELMをiPhoneやiPadなどのApple製品のローカル上で実行させるための「MLXライブラリへの変換コード」も公開されており、これを使うことでiPhoneやMac上でOpenELMを実行できます。

さらに、透明性を維持するために、OpenELMの学習にはおよそ1.8兆トークンのオープンデータが用いられ、学習スクリプトやログ等も公開されています。

次のセクションでは、OpenELMの具体的な構造を詳しく解説します。