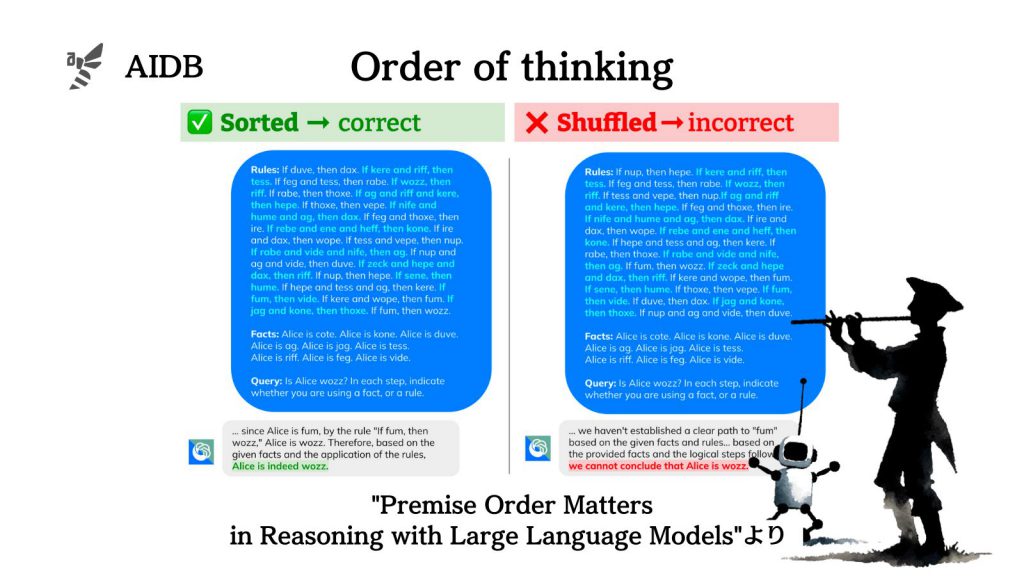

大規模言語モデル(LLM)は文章の並び順に影響されやすいといった意外な弱点があります。

例えば推論タスクでは、前提を論理の構造と同じ順番で提示することでモデルの精度が大幅に向上することがわかっています。

今回Google DeepMindの研究者らは、この「前提の順序」による影響を様々なLLMで検証しました。

参照論文情報

- タイトル:Premise Order Matters in Reasoning with Large Language Models

- 著者:Xinyun Chen, Ryan A. Chi, Xuezhi Wang, Denny Zhou

- 所属:Google DeepMind, Stanford University

背景

LLMは人間のような認知バイアスに沿ったエラーを起こすことがあることが知られています。

例えば、「AはBに含まれる」 という情報で学習したLLMは「BはAを含む」と推測できない現象が報告されています。(〇〇さんの父親は××さんである、という事実から××さんの息子は〇〇さんであることが分からないといったケース。参考:GPT-4などのLLMが「AはB」から「BはA」を導かない『逆転の呪い』における誤解なき解釈と対策)

また、タスクの説明に無関係な文脈が含まれると、LLMの性能が大きく低下する傾向もあります。

そんな背景を踏まえて、Google DeepMindの研究者らは、LLMの推論能力に及ぼす「前提の順序」の影響を調べることにしました。

本来は演繹的な推論では、前提となる文の順序を変えても結論は変わりません。次の例を考えてみましょう。

- AならばBである

- BならばCである

- Aは真である

上記の3つの前提は順番を入れ替えても、いずれの場合も「Cは真」と結論できます。しかし、LLMは与えられる前提の順序に左右される性質があり、証明文と同じ順番で前提文が並んでいる場合に最良の結果を出します。

このような順序へのこだわりは、もともとは人間の思考傾向にもあるものです。私たち人間も、前提を一つずつ確認しながら逐次的に結論を導けるため、順番通りの文章を好む傾向にあります。このことは人間を対象とした実験が過去に行われて示されています。

研究者らはこの「前提の順序」による影響を、GPT-4-turbo、GPT-3.5-turbo、PaLM 2-L、Gemini Proなど最新のLLMを使って体系的に調査しました。

以下で詳細を紹介します。