知識は常に変化するため、どんなにLLMの知識を拡張しようと、欠落や古くなった情報が残ってしまう可能性があります。

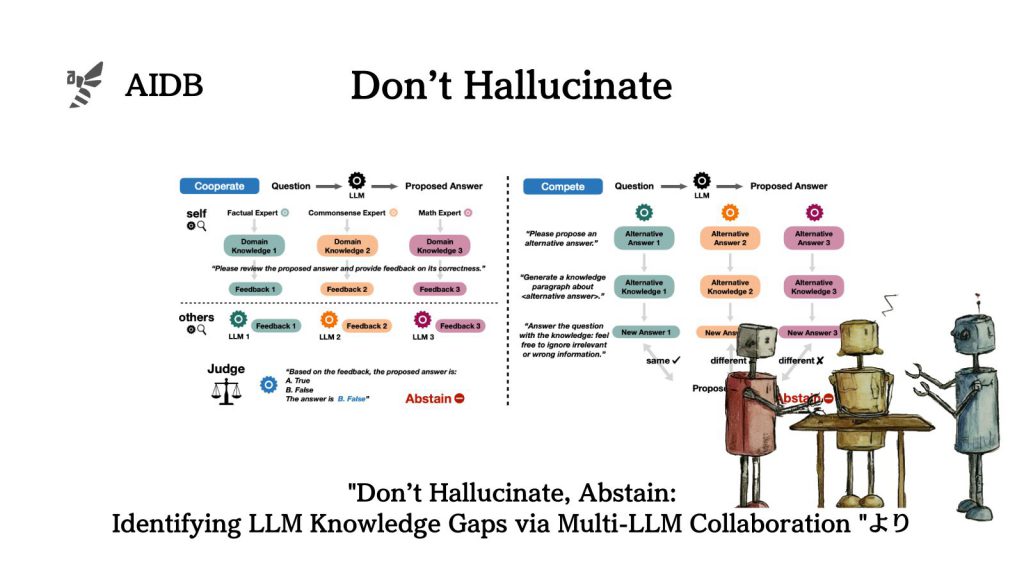

既存手法は自己分析能力に欠け、データセットへの過度の依存があることから、今回ワシントン大学やUCバークレーなどの研究者らはLLM同士が互いの知識を検証する手法を提案しました。

3つのLLM、4つの質問応答タスクで実施した実験により、ベースラインに対して最大19.3%の精度向上を確認しました。

参照論文情報

- タイトル:Don’t Hallucinate, Abstain: Identifying LLM Knowledge Gaps via Multi-LLM Collaboration

- 著者:Shangbin Feng, Weijia Shi, Yike Wang, Wenxuan Ding, Vidhisha Balachandran, Yulia Tsvetkov

- 所属:ワシントン大学, カリフォルニア大学バークレー校, 香港科技大学, カーネギーメロン大学

背景

LLMは膨大な知識を保有していますが、知識が欠落していたりそもそも不正確な場合、誤った回答を生成してしまう恐れがあります。そんな事態を防ぐため、信頼度の低い回答は控える機能が必要だという見方があります。

そこで課題は、LLMが自身の知識不足をどのように特定できるのか、ということです。

既存の手法は、多くの場合、外部データや、LLMが自身を客観的に評価できるという仮定に依存しており、必ずしも正確な判断ができない場合があります。

中でも、「単一のLLMが自分自身の回答を客観的に見直して誤りを正せる」といった考えは過度な期待に基づくものだと研究者らは指摘しています。

そこで今回、複数のLLMによって回答を客観視し、信頼性が低いときには回答を控えさせる手法が提案されています。誤解を招く情報生成を避けることで、システムの実用性を上げることにつながる手法です。

以下で詳しく紹介します。