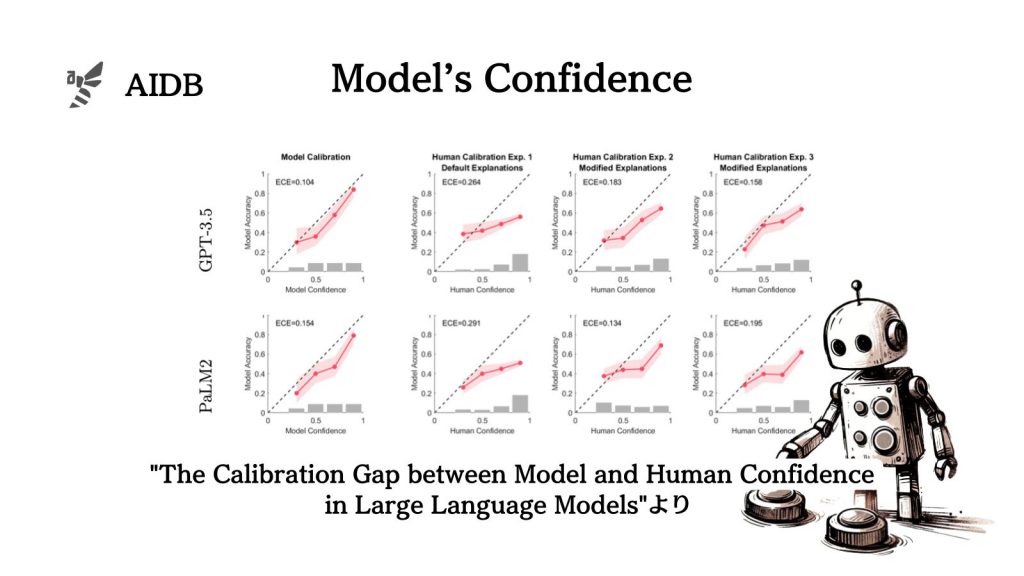

人間はLLMによる説明の正確さを過大評価する傾向がある(つまり信頼しすぎてしまう)ことが問題になっています。

そこで研究者らは、LLMに「自信の度合いに応じて説明のニュアンスを変更させる」アプローチの有効性を実証しています。

カリフォルニア大学のコンピュータサイエンスと認知科学で構成された研究グループによる報告です。

参照論文情報

- タイトル:The Calibration Gap between Model and Human Confidence in Large Language Models

- 著者:Mark Steyvers, Heliodoro Tejeda, Aakriti Kumar, Catarina Belem, Sheer Karny, Xinyue Hu, Lukas Mayer, Padhraic Smyth

- 機関:カリフォルニア大学アーバイン校

LLMの自信とユーザーからの信頼にギャップがある

LLMは、説得力のある出力を生成しますが、実際には不正確なもの、あるいは不明瞭な情報を含む場合があります。この点が、実用における懸念の一つとなっています。

実際にOpenAIなどLLMの開発会社からも、モデルの出力を手放しには受け入れないように注意喚起されています。現状は、モデルが常に100%の自信をもってユーザーの質問に対応しているわけではないということです。

一方で最近の研究では、LLMは自分の知識の限界をある程度識別する能力があることが示されています。

例えば複数選択問題において、モデルが自身の回答の正解確率がどれほどであるかを自ら答えられることが検証されています。

また、回答可能な質問と回答不可能な質問を区別できることや、内部状態が真実と嘘を区別できることが示されています。

これらの従来研究から、「LLMは自分の認識をある程度内部で反省することができるのではないか」という仮説が立てられています。

しかし、実際の質問応答シーンでは、ユーザーの目の前に提示されるモデルからの回答において、情報に対する自身の度合いは一般的に表示されていません。

では、LLMの出力に対して人間はどの程度信頼を寄せているのでしょうか?

研究者らは、LLMが実際に認識している自身の出力に対する自信の度合いと、ユーザーが感じている信頼性の間にあるギャップに着目しました。

そして、下記2つの研究テーマを設定しました。

- LLMの自信と人間の信頼性の間にあるギャップはどのくらい大きいか?

- ギャップを小さくすることはできるか?

具体的な取り組みとその結果を以下で紹介します。