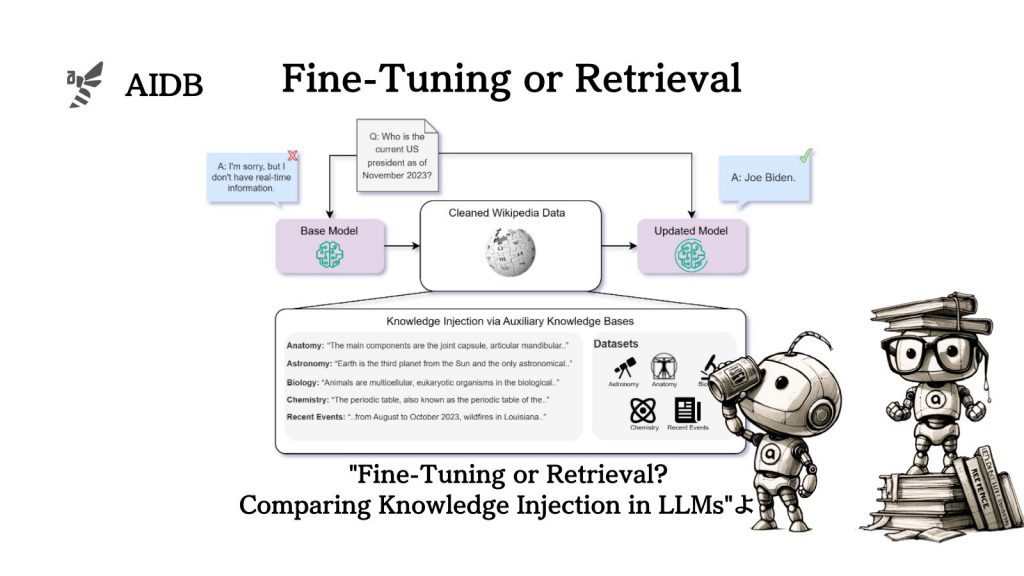

Microsoftの研究者が、LLMに外部知識を取り入れる2つの手法としてのファインチューニングとRAGを比較した実験結果を報告しています。

大まかな結論としては、ファインチューニングよりもRAGは一貫して効果的と考えられるとのことです。

ただし、選定や実装はデータやアプリケーションに大きく依存します。

参照情報:

- 論文タイトル:Fine-Tuning or Retrieval? Comparing Knowledge Injection in LLMs

- 機関:Microsoft Israel

- 著者:Oded Ovadia, Menachem Brief, Moshik Mishaeli, Oren Elisha

- URL:https://doi.org/10.48550/arXiv.2312.05934

研究背景

LLMが持つ情報はモデルの訓練データに依存しています。モデルが最新の情報や、特定の専門知識を必要とする場合に、情報をどのように学ぶかが非常に重要な課題になってきています。

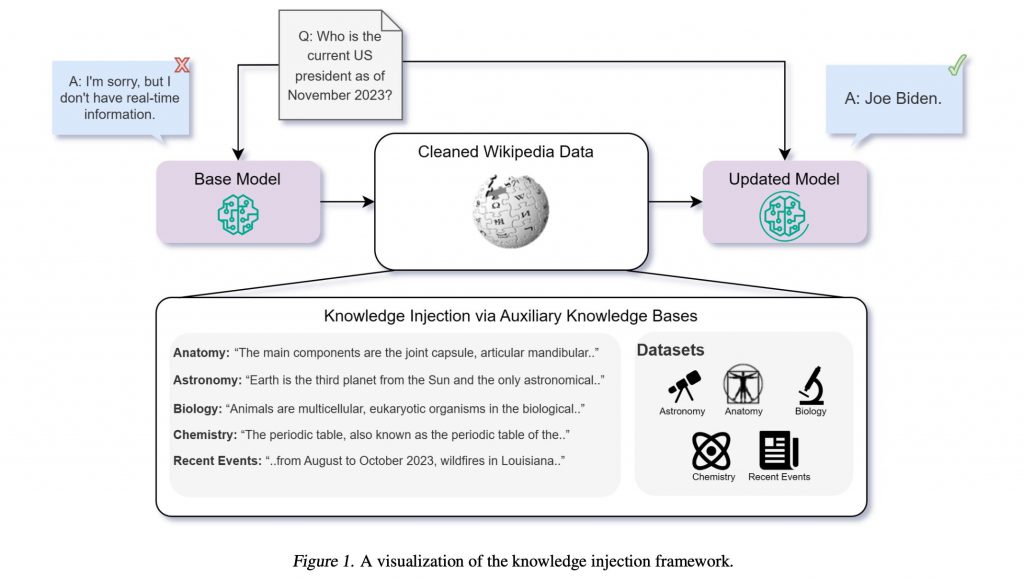

LLMに新しい情報を注入する方法としては、主に「ファインチューニング」と「RAG」の二つがあります。ファインチューニングは、モデルを特定のタスクやデータセットに対して再訓練する手法です。一方、RAGは、モデルが回答を生成する際に外部のデータベースや情報源を参照する手法です。

実用的にLLMを使用するには、内部の情報が必然的に古くなっていくこと、特定の専門分野の知識が不足すること、そしてそれらに対処するための新しい情報の学習が困難であるという問題があります。現実世界にモデルで対応するためには、定期的な更新や適応のためのノウハウが求められています。

そこでMicrosoftの研究者らは、LLMに最新の情報を効率的に注入する方法としてファインチューニングとRAGの効果を比較し、どちらがLLMに新知識を学ばせるのにより効果的かを調査しました。

以下で詳しく紹介します。