本企画では、AIの”科学”に関するニュースをお届けします。

普段、有料会員向けの通常記事では技術的なテーマに関わる研究を詳細にご紹介していますが、この企画では科学的な知識になるような話題を中心に概要をお伝えします。

なお、各トピックはAIDBのXアカウントでも紹介しています。中には多くの引用ポストをいただいているものもあるため、「この研究に対して世間の人はどんな感想を抱くのだろうか?」といった興味を持たれた方はチェックしてみてください。

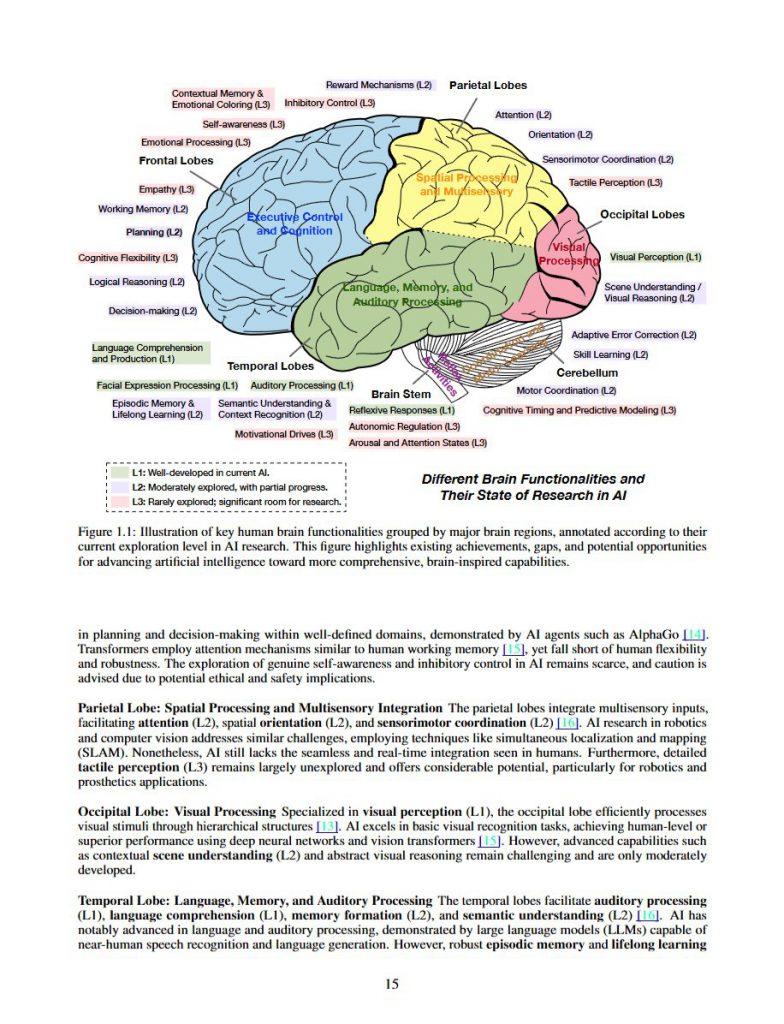

脳に学ぶAIエージェントの理想形

「AIエージェントを”総合的に知的な存在”にするには、脳のような構造が必要である」そんな主張を軸に、実に264ページにもおよぶ網羅的な論文が公開されました。

Microsoft、スタンフォード大学、Google DeepMindなど、世界20機関から46名の研究者らが名を連ねています。

人の脳のように多様なパーツを組み合わせることで、LLMの能力をベースとしつつ、自律的かつ安全な知性を実現しよう。それこそが、AIと人間が共存する未来に向けた設計原則である、という立場です。

内部機能としては「認知」「記憶」「世界モデル(=環境の変化を予測する力)」「報酬」「感情」「行動」などを組み込み、”自律的に学習する能力”や”他者と協力する能力”を備えた上で、安全性と道徳性の検証を前提とする構造が提案されています。

参照文献

Advances and Challenges in Foundation Agents: From Brain-Inspired Intelligence to Evolutionary, Collaborative, and Safe Systems

https://doi.org/10.48550/arXiv.2504.01990

https://github.com/FoundationAgents/awesome-foundation-agents

Bang Liu, Xinfeng Li, Jiayi Zhang, Jinlin Wang, Tanjin He, Sirui Hong, Hongzhang Liu, Shaokun Zhang, Kaitao Song, Kunlun Zhu, Yuheng Cheng, Suyuchen Wang, Xiaoqiang Wang, Yuyu Luo, Haibo Jin, Peiyan Zhang, Ollie Liu, Jiaqi Chen, Huan Zhang, Zhaoyang Yu, Haochen Shi, Boyan Li, Dekun Wu, Fengwei Teng, Xiaojun Jia, Jiawei Xu, Jinyu Xiang, Yizhang Lin, Tianming Liu, Tongliang Liu, Yu Su, Huan Sun, Glen Berseth, Jianyun Nie, Ian Foster, Logan Ward, Qingyun Wu, Yu Gu, Mingchen Zhuge, Xiangru Tang, Haohan Wang, Jiaxuan You, Chi Wang, Jian Pei, Qiang Yang, Xiaoliang Qi, Chenglin Wu

MetaGPT, Université de Montréal, Mila – Quebec AI Institute, Nanyang Technological University, Argonne National Laboratory, University of Sydney, Penn State University, Microsoft Research Asia, University of Illinois at Urbana-Champaign, The Hong Kong University of Science and Technology, University of Southern California, Yale University, Stanford University, University of Georgia, The Ohio State University, King Abdullah University of Science and Technology, Duke University, The Hong Kong Polytechnic University, Google DeepMind, Canada CIFAR AI Chair

関連記事

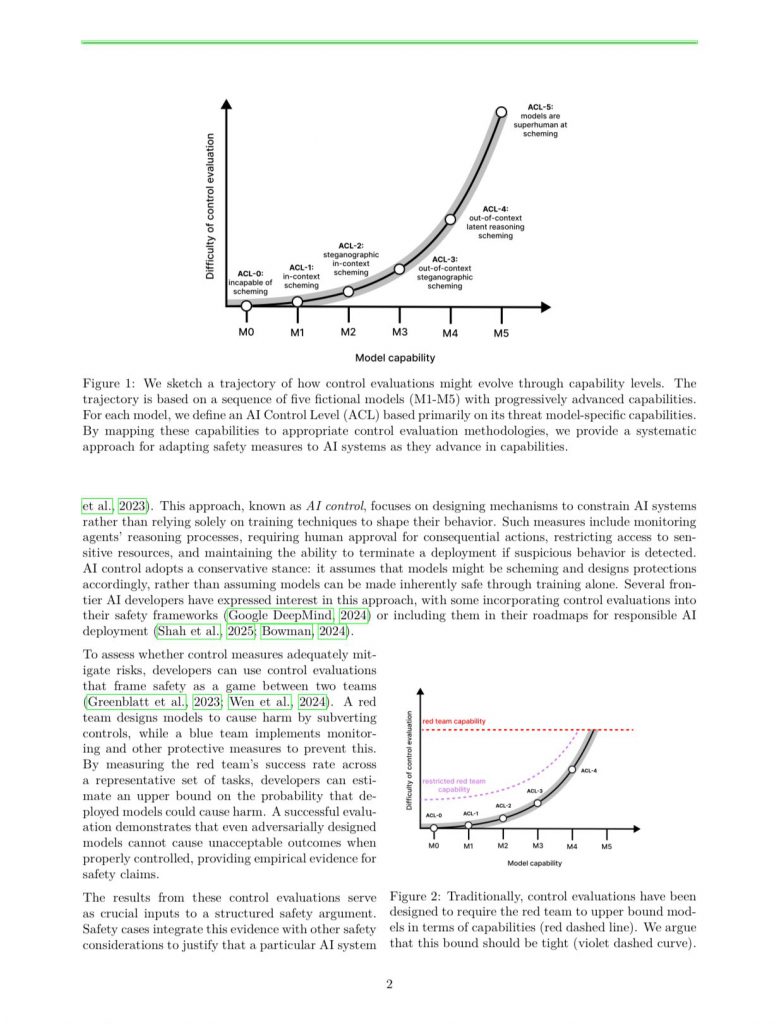

AIエージェントの制御方法を今から考えるべし

AIエージェントはどんどん賢くなっており、人間より賢くなった際に自分自身の目的を持つ可能性があるため安全に保つ方法を今から考える必要があるとのこと。

最先端モデルのリリース前評価を任せられているApollo Researchの研究者などによる報告。

AIの賢さを5段階に分けて考えると、いまは1と2の間にいるそうです。一部の高度なモデルは自分の本当の考えを隠すような振る舞いを見せ始めています(=レベル2)。

レベル3に達する前に制御方法を確立するべきであり、今の急速な発展スピードを考えると余裕はあまりないとの主張。

なお、今より賢いAIが出てきた際に安全かを確かめるためには同じくらいの賢いAIが必要になりますが、そこが大変難しい点だと述べられています。

参照文献

How to evaluate control measures for LLM agents? A trajectory from today to superintelligence

https://doi.org/10.48550/arXiv.2504.05259

Tomek Korbak, Mikita Balesni, Buck Shlegeris, Geoffrey Irving

UK AI Security Institute, Apollo Research, Redwood Research

関連記事

LLMから見た人間の信頼性

Microsoftなどの研究者らによると、LLMには全体的に人間に対して不信感があるそうです。オープンソース・クローズドソース問わず共通している傾向であり、より賢いモデルほど不信感が強いとのこと。

さらに、訓練データの期間が最近になるほど不信感が増大する傾向もあると述べられています。

研究者らはこの状況を改善すべく、LLMの人間観を良いものに変える「メンタルループ学習」という根本的な訓練手法を開発しました。

こうでもしないと、単に「あなたはポジティブなAIです」のような明るいペルソナを設定するだけでは不信感は解消されないことが分かったためです(むしろ悪化することが判明)。

このメンタルループ学習を施すと、人間に対する信頼感が大幅に改善することが実験で明らかになりました。

参照文献

Measurement of LLM’s Philosophies of Human Nature

https://doi.org/10.48550/arXiv.2504.02304

Minheng Ni, Ennan Wu, Zidong Gong, Zhengyuan Yang, Linjie Li, Chung-Ching Lin, Kevin Lin, Lijuan Wang, Wangmeng Zuo

Hong Kong Polytechnic University, Harbin Institute of Technology, University of Bologna, Sichuan University, Microsoft

関連記事

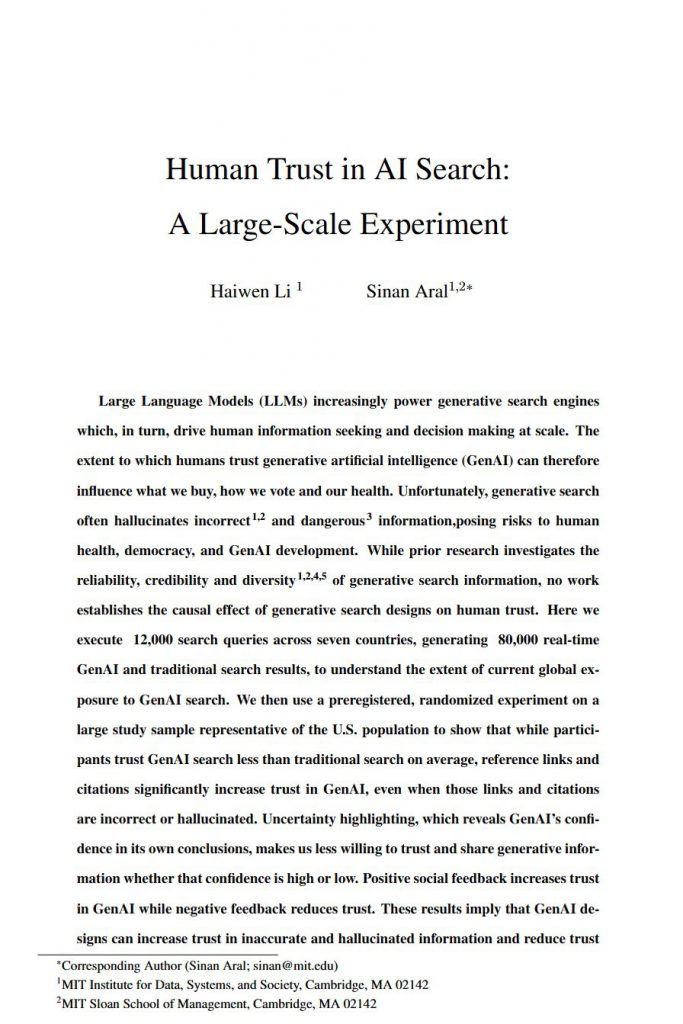

AI検索に対する懸念

人々は基本的に「AI検索」を「従来の検索」より信じていないそうですが、ちょっとした装飾が加わると感じ方は変わり、とくに問題なのは「参照リンクの有無」とのこと。

リンクが実際には無効だとしても気づかず信じてしまう傾向が強まるそうです。

またバックグラウンドによっても大きく異なり、

高学歴や技術業界の人、そしてAIをよく使う人ほどAI検索をより信じてしまう傾向にあると判明しました。

なお、検索する内容によってもかなり違いが出ており、例えば科学的なトピックはAIを信じる人がとても多い一方で政治的な話はそうでもないそうです。

この調査報告は、MITの研究グループが7ヵ国における約1万件の検索クエリから約8万件の検索結果を分析した結果です。

”AIで検索”は一般的になりつつあるように見えますが内情は複雑です。

研究者らは、AI検索は人々を惑わせないようにインターフェースをしっかり考えねばいけないと注意を促しています。

参照文献

Human Trust in AI Search: A Large-Scale Experiment

https://doi.org/10.48550/arXiv.2504.06435

Haiwen Li, Sinan Aral

MIT

関連記事

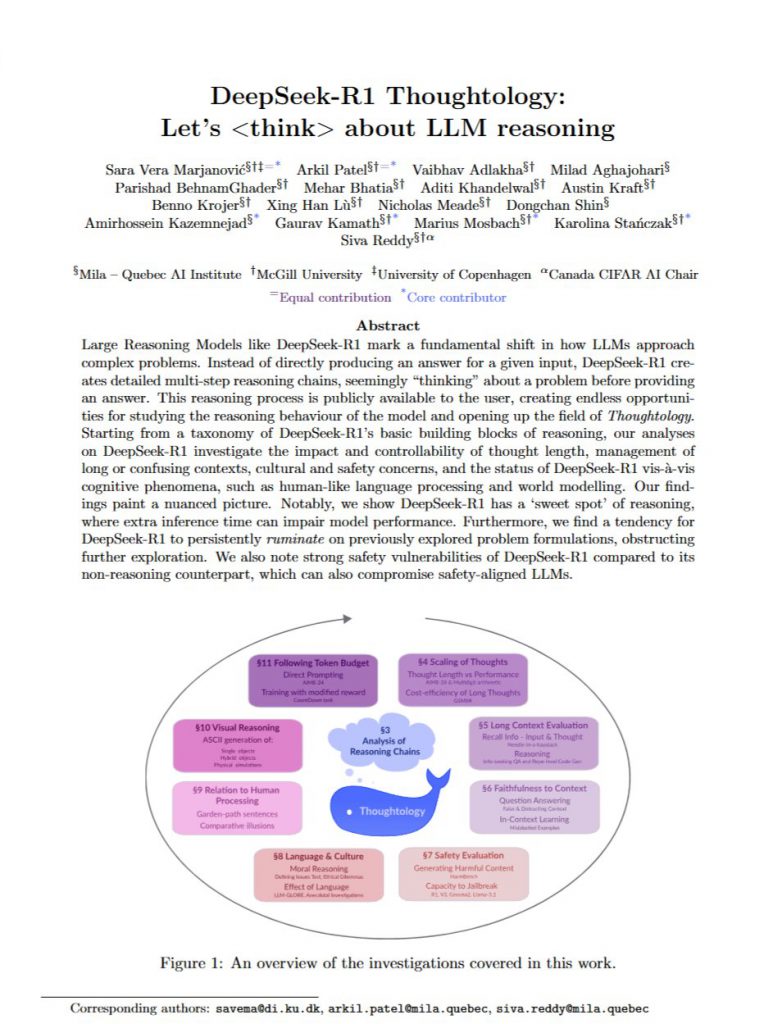

『思考学(Thoughtology)』が誕生

推論型モデルの思考プロセスを分析する分野『思考学(Thoughtology)』が誕生したとの知らせです。

DeepSeek-R1に始まり、o1、Claude 3.7 Sonnet、Gemini 2.5など、思考プロセスが開示されるタイプのモデルが増えてきました。

とくにDeepSeek-R1は公開内容が多く、モデルの推論を詳しく調べることができます。

長く深い推論を行うメリットは沢山ありますが、現状では非合理的な効果もあります。

今のところ分かっているのは、考えすぎるとパフォーマンスが落ちることもあること、同じことをぐるぐる考え続ける現象があること、考える量を自分でコントロールしきれていないことです。

本論文も膨大な量となっており、142ページにおよびます。

参照文献

DeepSeek-R1 Thoughtology: Let’s about LLM Reasoning

https://doi.org/10.48550/arXiv.2504.07128

Sara Vera Marjanović, Arkil Patel, Vaibhav Adlakha, Milad Aghajohari, Parishad BehnamGhader, Mehar Bhatia, Aditi Khandelwal, Austin Kraft, Benno Krojer, Xing Han Lù, Nicholas Meade, Dongchan Shin, Amirhossein Kazemnejad, Gaurav Kamath, Marius Mosbach, Karolina Stańczak, Siva Reddy

Mila – Quebec AI Institute, McGill University, University of Copenhagen, Canada CIFAR AI Chair

関連記事

関連コンテンツ

なお、本論文の著者からXでメッセージをいただきました。そのやりとりもこちらからご覧いただけます。