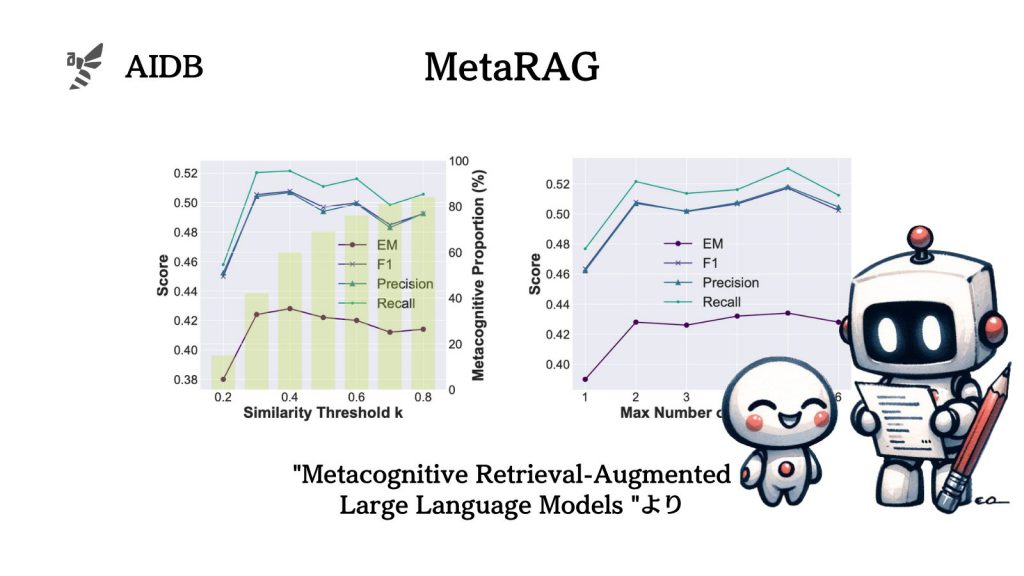

メタ認知をRAGに応用し、回答の品質がいまいちだとLLMが認識した際に検索を繰り返すアプローチの有効性が検証されました。

実験の結果、通常のRAGよりも大幅に精度が高い回答が一貫して得られると述べられています。

今回の条件下では5回反復した時に最高精度になったとのことです。

参照論文情報

- タイトル:Metacognitive Retrieval-Augmented Large Language Models

- URL:https://doi.org/10.48550/arXiv.2402.11626

- 機関:Renmin University, Beijing Academy of Artificial Intelligence, University de Montreal

- 著者:Yujia Zhou, Zheng Liu, Jiajie Jin, Jian-Yun Nie, Zhicheng Dou

背景

LLMは時として事実と異なる内容を生成してしまうことがあります(ハルシネーションや幻覚と言われています)。この問題を解決するために考案されたのが、LLMと検索システムを組み合わせる方法(RAG)です。

RAGは、1回の検索で知識を取り出す方式が一般的です。しかし1回きりの検索は単純な情報ニーズには効果的でも、複雑なタスクには不向きという弱点があると考えられています。

そこで、必要に応じて複数回の検索を行う方法が注目され始めています。ただし、これまで試されてきた方法は回答の誤りを診断する能力に欠けています。

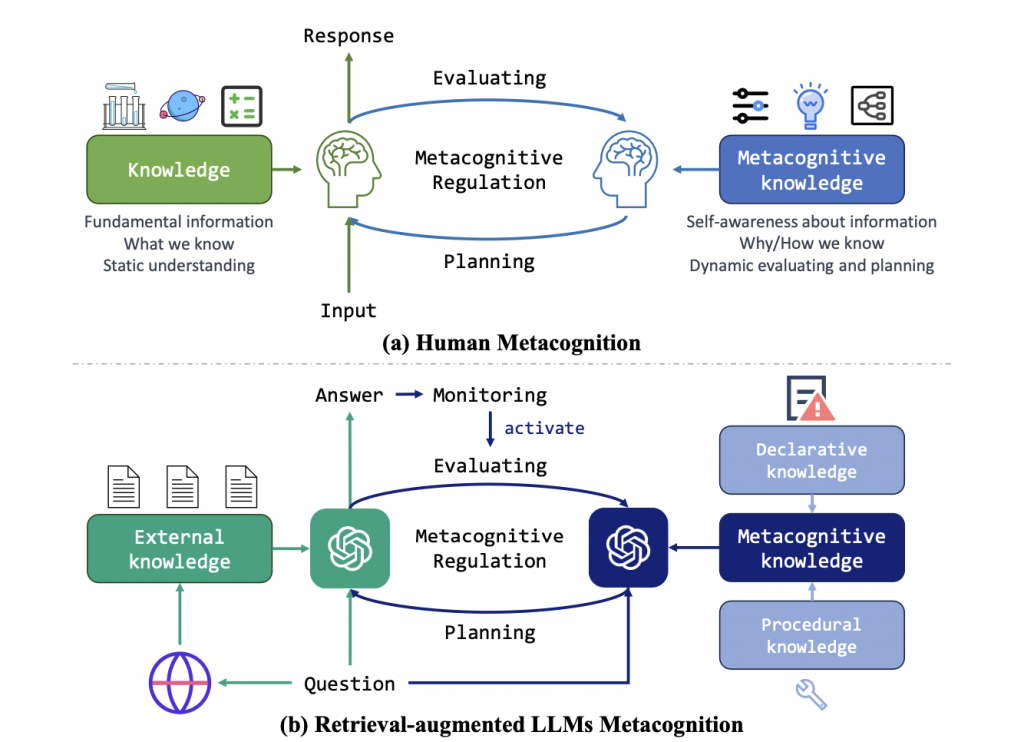

人間の場合は、複雑な問題に直面した時には自分の思考パターンを内省します。これはメタ認知と呼ばれています。今回研究者らは、メタ認知の概念をLLMに取り入れ、検索拡張生成(RAG)の性能向上を目指すことにしました。メタ認知的検索拡張生成フレームワーク(MetaRAG)です。

実験の結果、本手法がRAGの精度を大幅に向上させることが示唆されました。以下で詳しく紹介していきます。