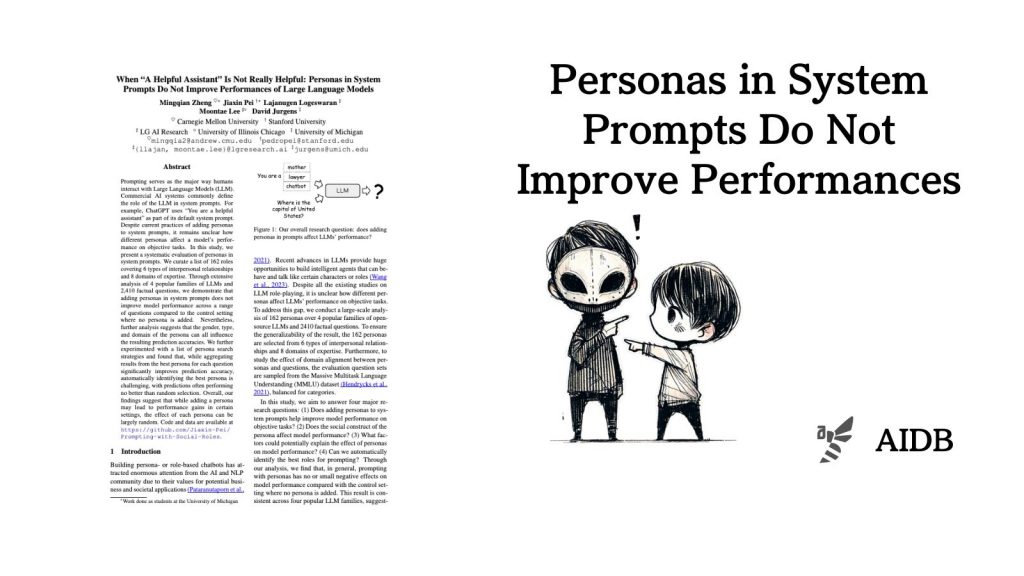

本記事では、LLMのシステムプロンプトにペルソナ設定を追加することの効果に関する研究を紹介します。

カーネギーメロン大学やスタンフォード大学などの研究者らは、162の異なる役割設定、4種類のLLM、2,410の事実に基づく質問を用いて、ペルソナがモデルの性能に与える影響を体系的に評価しています。

従来の常識とは異なる興味深い発見がありました。

参照論文情報

- タイトル:When “A Helpful Assistant” Is Not Really Helpful: Personas in System Prompts Do Not Improve Performances of Large Language Models

- 著者:Mingqian Zheng, Jiaxin Pei, Lajanugen Logeswaran, Moontae Lee, David Jurgens

- 研究機関:Carnegie Mellon University, Stanford University, LG AI Research, University of Illinois Chicago, University of Michigan

背景

LLMと人間のやり取りにおいて、プロンプトが重要な役割を果たしています。多くのシステムでは、システムプロンプトにLLMの役割を定義することが一般的です。例えば、ChatGPTは「あなたは役に立つアシスタントです」という設定をデフォルトのシステムプロンプトに含めています。

しかし、このようなペルソナ(役割設定)をシステムプロンプトに追加することが、モデルの性能にどのような影響を与えるのかは、これまで詳しくは明らかにされてきませんでした。特に、客観的な事実が求められるタスクにおいては。

そこで研究者らは、ペルソナがLLMの性能に与える影響を体系的に評価することにしました。そして以下のような取り組みを行いました。

- 6種類の対人関係と8つの専門分野をカバーする162の役割のリストを作成

- 4つの人気のあるオープンソースLLMファミリーを使用

- 2,410の事実に基づく質問を用意

このようにして、ペルソナを追加することがモデルの性能にどのような影響を与えるのかを詳細に分析しました。また、ペルソナの性別、種類、専門分野が予測精度にどのように影響するかも調査しました。

さらに、各質問に最適なペルソナを自動的に特定することが可能かどうかを探るため、いくつかのペルソナ検索戦略も試してみました。

以下で実験内容や実験結果を紹介します。