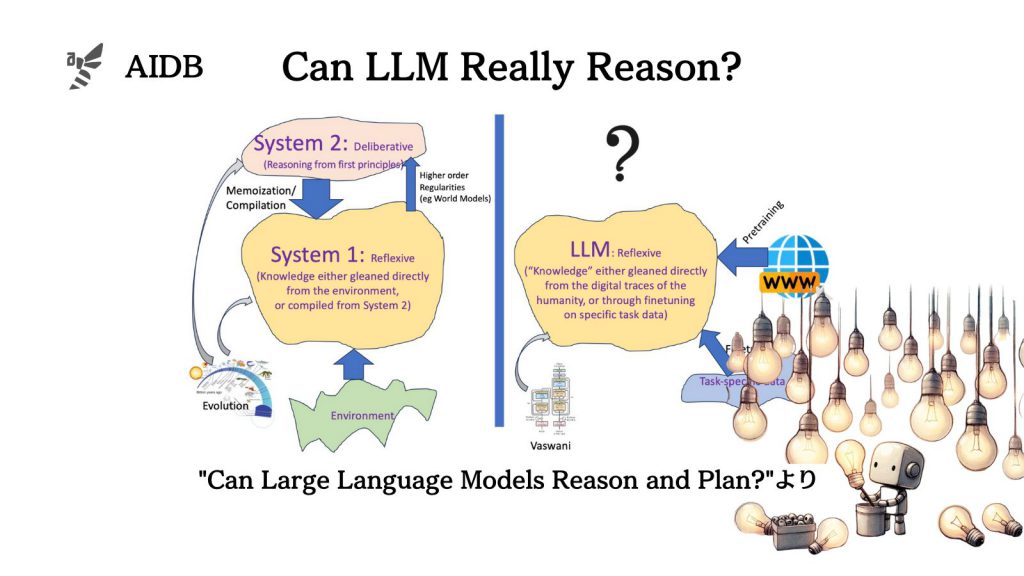

現在のLLMにおいて、皆が推論と呼んでいるものは、記憶とパターンに基づく生成のため、厳密には論理に基づくものではないと主張する論文が投稿されています。

そのため、その原則に基づく長所と短所に合わせた方法論を考えることが推奨されています。

参照論文情報

- タイトル:Can Large Language Models Reason and Plan?

- 著者:Subbarao Kambhampati

- 所属:Arizona State University

- URL:https://doi.org/10.1111/nyas.15125

はじめに

LLMは、超大規模のデータで学習された結果、誰もが予想もしなかった言語的振る舞いを示しています。一見してあまりにも汎用的なので、多くの研究者は、計画や推論のタスクでも優れた性能を発揮できるのではないかと考えるようになりました。

LLMが得意とするのは、一種の検索です。データベースから正確にデータを索引付けして取得するのとは異なり、LLMは、プロンプトの単語ごとに確率的に補完を再構成します。原理的には文章の自動補完ツールをもっと格段に高度にしたものだと考えるとわかりやすいかもしれません。

そのため研究者は、本質的にはLLMの長所は「創造性」であり短所は「幻覚」と考えています。そして、これこそまさにLLMの魅力の根源だと言います。

一方で現在「LLMはゼロショットで〈〇〇推論タスク〉ができる」といったタイトルの論文が非常に多く出ています。しかし改めて考えると、モデルは、本当に計画や推論ができるのでしょうか?

以下では、研究者らが考案した、LLMの短所を補い長所を伸ばす形で推論や計画タスクに活用するためのフレームワークを紹介します。まずはじめに研究者が行なった実験結果や考察から見ていきます。