Geminiは、テキストと画像を組み合わせたマルチモーダル推論に特化したLLMです。開発元であるGoogleは、Geminiは人間のような柔軟性と理解力を持つことを目指す存在だとしています。

本記事では、様々な常識推論タスクを通じてGeminiの性能を評価した研究を紹介します。

Geminiは登場からまだ間もなく、実験結果は貴重なデータかもしれません。

関連研究:Googleが「人間の専門家レベルを超える最初のモデル」とする『Gemini』発表、GPT-4を凌駕

参照論文情報

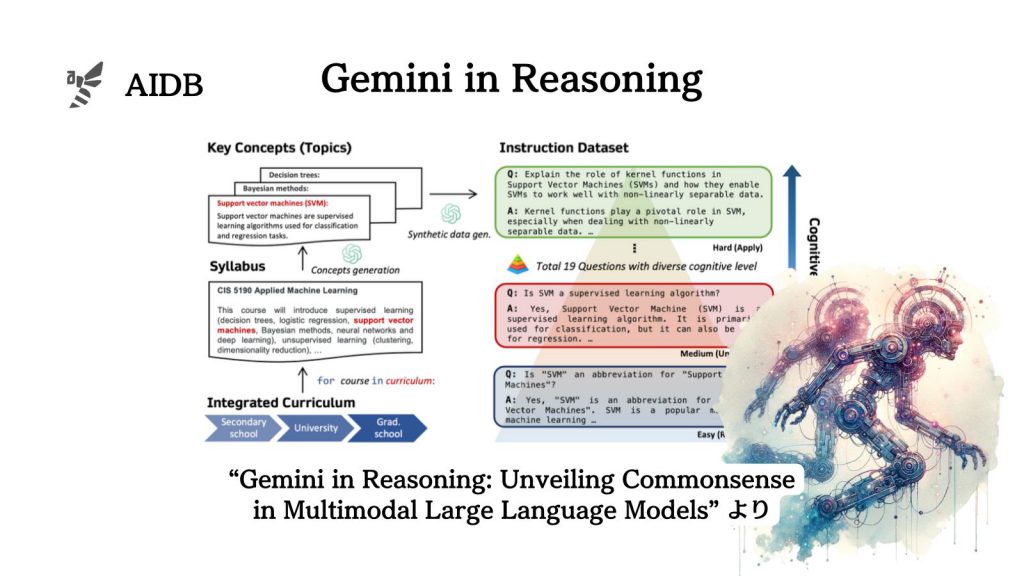

- タイトル:Gemini in Reasoning: Unveiling Commonsense in Multimodal Large Language Models

- 著者:Yuqing Wang, Yun Zhao

- 所属:スタンフォード大学、Meta

- URL:https://doi.org/10.48550/arXiv.2312.17661

- GitHub:https://github.com/EternityYW/Gemini-Commonsense-Evaluation/

研究に至る背景

私たち人間が日常で必要とする思考力の一つに常識推論があります。たとえば、天気予報をもとに服を選ぶ際には、気象や交通の知識や知恵が求められます。AIもこのような常識を理解するようになることが期待されています。

最近ではGPT-4VやGeminiのようなモデルが登場し、文章だけでなく画像なども理解するマルチモーダルLLM(MLLM)が注目され、常識推論の力も向上することが見込まれています。

現状ではモデルが「常識」をどれだけうまく扱えるのかは分かっていません。世の中の研究者たちはLLMの理解力を測定するために、色々な方法を試しているところです。

本記事の関連研究:

- Geminiの高い推論能力を活かして、過去最高水準のプログラミングAI『AlphaCode 2』も誕生したとの報告

- AGIを目指すLLMのために専門家レベルの問題を集めたベンチマーク「MMMU」、GPT-4VやGemini Ultraでも正解率6割未満

そもそも常識推論とはなにか

常識というのは、私たちが何気なく使っている日常の知識や考え方を指します。直感的に世界を理解するために無意識のうちに働く思考とも言えます。たとえば、曇った日に誰かが傘を持っているのを見たら、雨が降るかもしれないと私たちは予想します。また、例えば図書館などで部屋のドアが閉じられていたら、その部屋の中では静かでいるべきだと理解します。私たちは日々の生活の中で「常識」に基づいた推測を自然と行っているのです。

今回紹介する研究では、