専門家レベルのLLMを対象にして、これでもかというほど難しい問題を集めた新しいベンチマーク「MMMU」を開発したことがウォータールー大学などの研究者らによって報告されています。

GPT-4VやGemini Ultraでも6割未満の正解率であり、AGIに向けた課題が浮き彫りになっているのとのことです。

本記事では報告内容を見ていきます。

参照論文情報

- タイトル:MMMU: A Massive Multi-discipline Multimodal Understanding and Reasoning Benchmark for Expert AGI

- 著者:Xiang Yue et al. (多数)

- 所属:IN .AI Research, University of Waterloo, The Ohio State University, Carnegie Mellon University, University of Victoria, Princeton University

- URL:https://doi.org/10.48550/arXiv.2311.16502

- プロジェクト:https://mmmu-benchmark.github.io/

- コード:https://github.com/MMMU-Benchmark/MMMU

- データセット:https://huggingface.co/datasets/MMMU/MMMU

MMMU開発の背景

最近のLLMの進化は、AGI(人工一般知能)の実現に向かって進んでいるという見方があります。システムは高度な知能を持ち、多くの業界での人間の労働を代替する可能性を持つため、経済的な変動や雇用への影響も大きいと考えられています。

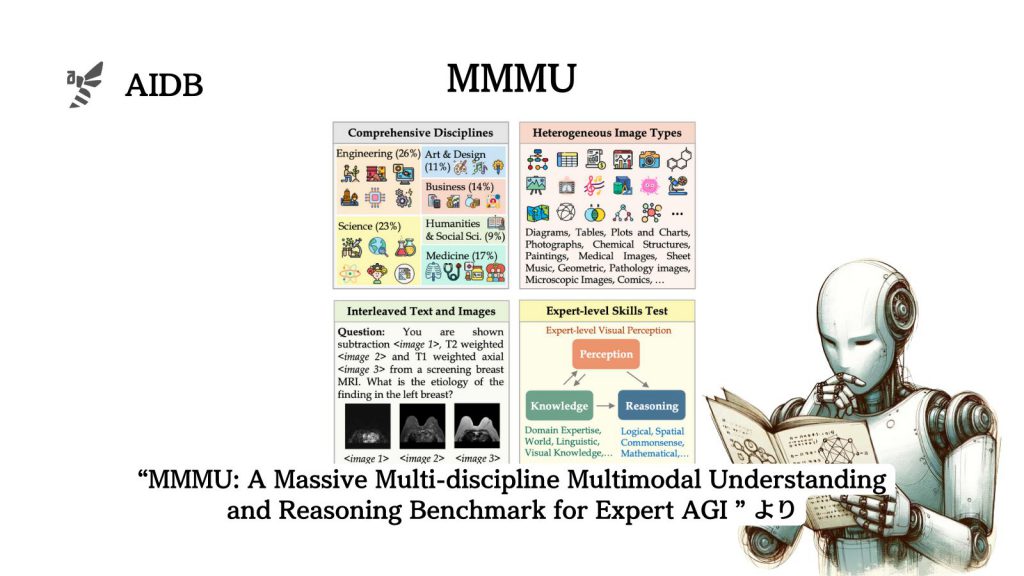

LLMのレベルを測るために開発されたベンチマークの中には、大学レベルの試験を参考にしたものもあり、テキストベースの問題だけでなく、マルチモーダル問題を解決する能力も評価されるようになってきています。

しかし、既存のベンチマークの多くはまだ標準的なレベルの知識にフォーカスしており、専門的かつ高度なレベルはあまりカバーしていないようです。

研究者らはこの課題を解決するために、専門的な内容を多く含む新しいベンチマークMMMUを開発しました。

本記事の関連研究:

- OpenAIが開発中、人間の理解をAIが超えた際の制御法

- DeepMindの研究者らが有効性を検証した、LLMに自ら高品質な訓練データを生成させる「自己学習」

- Googleが「人間の専門家レベルを超える最初のモデル」とする『Gemini』発表、GPT-4を凌駕

- 日常能力を試すテスト『GAIA』正答率、人間92%に対してGPT-4は15% 一般的なニーズに応えるAI開発の指針に

MMMUベンチマークの特徴

MMMUベンチマークは以下のような特徴を持っています。