本記事では、LLMを活用したRAGシステムにおける新しいアプローチを紹介します。

より効果的な情報検索と回答生成を実現するために、質問回答ペアをLLMで生成して参照する仕組みです。

モデルの微調整不要でコスト効率も高い手法として期待されています。

参照論文情報

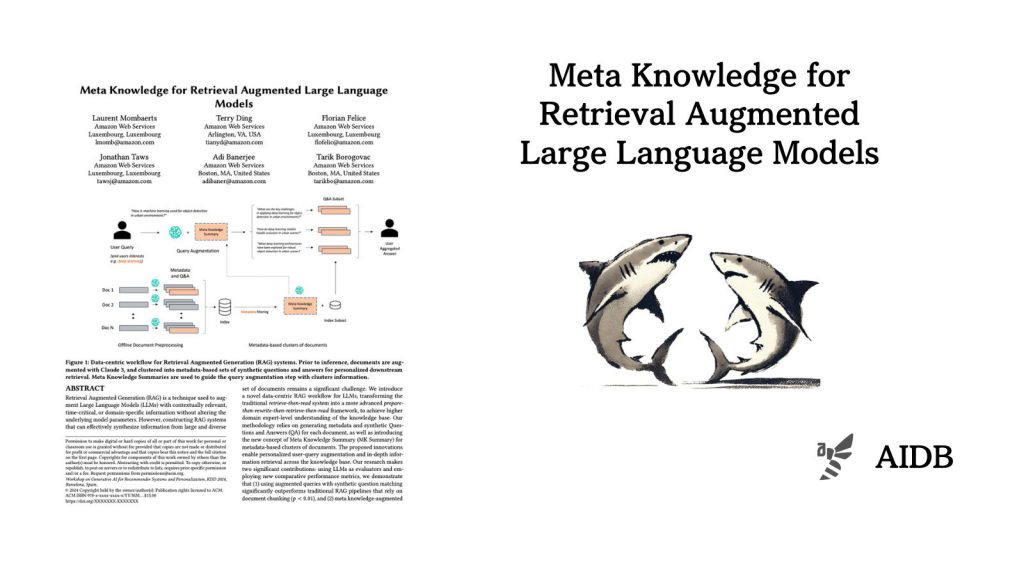

- タイトル:Meta Knowledge for Retrieval Augmented Large Language Models

- 著者:Laurent Mombaerts, Terry Ding, Adi Banerjee, Florian Felice, Jonathan Taws, Tarik Borogovac

- 所属:AWS

背景

検索結果を用いてLLMの出力を補強する手法である「検索拡張生成(RAG)」が、広く使用されるようになりつつあります。LLMに最新かつ正確な情報を提供することで、モデルの誤った情報生成を減らし、タスクに適した回答を生成する能力を向上させるアプローチです。

RAGシステムの構築には依然として難しい課題が残されています。大規模かつ多様な文書データから情報を効果的に探し出すのは至難の業であるという点です。通常のRAGの仕組みとしては、文書を単純に分割してチャンクとして扱います。しかしこれでは文脈の意味のつながりが失われる恐れがあります。また、そもそもユーザーの意図を正確に捉えて、適切な検索クエリを生成することも難しい課題の一つです。

これまでもRAGシステムを改善すべく様々なアプローチが提案されてきました。しかし、提案されてきた手法は往々にして、検索対象となる文書の特性を考慮できていないという問題がありました。

そこで今回研究者らは、従来の「検索してから読む」方式を拡張し、「”準備してから書き換えて”検索して読む」枠組みを考案しました。この方法を使うとユーザーの特性に合わせたクエリ拡張が可能となり、知識ベース全体にわたる深い情報検索が実現できることが分かりました。チャンキングに伴う情報損失を軽減し、ノイズフィルタリングの役割も果たします。

本手法は実用性の高いアプローチとして注目されています。検索の精度と再現率が向上し、最終的な回答の幅広さ、深さ、関連性、具体性が大幅に改善されることが実験で分かりました。

以下で詳しく紹介します。