本記事では、LLMを活用してディベートに強い自動応答システムを開発した研究を紹介します。

研究者らは、LLMに対して4つの役割を定め、人間を模倣する仕組みを作りました。また、自動評価システムと人間の審判を用いて性能を評価しました。

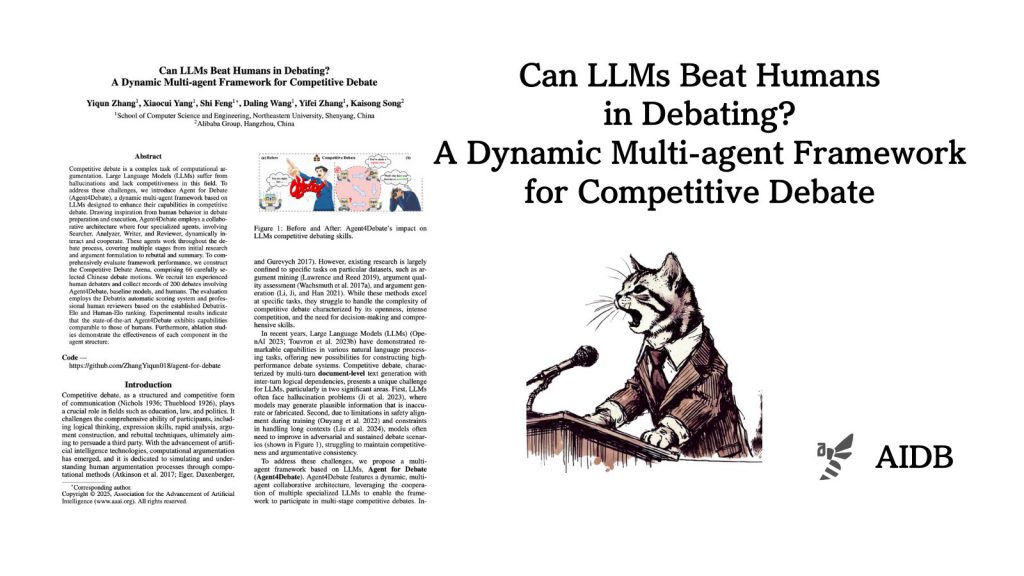

参照論文情報

- タイトル:Can LLMs Beat Humans in Debating? A Dynamic Multi-agent Framework for Competitive Debate

- 著者:Yiqun Zhang, Xiaocui Yang, Shi Feng, Daling Wang, Yifei Zhang, Kaisong Song

- 所属:Northeastern University, Alibaba Group

背景

学校や法廷、政治の場など、さまざまな場面で必要になるのが討論する能力です。論理的に考える力、自分の意見をうまく伝える力、相手の意見を素早く分析する力など、多くの能力が必要となります。

LLM登場以前も、コンピューターで人間の議論を再現しようという研究はありましたが、限られた範囲の課題にしか対応できていませんでした。現在、LLMによって再現のクオリティーが一気に向上するという期待が出ています。

しかし、LLMを討論に使うにあたって2つの問題があります。1つは、時々事実ではない情報を作り出してしまうこと。もう1つは、長時間の激しいやりとりを続けることが難しいことです。

そこで研究チームは、Agent for Debate(Agent4Debate)というシステムを開発しました。人間のように、情報を探す役、分析する役、文章を書く役、内容を確認する役の4つの役割を持つLLMが協力して働く仕組みになっています。

さらに、この仕組みの性能を正確に測るため、Competitive Debate Arenaという評価システムも作られました。人間とLLMの討論能力を比べるものです。

以下で取り組みの内容を詳しく紹介します。