JPモルガンの研究者らは、コードレビューにおいてLLMをどのように活用できるかを調査しました。

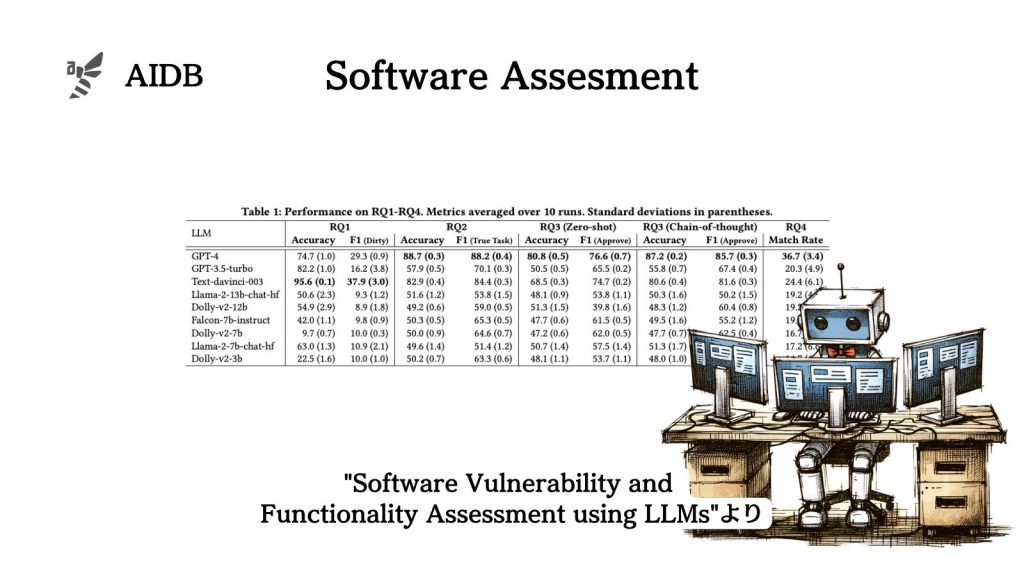

実験ではOpenAIの各種商用モデルと、比較的小規模なオープンソースLLMを使用し、セキュリティ脆弱性のあるコードにフラグを立てる能力と、ソフトウェアの機能検証能力を評価しました。

参照論文情報

- タイトル:Software Vulnerability and Functionality Assessment using LLMs

- URL:https://doi.org/10.48550/arXiv.2403.08429

- 機関:JP Morgan AI Research

- 著者:Rasmus Ingemann Tuffveson Jensen, Vali Tawosi, Salwa Alamir

背景

コードレビューは、ソフトウェア開発プロセスの中心的な役割を果たしています。例えばバグを減らし、コードの品質を向上させるといったものです。しかし、コードレビューを実行するのには費用がかかり、あるいは面倒な場合があります。さらに、レビューが適切に行われない場合、逆効果を及ぼす場合もあります。

これまで、コードレビューを自動化する方法が研究されてきましたが、その成功は控えめなものでした。そこで白羽の矢が立っているのがLLMです。今回研究者らは、LLMがコードレビューをどのように支援できるかを調査しました。調査対象となったモデルは、Dolly、Falcon、Llama、GPTファミリーです。

なお、本来コードレビューにはさまざまなタスクがありますが、今回は2つのタスクに焦点が当てられました。

- セキュリティ脆弱性のあるコードにフラグを立てること

- ソフトウェアの機能検証(コードが意図した機能を満たしていることを確認すること)

問題は以下の4つでした。

- LLMはコードのセキュリティ脆弱性にフラグを立てることができるか?

- LLMはソフトウェアの機能検証を行うことができるか?

- LLMはセキュリティ脆弱性にフラグを立て、同時にソフトウェアの機能検証を行うことができるか?

- LLMはセキュリティ脆弱性に関するフィードバックを提供できるか?

以下で結果を詳しく紹介します。