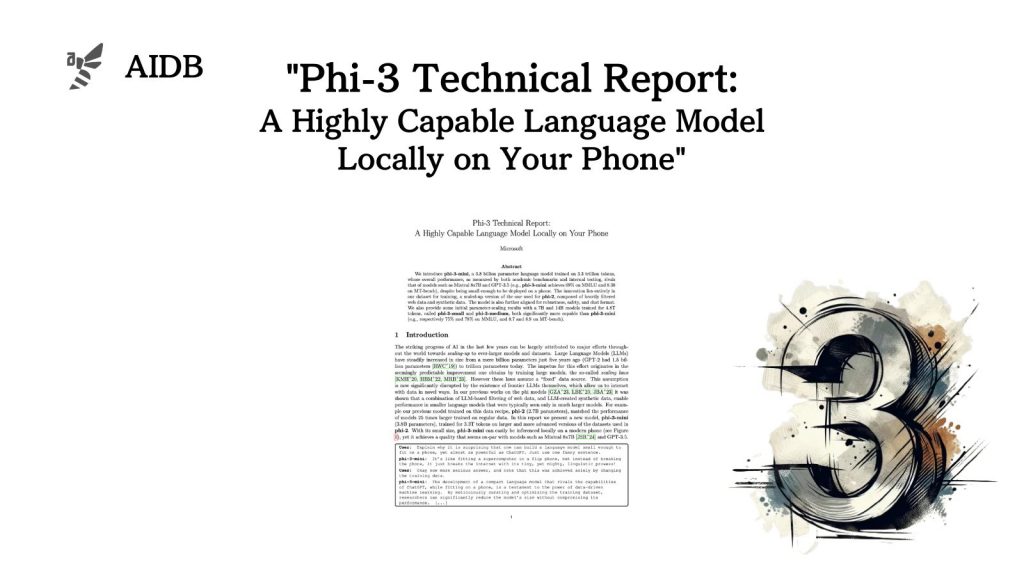

Microsoftの研究者らは、モバイルデバイス上で動作可能なほど小型の言語モデル「phi-3-mini」を開発しました。3.8Bパラメータで、3.3兆トークンのデータで学習されています。驚くべきことに、phi-3-miniの性能は、GPT-3.5やMixtral 8x7Bといった大規模モデルに匹敵するレベルに達していると言います。

参照論文情報

- タイトル:Phi-3 Technical Report: A Highly Capable Language Model Locally on Your Phone

- 著者:Marah Abdin et al. (多数)

- 所属:Microsoft

Phi-3シリーズの概要

phi-3-miniが高い性能を実現できた要因は、トレーニングデータにあると言います。研究者らは、以前のモデルphi-2の開発で使用したデータセットを拡張し、ウェブデータを厳選したものと、言語モデルが生成した合成データを組み合わせました。そうすることで、モデルサイズを小さく抑えながらも、大型モデルに匹敵する性能が得られたのです。

研究者らはまた、70億個と140億個のパラメータを持つモデル「phi-3-small」と「phi-3-medium」も開発しました。48兆トークンのデータで学習されており、phi-3-miniをさらに上回る性能を示しています。例えば、phi-3-smallとphi-3-mediumは、それぞれMMLU(多分野の知識テストベンチマーク)で75%と78%、MT-bench(会話で的確な返答ができるか評価するベンチマーク)で8.7と8.9を達成しています。

以下で論文(テクニカルレポート)をもとに、評価結果などを中心にPhi-3の詳細を紹介します。