研究者らは、LLMによる記号関連問題の解決能力を高めるための手法「Symbol-to-Language」を新たに提案しています。記号を自然言語表現に変換することで、LLMが理解しやすい形式で問題を解くようにするものです。

GPT-4をはじめとした様々なLLMに本手法を適用した実験では、化学式や絵文字の理解など8種類のタスクで有効性が検証されました。

なお、LLM自身のプロンプトや外部ツールを使って実行することができるとされています。

参照論文情報

- タイトル:Speak It Out: Solving Symbol-Related Problems with Symbol-to-Language Conversion for Language Models

- 機関:Tsinghua University, 01. AI, Shanghai Artificial Intelligence Laboratory

- 著者:Yile Wang, Sijie Cheng, Zixin Sun, Peng Li, Yang Liu

背景

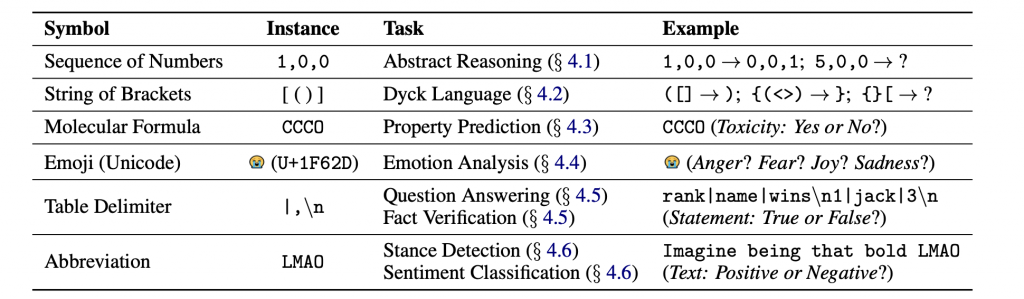

記号、例えば括弧、数字、化学式、絵文字、表の区切り文字などは日常生活レベルで重要です。そのため、LLMひいてはコンピューターシステム全般が、記号の理解力とそれに基づく推論能力を持つことは重要だと考えられています。

たとえば抽象的推論、化学物性予測、表形式のデータに基づく質問応答など、記号はさまざまなタスクで登場してきます(下記表を参考)。

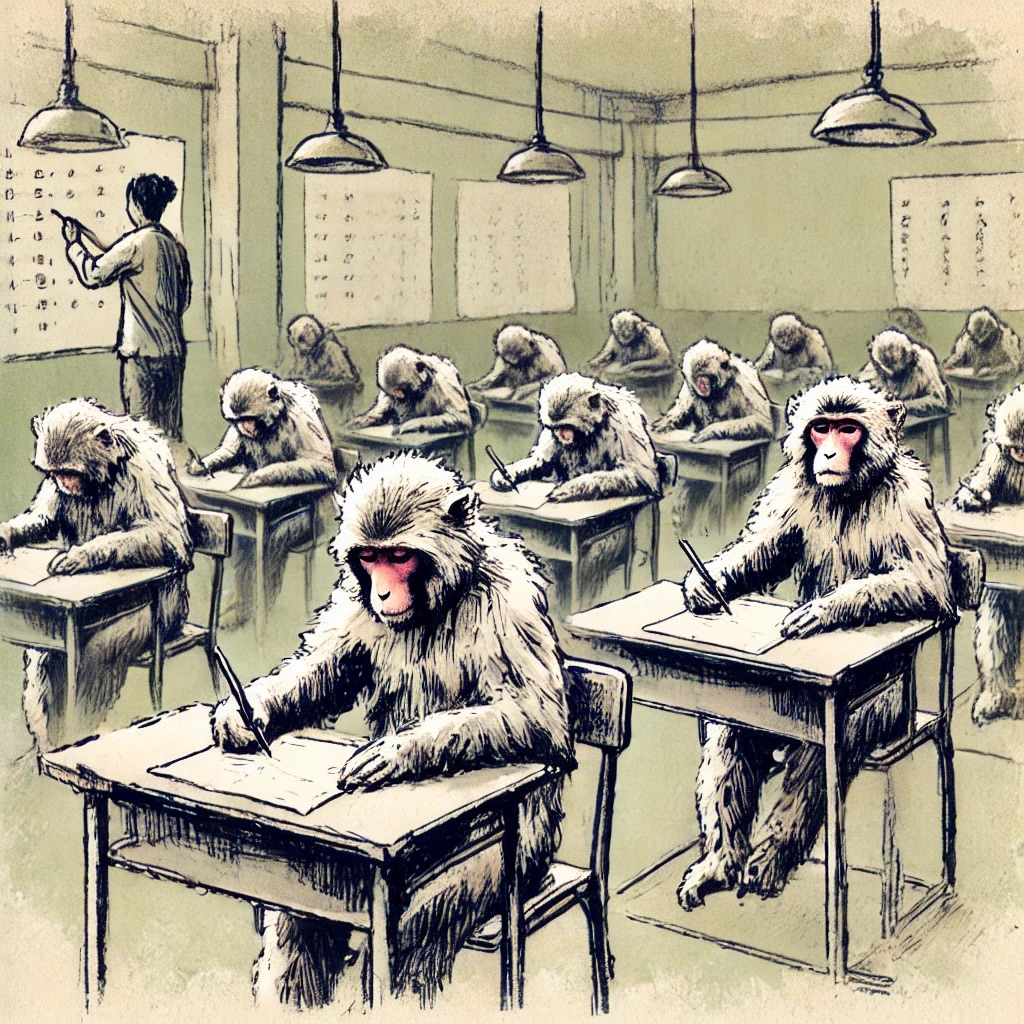

LLMは、自然言語の理解に比べると記号の理解と推論の能力は十分ではないと言われています。そのように考えられている根拠の例として、GPT-4やGPT-4Vは、数列やピクセルを用いた帰納的推論を必要とする抽象的推論タスクにおいて、人間よりも精度が低いことが挙げられます。また、他の自然言語タスクと比較するとなぜか記号関連問題の解決精度が低いことがたびたび議論に上がっています。

研究者らは、LLMの記号推論能力が不十分である主な要因として、記号は自然言語と比べてトレーニングデータ内の出現頻度が低く、LLMと記号の間に理解のギャップが生じていることを挙げています。

この課題に対処するため、今回研究者らは記号を言語表現に変換するアプローチに着目しました。LLMがより理解しやすい情報形式に変えることで回答の品質を上げるのが狙いです。

以下で詳細を紹介します。