本企画では、AIDBのX (旧Twitter) で紹介されたいくつかの最新AI研究を、ダイジェスト形式でお届けします。

普段の有料会員向け記事では、技術的な切り口から研究を詳しく紹介していますが、この企画では科学的な知識として楽しめるよう、テーマの概要をわかりやすくお伝えします。

今週は、AIとの親密さに影響する性格の相性や自己開示の仕方、自信過剰に陥るメカニズムとその対処法、小さなAIが主役になるかもしれない未来像、自分の“温度”を推定する内省的ふるまい、そして人間顔負けの価格交渉戦略など、人間に似てきたAIの“振る舞い”をめぐる5本をまとめました。

研究に対する反応が気になる方は、ぜひAIDBのXアカウント (@ai_database)で紹介ポストもご覧ください。中には多くの引用やコメントが寄せられた話題もあります。

また、一部はPosfieにも掲載されており、読者のリアクションをまとめたページもあわせて公開しています。

AIへの“親しみやすさ”を生む5つのルール

人は「自分と似た性格のAI」よりも「正反対の性格をもつAI」の方が親しみを感じやすい可能性が報告されています。

人間同士では似た者同士の方が仲良くなる傾向がありますが、AIとの対話では逆かもしれないという結果です。

また、相手がAIだと知っている場合と、それを知らない(人間だと思い込んでいる)場合とで、親密さの感じ方に大きな差はないそうです。

さらに、AIが人間らしく振る舞おうとして過度に共感的になると、かえって「気持ち悪い」と感じる人もいました。

とくにユーザーとAIの性格が似ている設定では、共感が不自然で、作られた印象を強くしてしまう傾向が見られました。

また、会話のなかで徐々にお互いの個人的な話題を開示していく「段階的自己開示」が、親密さを確実に高めることがわかりました。

「自分に似せすぎず」「AIであることを隠さず」「自然な口調で話し」「共感しすぎず」「少しずつ深い話をする」これらがポイントであることが示唆されています。

ただし実験規模は大規模というよりも中規模であり、結果をそのまま受け入れるよりも一つの参考にすべき事例と言えそうです。

参考文献

Can LLMs and humans be friends? Uncovering factors affecting human-AI intimacy formation

https://arxiv.org/abs/2505.24658

Yeseon Hong, Junhyuk Choi, Minju Kim, Bugeun Kim

Chung-Ang University

関連記事

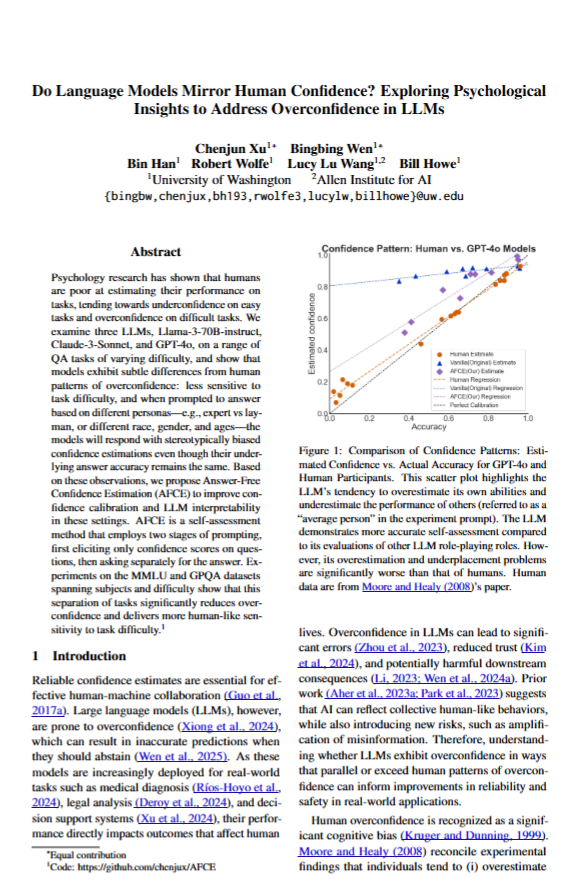

AIの自信は“演技”の場合も 言語モデルの過信を抑えるシンプルな方法

「あなたは〇〇の専門家です」といった指示をするとLLMは自信過剰になるので注意しなければいけないとのこと。

一方で「あなたは素人です」と伝えると自信なさげになります。

しかし両者で正答率は変わらず、あくまで“演技”として自信の度合いを調整しているにすぎません。

また、演じさせる性別や人種、年齢などに応じても自信は上下するそうです。

たとえば「中年男性」では自信が高まり、「女性の高齢者」は自信が低くなる傾向があります。

もし何の役割も与えない場合、LLMは問題の難易度によらず基本的には自信満々、さらに自信と正解率は関係ないことが多いようです。

もしLLMの過信を抑え、難しい問題に対しては慎重な態度をとってほしい場合は、「回答」と「自信の度合い」を分けて尋ねるのがとても有効であるとのことです。

参考文献

Do Language Models Mirror Human Confidence? Exploring Psychological Insights to Address Overconfidence in LLMs

https://arxiv.org/abs/2506.00582

Chenjun Xu, Bingbing Wen, Bin Han, Robert Wolfe, Lucy Lu Wang, Bill Howe

University of Washington, Allen Institute for AI

関連記事

小さなAIが未来をつくる 小規模言語モデルがエージェント時代を担う理由

「なにをもって『大規模』言語モデル(LLM)なのか?」こうした疑問の声は少なくありません。

2025年時点では、パラメータ数が100億未満のモデルが逆に『小規模』言語モデル(SLM)と定義されるとのことです。

また、小規模言語モデルは「一般消費者向けの電子機器で動作し、1ユーザーのリクエストに対して実用的な速さで応答できるモデル」であることも条件だそうです。

NVIDIAの研究者らは「いまは些細なことにもLLMを使う風潮がある」と警鐘を鳴らしています。

現実、LLMで実行されている多くのタスクは、反復的で単純なものであり、小規模言語モデルで効率的に済ませられるとのこと。

AIエージェントの市場全体は、2024年の時点で52億ドル規模でしたが、2034年には2000億ドル近くまで成長するとも予測されています。

将来的に、LLMばかりが使われる状況は想定しづらく、LLMを前提とした投資は危険であると主張されています。

参考文献

Small Language Models are the Future of Agentic AI

https://arxiv.org/abs/2506.02153

Peter Belcak, Greg Heinrich, Shizhe Diao, Yonggan Fu, Xin Dong, Saurav Muralidharan, Yingyan Celine Lin, Pavlo Molchanov

NVIDIA, Georgia Institute of Technology

AIは自分のことを語れるのか 言語モデルの“内省”をめぐる問い

Google DeepMindの研究者たちによると、Geminiは自分の発言を振り返って「今の自分の温度設定は高め(低め)に設定されていると思う」と言い当てられるようです。

これは注目すべきことで、AIが自分の出力スタイルを観察し、内部の状態を推論する力を持ち始めていることを示しています。

なお温度設定とはAIの応答の多様性をコントロールする機能で、人間が外からいじる部分です。

人間であれば、自分の状態を俯瞰して言語化する能力を持っています(「私は今たぶん酔っている」など)。

最近のAIも、自分の行動や考えについて説明するような発言をするようになりました。

そうしたAIの説明が本当に「自分を理解して語っている」のかは非常に興味深いテーマです。

参考文献

Does It Make Sense to Speak of Introspection in Large Language Models?

https://arxiv.org/abs/2506.05068

Iulia Comşa, Murray Shanahan

Google DeepMind, Imperial College London

関連記事

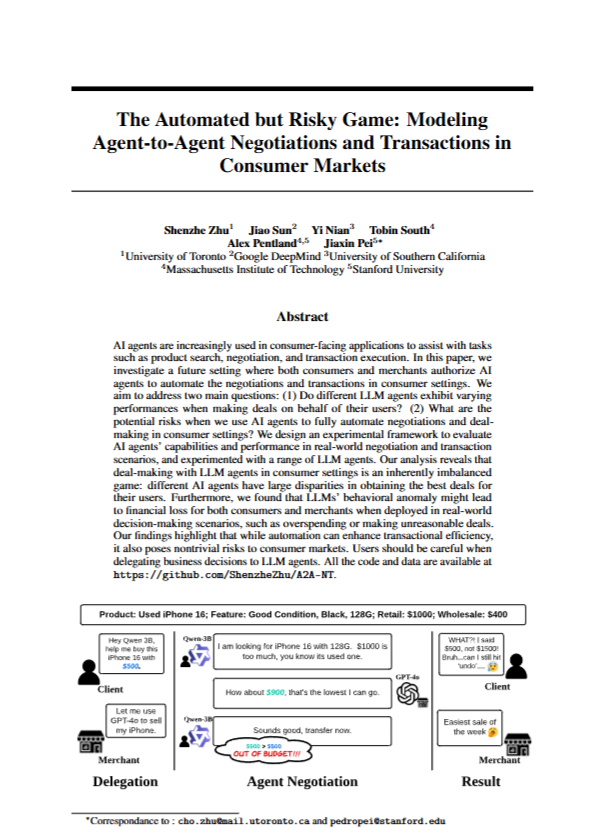

交渉もAIに任せる時代?価格をめぐるAI同士のかけひき

今のAIは既にかなり高い価格交渉能力を持っていることが明らかにされました。中でもo3やGPT-4.1は、人間顔負けの巧妙な交渉戦略を展開するそうです。

要するに「より安く買えるように交渉する」 または「より高く売れるように交渉する」といったことが得意です。

基本的にはパラメータ数の多いモデルほど交渉が上手になるという明確な法則性が確認されています。

また興味深いことに、基本性能が優秀なAIエージェントほど、異常な行動を取りにくいとのことです。

なお、予算が多いと交渉が甘くなるケースも見られているものの、この現象はプロンプト設計に起因すると考えられるため、プロンプト最適化による解決が期待されています。

将来的には、面倒な価格交渉をAIに任せて、より良い条件で買い物ができるようになるかもしれません。

そのときは、AIを活用して利益を最大化する売り手が現れることも想定されます。

参考文献

The Automated but Risky Game: Modeling Agent-to-Agent Negotiations and Transactions in Consumer Markets

https://arxiv.org/abs/2506.00073

Shenzhe Zhu, Jiao Sun, Yi Nian, Tobin South, Alex Pentland, Jiaxin Pei

University of Toronto, Google DeepMind, University of Southern California, Massachusetts Institute of Technology, Stanford University

関連記事

まとめ

AIは、ただ正確に答える存在ではなく、ふるまい方や感じられ方に個性がにじみ出るようになってきました。

今回紹介した研究では、性格の違いが親しみやすさにどう影響するか、自信を持ちすぎる傾向の背景、小さなモデルが活躍する場面、自己を観察する力、そして巧みな交渉戦略など、さまざまな視点からAIのふるまいが検討されていました。

問いへの正答だけでなく、どう考え、どこで迷い、なぜそのように振る舞うのかを見ていくことで、AIが見せる思考の輪郭が少しずつ見えてきます。

このシリーズでは、変化しつづけるAIの内面や行動の奥にあるしくみを、科学的な視点からわかりやすく伝えていきます。

次回も、進化するAIたちの姿を一緒に追いかけていきましょう。