本企画では、AIDBのX (旧Twitter) で紹介されたいくつかの最新AI研究を、ダイジェスト形式でお届けします。

普段の有料会員向け記事では、技術的な切り口から研究を詳しく紹介していますが、この企画では科学的な知識として楽しめるよう、テーマの概要をわかりやすくお伝えします。

今週は、言葉より画像で考えるAI、脳に触れず思考を読み取る技術、感情や対話パターンから関係改善を支援するモデル、長文要約の中で生まれる“幻覚”現象、推理ゲームを通じて論理力を試されるAIなど、AIの思考やふるまいに迫る5本の研究を紹介します。

研究に対する反応が気になる方は、ぜひAIDBのXアカウント (@ai_database)で紹介ポストもご覧ください。中には多くの引用やコメントが寄せられた話題もあります。

また、一部はPosfieにも掲載されており、読者のリアクションをまとめたページもあわせて公開しています。

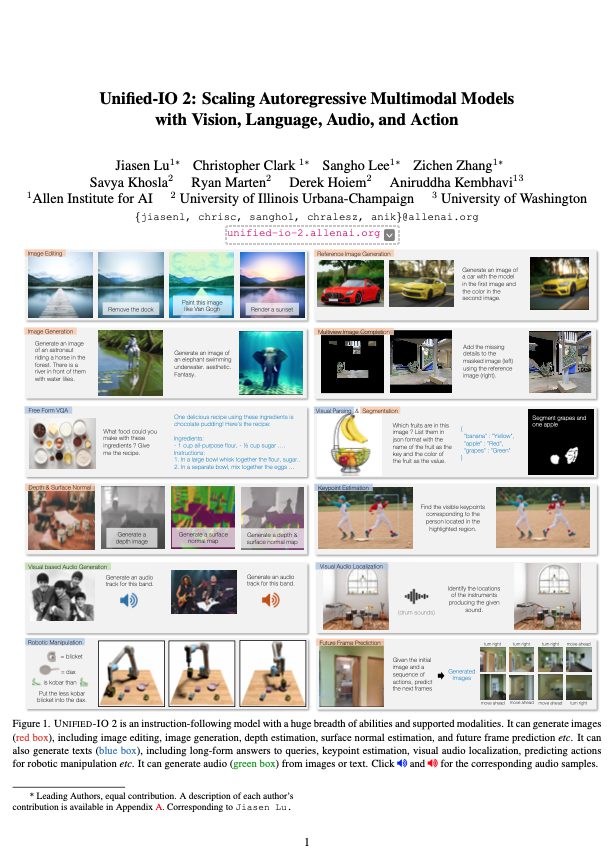

言葉より画像の方がAIはうまく考えられる?迷路で見えた新しい思考の形

「AIには、言葉で考えさせるより、視覚で考えさせた方がむしろ上手くいく場合がある」という発見が報告されています。

ケンブリッジ大、ロンドン大、Googleによる研究者らによる発表。

たとえば迷路を解くタスクでは、頭の中で道のりを思い浮かべるように、AIにも画像の連続を見せて「こう進めばいい」と考えさせるように仕向けました。

その結果、言葉で考えるよりも画像だけの方が上手くいきました。難しい問題ほどその差は大きく、40%以上も良くなったケースもありました。

人間が頭の中でイメージしながら考えるのに似たことを、AIにもさせられるという新しい発見です。

なお「見た目の情報で状況がわかるような問題」でやるのがポイントです。 迷路以外に幾つかのタスクが試され、能力が再現されました。

実験で使用されたAIはLarge Vision Model(大規模視覚モデル)という画像と動画のみで訓練されたモデルです。

参考文献

Visual Planning: Let’s Think Only with Images

https://arxiv.org/abs/2505.11409

Yi Xu, Chengzu Li, Han Zhou, Xingchen Wan, Caiqi Zhang, Anna Korhonen, Ivan Vulić

University of Cambridge, University College London, Google

関連記事

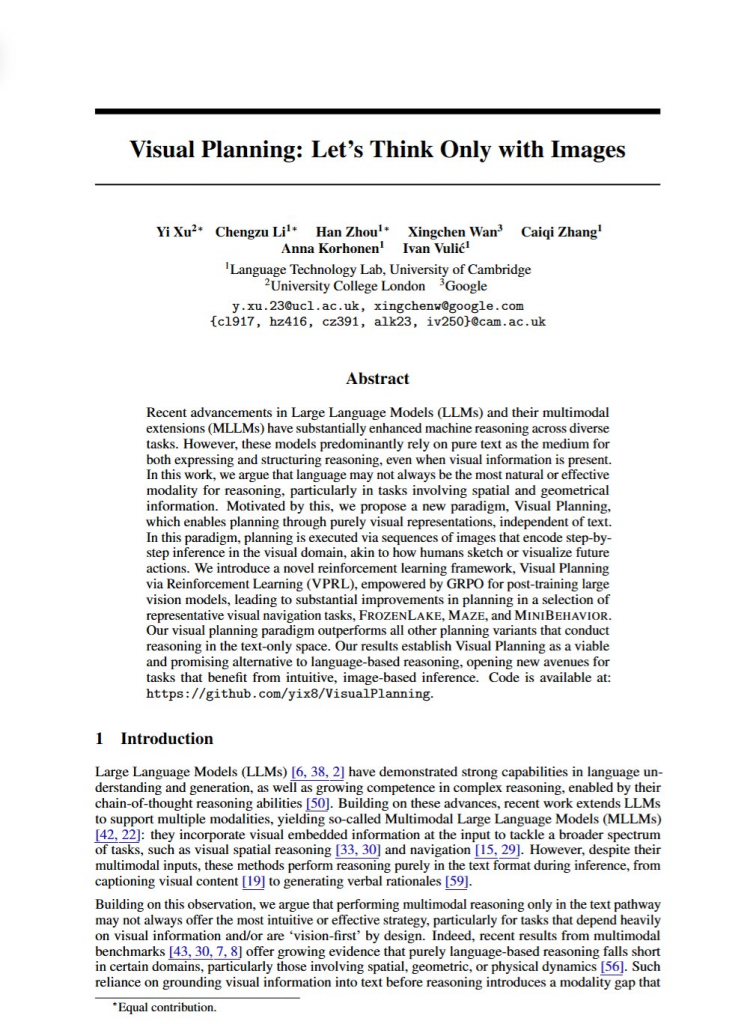

「考えたことを文字にする」夢が現実に?脳に触れず読み取る新技術のブレイクスルー

脳で思い描いた言葉を文章として取り出すことが、頭に電極を埋め込まなくても、ついに統計的に意味のあるレベルで実現したとの報告。

単語ごとの脳波から予測された候補に対して、LLMで文脈の整合性を評価する仕組みを取り入れたのがポイントだそうです(未知の単語が出てきたとしても、LLMが前後の文脈をもとに補完)。

もちろん、現時点ではまだリアルタイム性に欠け、まだ誤りも多く、脳活動を測定する装置も大きいので日常用途に適しているとは言えません。

とはいえ、これまでの非侵襲的手法(要するに頭に侵入せずに外側から何とかするアプローチ)では達成できなかった水準の精度を初めてクリアしたという意味で注目すべき成果とのことです。

この「Brain-to-Text」は、話せなくなった人のコミュニケーションを支援する手段としても注目されています。

これまでは脳に電極を埋め込む手術を伴う方法でしか精度が出ず、実用化の大きな障壁となっていました。

参考文献

Unlocking Non-Invasive Brain-to-Text

https://arxiv.org/abs/2505.13446

Dulhan Jayalath, Gilad Landau, Oiwi Parker Jones

University of Oxford

関連記事

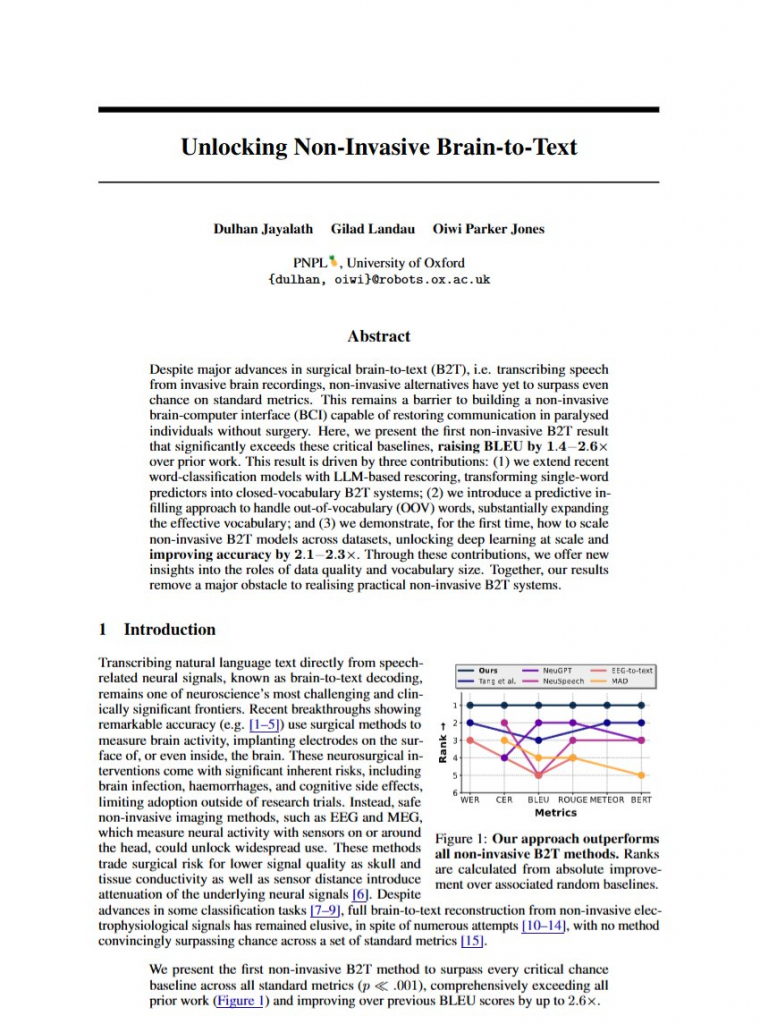

ケンカの仕方をAIが見抜く?恋愛関係のすれ違いを優しくほぐす対話トレーナー

恋人同士のケンカやすれ違いをAIで解消するのは有効であるとの提案。

LLMで二人のやりとりの記録(チャットなど)をもとに、どんなケンカのしかたをしているのかを分析します。

そしてケンカのタイプを以下の4つに分類し、LLMがそれぞれに応じたアドバイスを行います。

1. 相手を避けがち

2. 冷静に対話できている

3. 感情が揺れやすい

4. 攻撃的になってしまう

また、ケンカの中で出てきやすい「相手の性格を否定する」「馬鹿にする」「責めに対して守りに入る」「相手を混乱させるような言い方をする」といった、よくないコミュニケーションのパターンを見つけます。

そして、「けんかの最中」「けんかが終わったあと」「ふだん」といった場面ごとに、どう対応すればよいかを教えます。

システムの目的は、「どちらが正しいか」を判断することではありません。

自分自身の反応やくせに気づき、相手の考え方や気持ちの背景にも目を向ける力を育てることを大切にします。

恋愛における衝突は(痴話げんかと一蹴するなかれ)、ただの意見の違いではなく、気持ちの結びつきや力のバランス、自分らしさのあり方などが深く関係しています。

関係性の改善は、すぐに結果が出るものではなく、少しずつ築かれていくものであるという前提のもと、このようにユーザーを支える仕組みがあるとよいとのこと。

参考文献

ConflictLens: LLM-Based Conflict Resolution Training in Romantic Relationship

https://arxiv.org/abs/2505.11715

Jiwon Chun, Gefei Zhang, Meng Xia

Texas A&M University, Zhejiang University of Technology

関連記事

AIの要約は「最後がウソ」になりやすい?長文生成に潜む見落としがちなバグ

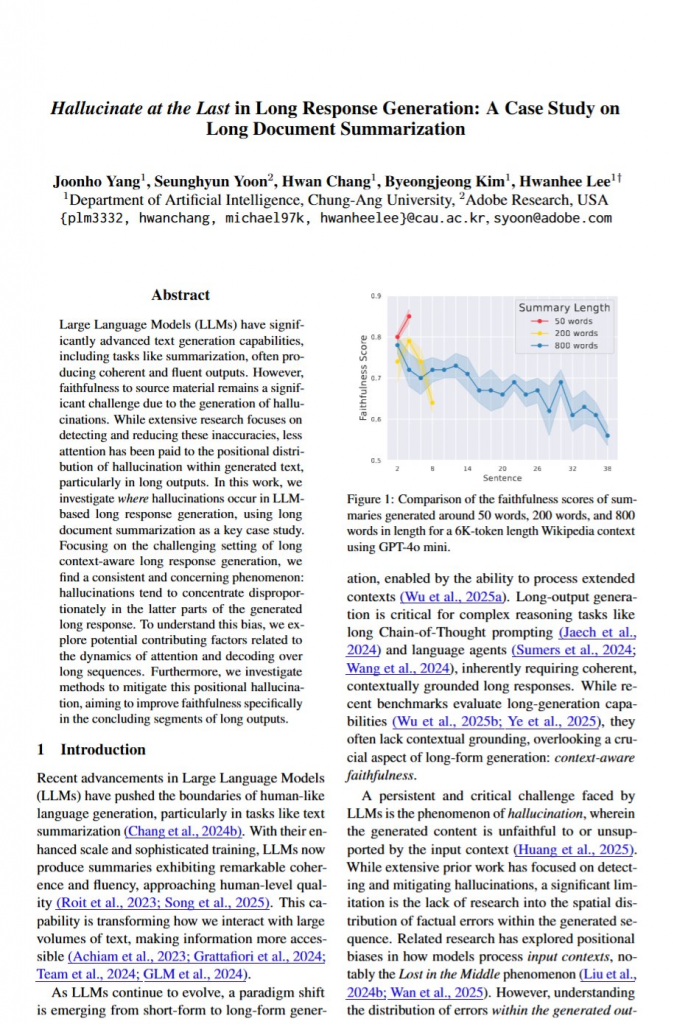

LLMに文書の要約をさせると、要約文の後半になるにつれて、元の文書にはない内容を作り出してしまう傾向があることが明らかにされました。

これは「最後に幻覚を見る(Hallucinate at the Last)」現象と名付けられました。

800語以上の要約を作らせると、この問題が顕著に現れ、短い要約ではそれほど目立たないそうです。

なぜこうなるかというと、AIが文章を生成していく過程でだんだん元の資料ではなく自分の書いた文章を見て続きを書こうとするようになるから、とのこと。

この現象は、入力する文書自体が短くても長くても起こりますし、ニュース記事でも学術論文でも政府レポートでも、どんな分野の文書でも同じように発生します。

この問題を改善するには、長い文書を小さな塊に分けて、それぞれを個別に要約してから最後にまとめるという手法がかなり有効のようです。 しかし、これは根本的な解決策ではなく、今後さらなる研究が必要とのことです。

(新しく登場した拡散モデルベースのLLMでは同様の問題が起きない可能性もあります。)

参考文献

Hallucinate at the Last in Long Response Generation: A Case Study on Long Document Summarization

https://arxiv.org/abs/2505.15291

Joonho Yang, Seunghyun Yoon, Hwan Chang, Byeongjeong Kim, Hwanhee Lee

Chung-Ang University, Adobe Research

関連記事

AIは「逆転裁判」の謎を解けるのか?推理ゲームで試されたAIの限界

AIがどこまで「推理」できるのかを知るために、あの「逆転裁判」と「ダンガンロンパ」の世界を舞台にしたテストを作り試したとの報告論文。

ゲーム内では、矛盾を見つける課題が与えられます。 選べる証言や証拠の組み合わせは最大300通りにもなり、かなり骨の折れる内容です。

シナリオのスクリプトは平均で2万5000文字。

実験の結果、いまのAIにとっては、複雑な論理推理はまだまだ難しい領域だとはっきりしたとのことです。

また、注目ポイントは「じっくり考えれば当たる」というわけではないという点でした。むしろ、長く考えたAIほど答えを外しやすくなる傾向すらありました。

一般的に効果的とされる戦略も、ここでは大きな助けにはならなかったのです。

私たち人間が夢中になる謎解きとミステリーの世界は、AIにとっても緻密で多面的であり、手強い難問のようです。

参考文献

TurnaboutLLM: A Deductive Reasoning Benchmark from Detective Games

https://arxiv.org/abs/2505.15712

https://github.com/zharry29/turnabout_llm

Yuan Yuan, Muyu He, Muhammad Adil Shahid, Jiani Huang, Ziyang Li, Li Zhang

University of Pennsylvania, Drexel University

関連記事

まとめ

AIは、ただ正解を出すだけでなく、ときに迷い、誤解しながらも考えつづけています。

今回紹介した研究は、そんな“ふるまい”の裏側にある仕組みと進化に光をあてたものでした。

AIの思考を知ることは、私たち自身の理解のかたちを見つめ直すことでもあります。

週末ダイジェストでは、こうしたAIの今を、科学の楽しさとして伝えていきます。

次回もまた、考え続けるAIたちの姿をともに見つめていきましょう。