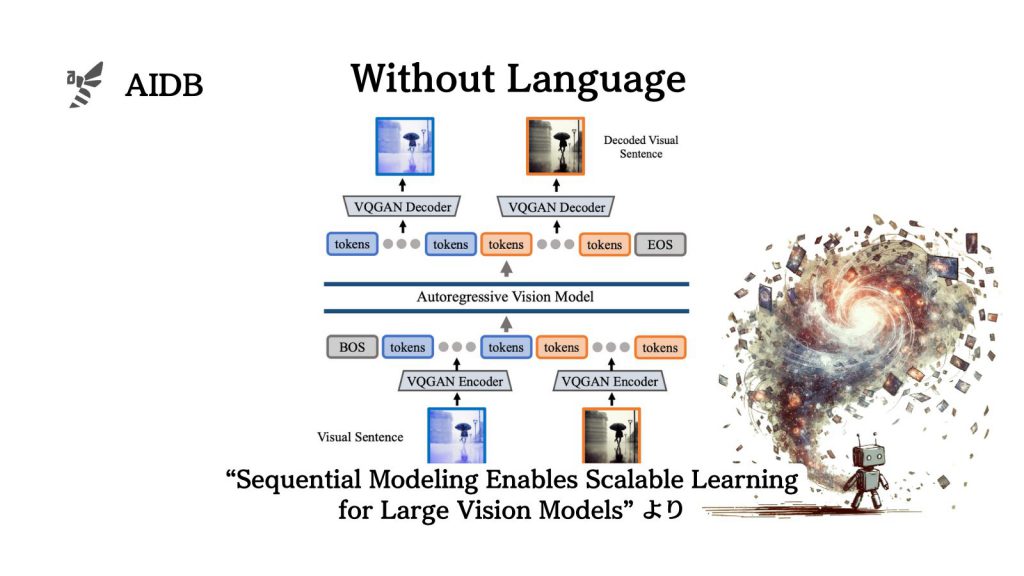

UC BerkeleyとJohns Hopkins Universityの研究者らは、「視覚は本来、言語に依存しない」と考え、言語データを使用せずに大規模ビジョンモデル(LVM)を効果的に学習する新しいアプローチを開発しました。

研究者らは、開発したアプローチが大規模なデータセットに対して優れたスケーラビリティを持ち、さまざまなビジョンタスクに適用可能であることを示しました。

本記事では、そのアプローチ、機能、実験結果などの詳細を紹介します。

参照論文情報

- タイトル:Sequential Modeling Enables Scalable Learning for Large Vision Models

- 著者:Yutong Bai, Xinyang Geng, Karttikeya Mangalam, Amir Bar, Alan Yuille, Trevor Darrell, Jitendra Malik, Alexei A Efros

- 所属:UC Berkeley, Johns Hopkins University

- URL:https://doi.org/10.48550/arXiv.2312.00785

- プロジェクトページ:https://yutongbai.com/lvm.html

本記事の関連研究:OpenAI、ChatGPTが画像を分析する『GPT-4V(ビジョン)』を発表。安全性、嗜好性、福祉機能を強化

研究背景

コンピュータビジョンの分野は、ディープラーニングの登場と大規模データセットによって大きく進歩してきました。一例としてImageNetのような画像認識のブレークスルーは、視覚タスクの自動化と新しいアプリケーションの開発を加速してきました。

一方、AI分野全体における大きな動きとして、GPT-4やLLaMAのようなLLMが、膨大な言語データを学習することで、言語タスクにおいて高度な理解と生成能力を獲得してきました。なお、広く使用されているLLMはトランスフォーマーアーキテクチャを使用して文脈を考慮した情報処理を行なっています。

そしてLLMのアーキテクチャを改造する形で、膨大なテキストデータに基づく言語処理能力と、膨大な視覚データによる訓練をあわせて、GPT-4VやLLaVAのような大規模視覚言語モデルが登場してきたのが直近の流れです。

しかし研究者らは、もともと視覚自体は言語に依存しない直感的なものだと考えました。そこで、言語データに頼らずに視覚データから学習する大規模モデルの可能性を模索し始めました。

そして従来の学習手法に代わる新手法の可能性が浮上し、言語データを使用せずに視覚タスクを処理する能力を持つLVMの構築が行われました。

本記事の関連研究:画像分析機能を持つオープンソースLLM『LLaVA-1.5』登場。手持ちの画像を分析可能。GPT-4Vとの違い

アプローチ

画像や動画のビジュアル文定義

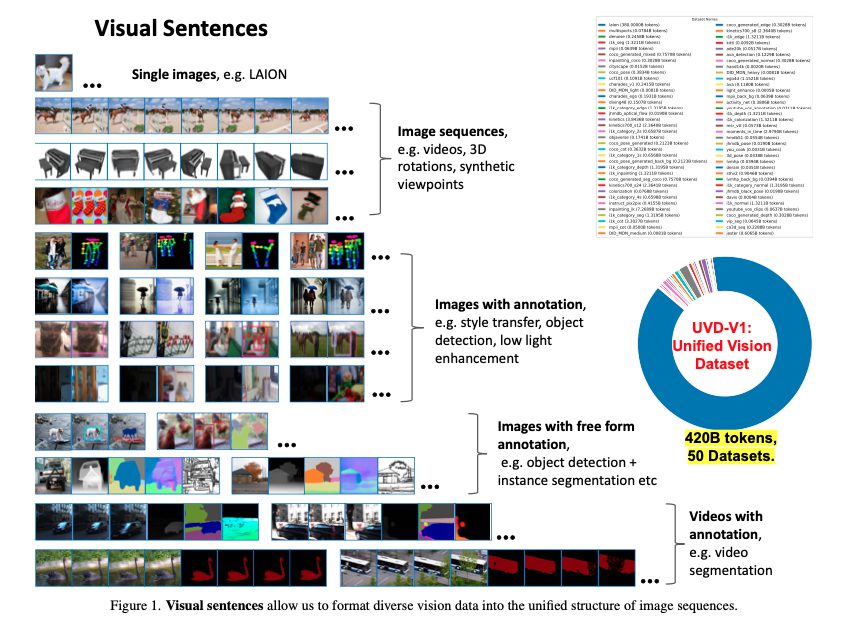

本研究ではまず「ビジュアル文」を定義し、それを使って画像や動画を表現する方針がとられました。ビジュアル文とは、画像や動画、注釈付きデータなどの視覚データを、メタ知識を必要とせずにシーケンスとして表現する新しいフォーマットです。

研究者たちは、視覚データには、テキストデータとは異なり自然なシーケンシャルな構造が存在しないため、画像ピクセルをビジュアル文として直接モデル化することはできないかもしれないと考えました。

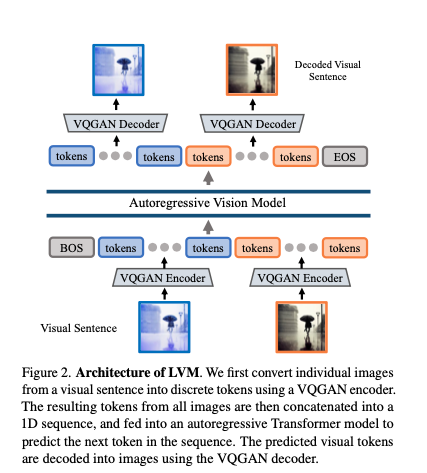

そこで、個々の画像を操作して、各画像を「視覚トークンのシーケンス」に変換する大規模な「視覚トークナイザー」を訓練する二段階のアプローチを採用しています。

視覚データのトークン化におけるポイント

VQGANを用いて画像を離散トークンに変換した後、これらのトークンを複数の画像から1Dシーケンスに連結し、ビジュアル文として統一的に扱っています。

ここで重要なのは、特定のタスクやフォーマットを示す特別なトークンは使用せず、すべてのビジュアル文を平等に扱うことです。モデルがタスクやフォーマット固有のトークンからではなく、コンテキストから画像間の関係を推論できるようにします。

つまり、画像を特別な記号に変換し、それらをつなげて一連の流れとして扱い、画像の内容を理解するための新しい方法を使っています。

自己回帰型トランスフォーマーモデルの訓練

研究者たちは、自然言語コミュニティからのインスピレーションを受け、方法論の中心を、マスクされたトークンモデリングから順序的自己回帰予測へと移行しました。

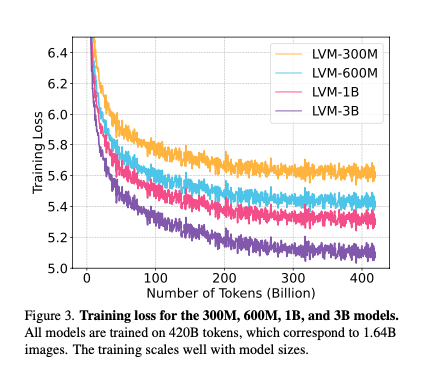

画像、動画、注釈付き画像をすべてシーケンスとして表現することで、次のトークン予測のためのクロスエントロピー損失を最小化する訓練が可能になります。この極めてシンプルな設計を通じて、モデルサイズとデータサイズを増やすことで適切なスケーリング行動が可能となります。なお実験を通して、適切なプロンプトを設計することでさまざまなビジョンタスクが「解決」されることを実証しています(後述)。

要するにこの研究では、画像や動画を次々と予測する方法でモデルを訓練し、さまざまな視覚的な問題を効果的に解決する方法を開発しました。

本記事の関連研究:画像セグメンテーションの革新「Segment Anything Model(SAM)」 Meta AIの論文から解説

言語データなしで訓練されたLVMの機能

言語データを使用せずに訓練されたLVMは、基本ビジョンタスクに加えて、未知のデータへの対応能力も持っています。

基本的なタスクを実行

上記の方法論によって言語データなしで訓練されたLVMは、いくつか基本ビジョンタスクに取り組む能力が示されています。

以下は論文で示されているタスクの例です。