現実のユーザーからの難しいクエリを使用してLLMの性能を評価する自動評価フレームワークが開発されました。100万以上の人間とチャットボットの会話ログから厳選された1,024のタスクを使用するというユニークな取り組みです。

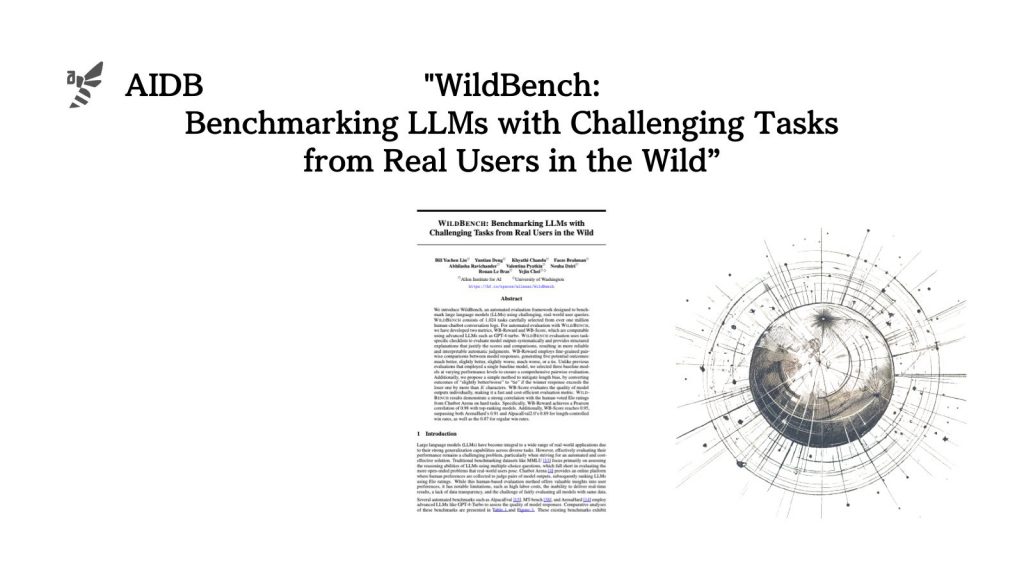

参照論文情報

- タイトル:WildBench: Benchmarking LLMs with Challenging Tasks from Real Users in the Wild

- 著者:Bill Yuchen Lin, Yuntian Deng, Khyathi Chandu, Faeze Brahman, Abhilasha Ravichander, Valentina Pyatkin, Nouha Dziri, Ronan Le Bras, Yejin Choi

- 所属:Allen Institute for AI, University of Washington

背景

LLMの性能を適切に評価することは容易ではありません。自動化することも難しいですが、リアルなニーズ(実際にユーザーが投げる多様なタスク)におけるLLMの性能を測定することは難しいとされてきました。

人間の評価者を用いるChatbot Arenaのようなプラットフォームは有益ではありますが、機能は限定的といえば限定的です。

参考:あらゆるLLMを「使い心地」基準でバトルさせる便利なプラットフォーム『Chatbot Arena:チャットボットアリーナ』

また既存の自動評価ベンチマークは、タスクの多様性や難易度の分布で課題が残っています。

こうした背景から、今回研究者らは実際のユーザーからの質問を用いてLLMを評価するための新たなベンチマーク「WILDBENCH」の構築に至りました。

100万件以上の実際のユーザーとチャットボットの対話データから注意深く選択された1,024のタスクで構成されています。タスクは定期的にアップデートされ、LLMの進化に合わせてベンチマークの内容も進化していくとされています。

以下ではWILDBENCHによって実験された各モデルの評価結果などを中心に、研究報告を掘り下げていきます。

参考までに、実験に使用されたモデルを先に並べます。

GPT-4-Turbo-0409

Claude 3 Opus

Llama-3-70B-Inst

Llama-3-8B-Inst

Llama-3-8B-Inst-SimPO

Yi-1.5-34B-chat