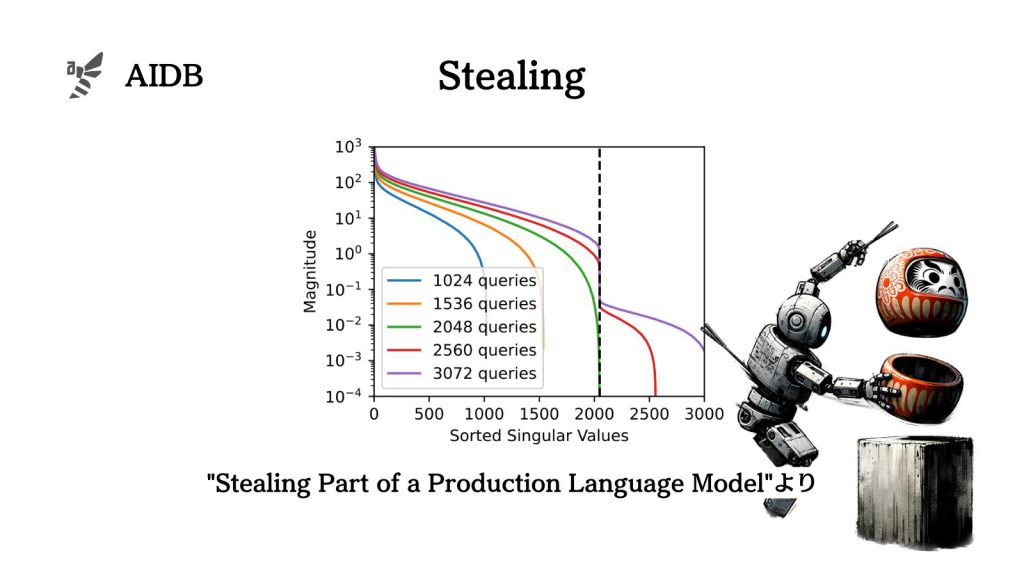

Googleなどの研究者らは、OpenAIのChatGPTやGoogleのPaLM-2のようなブラックボックスの大規模言語モデルから、正確で重要な情報を抜き出す初の「モデル窃盗攻撃」手法を開発しました。目的は、LLM開発者全体のセキュリティ技術向上にあります。

今回の発表では、一般的なAPIアクセスがあればトランスフォーマーモデルの埋め込み射影層をシンメトリーを除いて復元できる可能性が示されました。実際に、20ドル以下のコストで、OpenAIのadaモデルとbabbageモデル(どちらもGPT-3シリーズ)の完全な射影行列を抽出することに成功しています。

また、gpt-3.5-turboモデルの正確な隠れ次元サイズも明らかにし、約2000ドルの費用で完全な射影行列を復元できると推定されています。

研究者らは、このような攻撃に対する防御策についても整理し、一層の安全性に寄与することを考えています。

参照論文情報

- タイトル:Stealing Part of a Production Language Model

- 機関:Google DeepMind, ETH Zurich, University of Washington, OpenAI, McGill University

- 著者:Nicholas Carlini, Daniel Paleka, Krishnamurthy (Dj) Dvijotham, Thomas Steinke, Jonathan Hayase, A. Feder Cooper, Katherine Lee, Matthew Jagielski, Milad Nasr, Arthur Conmy, Eric Wallace, David Rolnick, Florian Tramèr

背景

GPT-4、Claude 3、Geminiなど、現在最も人気の高い大規模言語モデルの内部構造については、ほとんど公開されていません。

実際、GPT-4の技術報告書には、「アーキテクチャ(モデルサイズを含む)、ハードウェア、学習に使用した計算資源、データセットの構築、学習手法などの詳細は含まれていない」と記載されています。

同様に、PaLM-2の論文でも、「モデルサイズとアーキテクチャの詳細は、公開対象から除外されている」と述べられています。

研究者らは、この秘密主義は競争的環境(モデルの学習には高コストがかかるため)と、大規模モデルの安全性への影響(情報が多いほど攻撃が容易になるため)に起因すると指摘しています。

ただし、APIを通じた外部からアクセスは可能な状態にあります。そこで研究者らは、APIを通じて、実際に運用されている言語モデルについてどの程度の情報が得られるかを調査しました。

かねてよりモデル窃盗(model stealing)の分野で研究されている問題で、攻撃者がAPIへの問い合わせによりモデルの重みを抽出できるリスクがあると指摘されてきました。

結論から言うと、今回研究チームは、ブラックボックスの言語モデルに対して効果的な新しい攻撃手法を探し当てることとなりました。トランスフォーマーベースの言語モデルにおいては普遍的に完全な埋め込み射影層を復元できる可能性が示されています。

このようなハッキング手法の発表は一見センセーショナルですが、重要な研究上の意義があります。

本研究のように実運用モデルから正確な情報を盗み出すことに成功した例はこれまでになく、大規模言語モデルのセキュリティを考える上で重要な出来事となりました。今回の研究結果を受けて、OpenAIのAPIでは防御策が実装されたとのことです。

以下で報告内容の詳細を紹介します。