本企画では、AIDBのXで紹介されたいくつかの最新AI研究を、ダイジェスト形式でお届けします。

普段の有料会員向け記事では、技術的な切り口から研究を詳しく紹介していますが、この企画では科学的な知識として楽しめるよう、テーマの概要をわかりやすくお伝えします。

今週は、AIが「書き手の責任」をどう扱うかから、地球観測、学習のコツ、コミュニケーションの橋渡し、言葉だけでの空間推論、モデルの系譜、そして脳の感情地図までを一気に追います。AIが人の考え方と感じ方にどこまで寄り添えるのか、その輪郭が少しずつ見えてきました。

研究に対する反応が気になる方は、ぜひAIDBのXアカウント (@ai_database)で紹介ポストもご覧ください。中には多くの引用やコメントが寄せられた話題もあります。

また、一部はPosfieにも掲載されており、読者のリアクションをまとめたページもあわせて公開しています。

書かずに著者ってアリ?LLMと“責任の持ち主”という考え方

「LLMを使って論文を書いても著者と呼べるのか」は議論されていますが、

現行の基準にもとづくと「もしLLMを使ってもその人は著者になる」主張されています。

学術会では、実際に文章を書かなくても、たとえば研究のアイデアを出して、部下に論文を書かせて、最後にチェックするだけでも「著者」として名前が載ります。

もしこの慣行が正当なら、LLMを使って論文を書く場合も同じように扱うべきではないかとのこと。

つまり、研究者がLLMにアイデアを与えて論文を書かせ、その内容をしっかりチェックして責任を持つなら、その人は著者と呼べるはずだということです。

問題としては、LLMは事実と異なることを書いたりするので、使用者は慎重にチェックする必要があります。

しかし、これは著者性を否定する理由にはならず、単に責任を取る対象が増えるだけとのこと。

参考文献

Authorship Without Writing: Large Language Models and the Senior Author Analogy

https://arxiv.org/abs/2509.05390

Clint Hurshman, Sebastian Porsdam Mann, Julian Savulescu, Brian D. Earp

National University of Singapore, University of Copenhagen, University of Oxford

関連記事

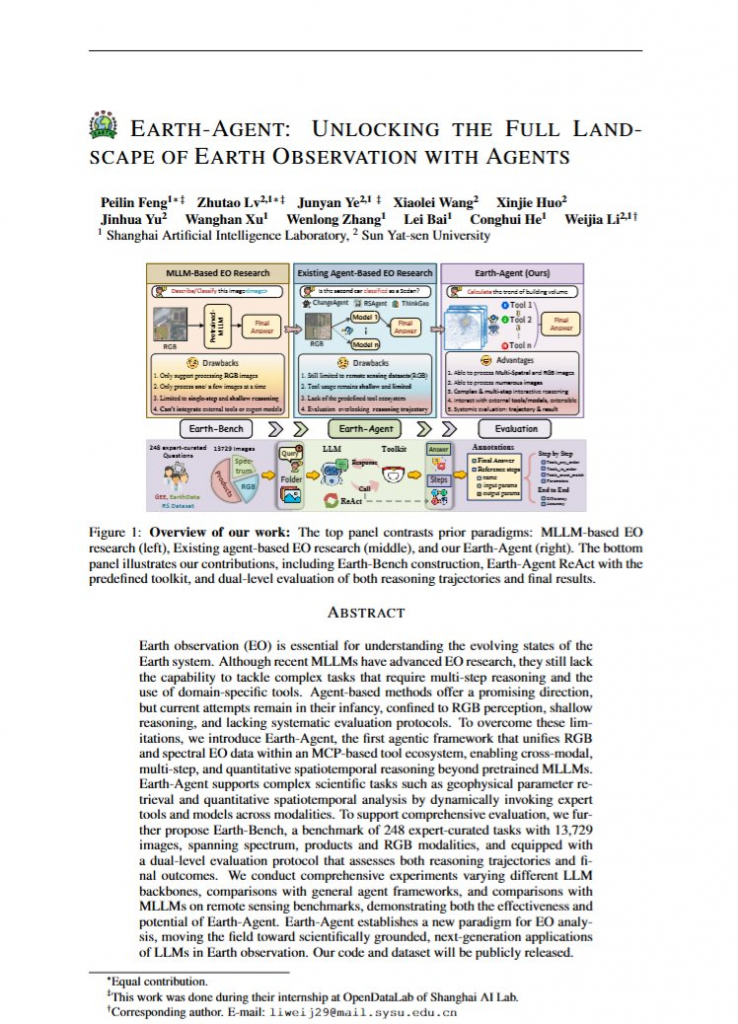

地球を見守るAIが衛星データを100の道具で読み解く

研究者らは、地球観測を行うためのAIシステム「Earth-Agent」を開発したと報告しています。

人工衛星などから得られるデータを地球観測の専門家のように100種類以上のツールを使い分けながら分析し、地球を高度にモニタリングします。

例えばメキシコの都市の夜間光の変化を追跡したり、

海水濁度がどう変化したかを分析したり、

カリフォルニアの干ばつを特定したり

災害で破壊された建物の数を数えたりといったことに役立つとのことです。

ただし現在の最高スコアがテスト全体で約66%(モデルにより前後)で、これは「良好な性能だが、もっと進化させなければいけない水準」のようです。

それでも、こうしたテクノロジーは地球規模の問題をサポートするものとして期待されます。

都市開発や気候・災害対応など、大規模な影響を予測する技術はますます重要性を増していくと考えられるためです。

参考文献

Earth-Agent: Unlocking the Full Landscape of Earth Observation with Agents

https://arxiv.org/abs/2509.23141

Peilin Feng, Zhutao Lv, Junyan Ye, Xiaolei Wang, Xinjie Huo, Jinhua Yu, Wanghan Xu, Wenlong Zhang, Lei Bai, Conghui He, Weijia Li

Shanghai Artificial Intelligence Laboratory, Sun Yat-sen University

関連記事

8週間じっくりで伸びる LLMと学びの正しい距離感

LLMを腰を据えて長い期間使いこむことで、本人自身の能力も向上することが示唆されました。なお、注意点もあります。

学生がChatGPTを使用した実験結果を大規模に分析した結果、8週間以上じっくり使うことでLLMなしの能力も大きく向上。

そして、8週間未満の期間だと限定的でした。

ただし、

LLMを使い込むことで向上する能力を分野別に見ると、知識量やスキル獲得では効果がはっきりしており、自分で考えて判断する力や、他の人と協力する力においてはやや限定的でした。

さらに、LLMを単に「答えを教えてくれる便利な道具」としてだけ扱うと、LLMなしでの本人の能力は逆に下がることがあります。

「一緒に考えてくれる先生」のように使って、答えをすぐ貰わずに、自分で考える時間を設けたりすると、本当の学習効果が出ることが分かりました。

こうした事例から、LLMによる人間自身の学習効果を狙うのであれば「期間」「役割」が重要になりそうです。

参考文献

A Meta-Analysis of LLM Effects on Students across Qualification, Socialisation, and Subjectification

https://arxiv.org/abs/2509.22725

Jiayu Huang, Ruoxin Ritter Wang, Jen-Hao Liu, Boming Xia, Yue Huang, Ruoxi Sun, Jason Minhui Xue, Jinan Zou

University of Adelaide, University of South Australia, CSIRO

関連記事

相手の視点で話してみる ズレに気づく会話トレーニング

LLMに自閉スペクトラム症者的なコミュニケーションを模倣させるシミュレーターを開発し、定型発達者に会話させる実験を行ったところ、

こうした仕組みは自閉スペクトラム症者への理解を促すことに役立つと示唆されています。

一般的には、自閉スペクトラム症者が定型発達者の話し方に合わせるよう訓練することばかりが多く、

これは不均衡な状況と言えます。

研究者たちが作ったシミュレーターは、定型発達者が自閉スペクトラム症的なコミュニケーション(たとえば「言葉を文字通り受け取る傾向」「絵文字の意味理解に混乱する」など)を直接体験し、自らの関わり方を振り返ることができます。

実験の結果、定型発達者の参加者たちによる自閉スペクトラム症者への認識が改善され、またAIシステムを使うことで適切なフィードバックが得られると評価されました。

たとえば米国では成人の45人に一人が自閉症スペクトラム症者に該当すると推定されており、総人口が非常に多い特性です。

技術の力で相互理解がより深まっていくことが期待されます。

参考文献

NeuroBridge: Using Generative AI to Bridge Cross-neurotype Communication Differences through Neurotypical Perspective-taking

https://arxiv.org/abs/2509.23434

Rukhshan Haroon, Kyle Wigdor, Katie Yang, Nicole Toumanios, Eileen T. Crehan, Fahad Dogar

Tufts University, Eunice Kennedy Shriver Center, UMass Chan Medical School

関連記事

絵を見ずに形がわかる 言葉だけで図形パズルを解くLLM

「頭の中でイメージを描かないと解けない」ような課題を、LLMがテキストのみの推論で解けるようになっていると報告されています。

たとえば「Dを想像して90度回転させ、底にJを付ける」といった指示が与えられ、最終的な形を答えるという課題。これには視覚的イメージが不可欠とされてきました。

しかし意外にもGPT-5やo3といった最新モデルは、画像処理なしで取り組んで、人間平均(55%)を上回り、67%の正答率を記録しています。

純粋なテキスト処理だけで空間的な課題を解いているということです。

なお、同様の課題と答えが学習データにそもそも含まれているということがないように慎重にオリジナルの課題が用意されました。

この発見は、視覚イメージは本当に必要なのかという認知科学の根本問題に迫ります。

アファンタジアの人々(頭の中でイメージを視覚化することのできない状態)がなぜ同様の課題をこなせるのかという謎への手がかりにもなるかもしれません。

参考文献

Artificial Phantasia: Evidence for Propositional Reasoning-Based Mental Imagery in Large Language Models

https://arxiv.org/abs/2509.23108

Morgan McCarty, Jorge Morales

Northeastern University

関連記事

モデルの家系図を作る LLMのDNAで親子関係をたどる

LLMに生物のDNAのような「遺伝情報」を定義しようという試みが行われています。

研究者たちは、生物学でDNA配列を比較して種の関係を調べるように、LLMにも同様のことができないかと考えました。

機能的に似ているモデルは似たDNAを持ち、あるモデルを微調整して別のモデルを作ると、

元のモデルと似たDNAになるという定義です。

実際に305個のモデルでテストしたところ、公式には関係が記録されていないモデル同士でも、DNAが似ている場合があり、実は派生関係にあることが見つかったケースがありました。

また、DNAの系統樹から、LLMの進化の変遷も辿ることができました。

現在、何百万ものLLMが存在しますが、どのモデルがどのモデルから派生したのか、モデル間の関係性はほとんど記録されていません。

こうしたLLMの「家系図」を作ることで、リスクの追跡やライセンス違反の検出なども容易になる可能性があります。

参考文献

LLM DNA: Tracing Model Evolution via Functional Representations

https://arxiv.org/abs/2509.24496

Zhaomin Wu, Haodong Zhao, Ziyang Wang, Jizhou Guo, Qian Wang, Bingsheng He

National University of Singapore, Shanghai Jiao Tong University

関連記事

脳が感じる地図を読むAI 自己申告より当たる感情モデル

研究者たちが2,180本の動画を使い、AIに感情の違いを710万回も繰り返し分析させたところ、AIは喜び、恐怖、憧れ、嫌悪といった人間的な感情カテゴリーを自発的に学習していったと報告されています。

その結果、人間が何らかの動画を見たときの感情的な脳活動を予測できるようになったそうです。

そして、これは人が言葉で伝えるよりも正確である可能性が示唆されています。

大規模な分析から自然に浮かび上がってくる情報で、脳本来の感情の幾何学を忠実に捉えることが期待できるかもしれないということです。 一方で、人間が自分で「複雑で豊かな感情体験」について単純に表現することには限界があり、先入観が阻害要因になっていると考察されています。

さらに研究者たちは、AIが学んだ感情を起点にして動画を編集することの有効性も実証。

例えば「恐怖」成分を増やす動画を生成させると焚き火が炎に変化し、「怒り」成分を増やすと平和なドキュメンタリーが暴動シーンに変わりました。

「視覚による感情体験」と「感情表現」の関係における知見を深めるような研究事例です。

参考文献

Bridging the behavior-neural gap: A multimodal AI reveals the brain’s geometry of emotion more accurately than human self-reports

https://arxiv.org/abs/2509.24298

Changde Du, Yizhuo Lu, Zhongyu Huang, Yi Sun, Zisen Zhou, Shaozheng Qin, Huiguang He

Institute of Automation, Chinese Academy of Sciences, University of Chinese Academy of Sciences, Beijing Normal University

まとめ

AIは“置き換え”ではなく“後押し”として、人の判断や学びを拡張する方向へ進んでいます。設計の焦点は、責任の所在を明確にしつつ、状況に応じて道具や手順を選び、足りない感覚や知識を推論で補うこと。人の側も、短期の便利さではなく継続的な使い方や対話の姿勢を整えることで、理解・共感・透明性を同時に高められる。技術を使いこなすこと自体がリテラシーになり、私たちの関与の仕方が成果を左右する段階に来ています。

このダイジェストでは、機能紹介だけでなく、その背後にある意図や運用上の注意点も見渡します。どこで人が関与し、どんな順番で確かめ、誰が責任を持つのか。広がる活用の中で、私たちが選び取りたい関わり方を具体的に描き直し、次回もその境目を一緒に見極めていきましょう。