LLMに下書きを頼んで、出てきた文章を読んで、「ここ違うな」と直してもらって、また確認する。AIコーディングツールが書いたコードをレビューして、修正を指示して、またレビューする。こうした「AIの管理」に、思ったより時間を取られていないでしょうか。

その疲労感は、気のせいではないかもしれません。この1年、人間がAIの管理者を務めるスタイルそのものに疑問を投げかける研究が続いています。AIに得意な仕事を任せたのに、人間が逐一チェックすることでかえって成果が落ちる。一方、AIにワークフローの主導権を渡して、人間は自分にしかできない判断だけに集中するほうが、結果もよく負担も軽い。そんな報告が出てきています。

管理者でいることにこだわる必要はない

AIエージェントの多くは、「人間が指示を出し、AIが実行する」前提で作られています。人間がプロンプトを書き、出力をチェックし、修正を指示する。当たり前のやり方に見えます。

ところが、この前提を揺さぶるデータがあります。2024年に発表された論文では、人間が得意なタスクでは協調が成果を改善する一方、AIが得意なタスクでは人間が関与するとかえってパフォーマンスが下がることが示唆されました。AIのほうが上手にできる仕事で、人間が管理者を続けることが足を引っ張っていた。

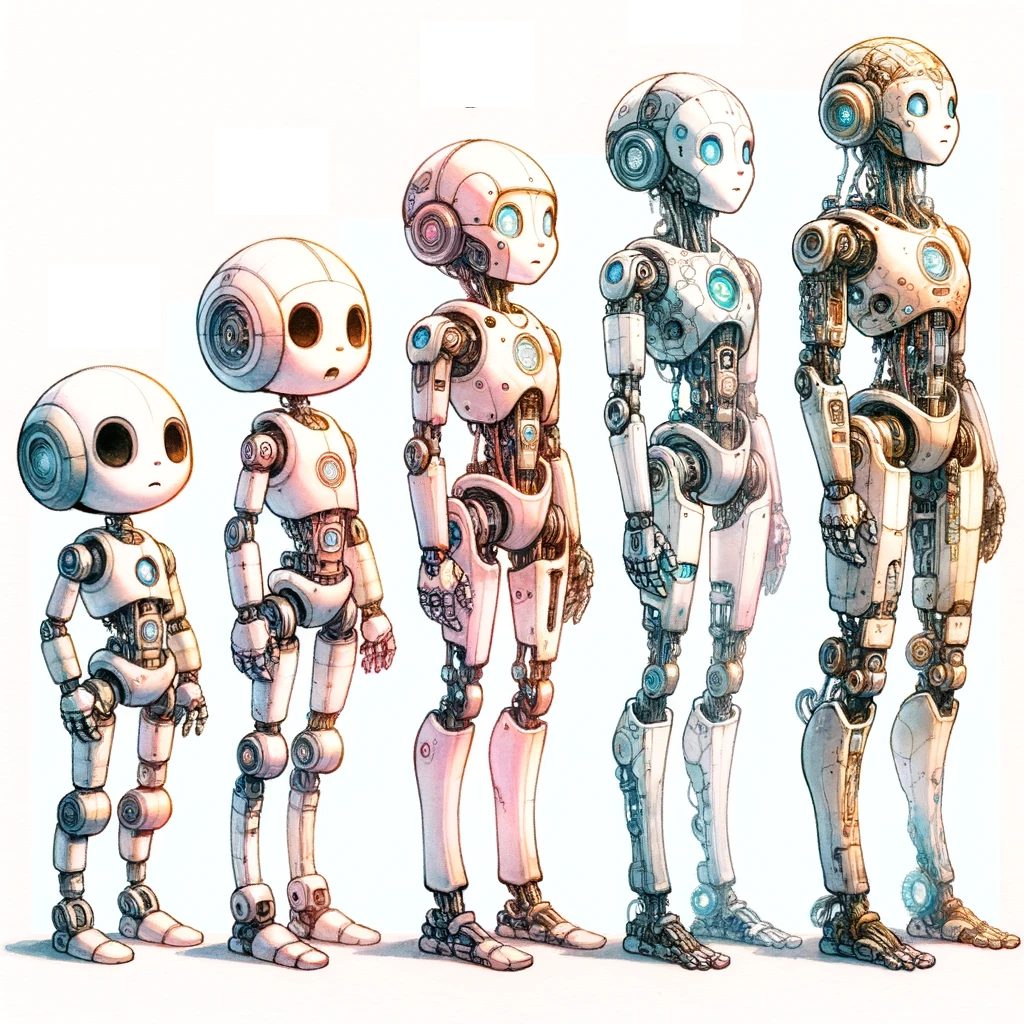

しかし、ほとんどの研究がAIエージェント側の性能向上に集中していて、「人間がどう関わるべきか」の設計はほとんど手つかずです。AIがどんどん賢くなっているのに、人間の役割は再設計されないまま。そのコストが見え始めています。

そこで今回4本の論文を横断し、AIと人間がいかにして協働していくべきかを考えていきます。