本企画では、AIDBのX (旧Twitter) で紹介された最新AI研究を、ダイジェスト形式でお届けします。

普段の有料会員向け記事では、技術的な切り口から研究を詳しく紹介していますが、この企画では科学的な知識として楽しめるよう、テーマの概要をわかりやすくお伝えします。

今週は、「AIがどう考え、ふるまい、理解するか」に迫る注目研究を6本ご紹介します。

人間のように時間をかけて思考する新しいAIモデル、議員の政治的立場を客観的に可視化するLLMツール、触覚と言語を結びつけたロボットの進化、数十年ぶりの発見を成し遂げたコード生成AI、AIの“性格”や“心”を心理テストで測る試みなど、AIの“内面”や“適応力”にフォーカスした研究が並びました。

研究に対する反応が気になる方は、ぜひAIDBのXアカウント (@ai_database)で紹介ポストもご覧ください。中には多くの引用やコメントが寄せられた話題もあります。

また、一部はPosfieにも掲載されており、読者のリアクションをまとめたページもあわせて公開しています。

考える時間を持つAI 人のように悩みながら答えを出す新しい仕組み

人は物事を考えるときに、少しずつ考えを進めながら、簡単なことはサッと判断し、難しいことは時間をかけて考えます。今回Sakana AIなどの研究チームはこれに近いAIの仕組みを新しく作ったとのこと。

脳のように、ニューロンたちがそれぞれ少しずつ違う役割と動きを持ち、互いにタイミングを合わせながら自発的に情報をやりとりするようです。

結果、「内部で思考を重ねる時間」が生まれます。そして迷路のようなタスクでは一歩ずつ慎重に道を探し、画像を見るときは全体を見てから細部を見る、そんな動きが見られるようになったと報告されています。

また、考えを進めるにつれて自信が高まっていく様子も観察されたとのことです。

これらは「思考の過程」そのものを内部に持っていることを示唆しています。

まだ実験段階ですが、ほかにも幅広い課題に柔軟に取り組めることが確認されています。

この先には人間のような創造的な仕事にも応用されることが期待されています。

参考文献

Continuous Thought Machines

https://arxiv.org/abs/2505.05522

Luke Darlow, Ciaran Regan, Sebastian Risi, Jeffrey Seely, Llion Jones

Sakana AI, University of Tsukuba, IT University of Copenhagen

関連記事

政治家の立場が一目でわかるAI 国会発言からスタンスを自動分析

日本の国会議員が国会でどんな立場をとっているのかをAIで客観的に分析する取り組みが行われています。

LLMで国会の発言記録を読み取り、政治家それぞれの政策スタンスを数値として表現する仕組みを作ったとのこと。

「その議員は何を言いたいのか」を抽出し、またテーマごとにどのような対立軸があるのかを自動で見つけ出し、分析者の主観に依存せずに整理するそうです。

過去20年分までさかのぼり、政党ごとの立場がどのように変化してきたかも追跡。

分析結果はウェブサイトで閲覧できるようになっており、有権者が政治家のスタンスを確かめられるツールとして公開されています。

AIが民主主義の透明性を支える実用的な技術であることを示唆するような研究です。

参考文献

KOKKAI DOC: An LLM-driven framework for scaling parliamentary representatives https://arxiv.org/abs/2505.07118

Ken Kato, Christopher Cochrane

University of Toronto

関連記事

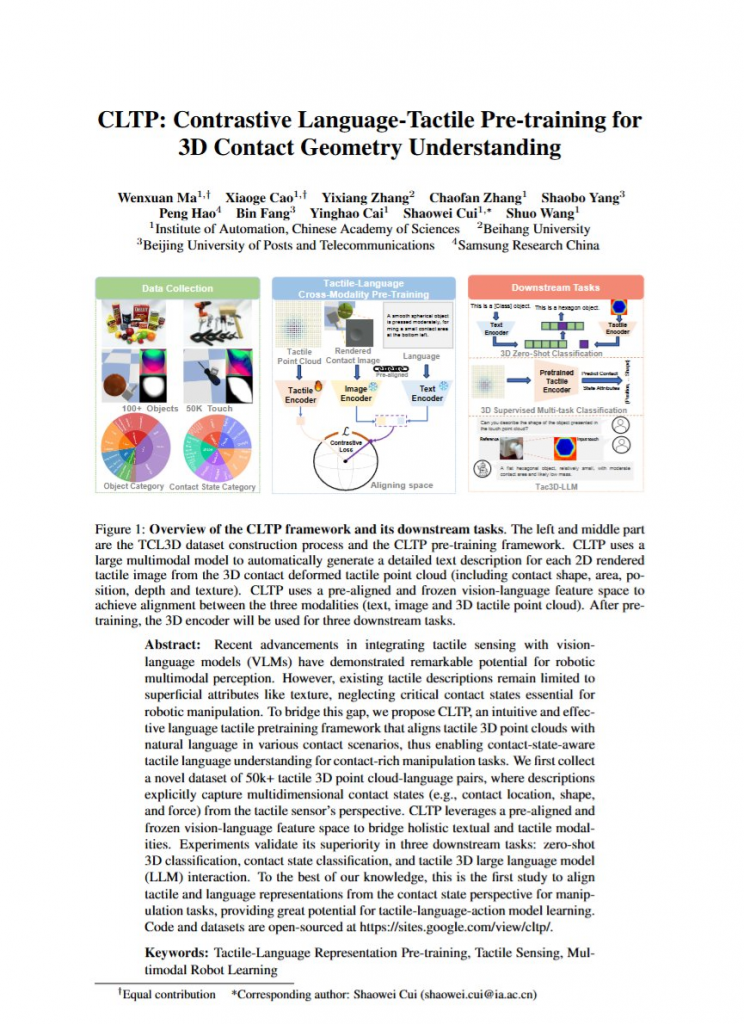

ロボットに「さわる感覚」を教える 触覚と言葉をつなぐAIの挑戦

五感の一つである”触覚”における50,000件以上の言語データで、ロボットに「さわる感覚」を教える取り組みが行われています。

ものの形や触れた場所、力の強さなどを言葉と結びつけることで、たとえば「小さな丸い物体の中央を軽く押した」といった細かい説明ができるようになるとのこと。

また、触った感覚をもとに「こう動かしたほうがいい」といった判断もできるようになります。

果実のように壊れやすい物を扱うときに、「もう少し力を弱めよう」「少し下にずらそう」といった動きを、自分で考えて行えるとのこと。

なお、今回開発されたAIは仮想シミュレーションだけでなく実機でも使用可能であることが報告されています。

見る・聞く・話すに続いて、触れて感じて考える。またひとつ新しい力がロボットにも少しずつ備わっていくことを知らせる事例です。

参考文献

CLTP: Contrastive Language-Tactile Pre-training for 3D Contact Geometry Understanding

https://arxiv.org/abs/2505.08194

Wenxuan Ma, Xiaoge Cao, Yixiang Zhang, Chaofan Zhang, Shaobo Yang, Peng Hao, Bin Fang, Yinghao Cai, Shaowei Cui, Shuo Wang

Institute of Automation Chinese Academy of Sciences, Beihang University, Beijing University of Posts and Telecommunications, Samsung Research China

関連記事

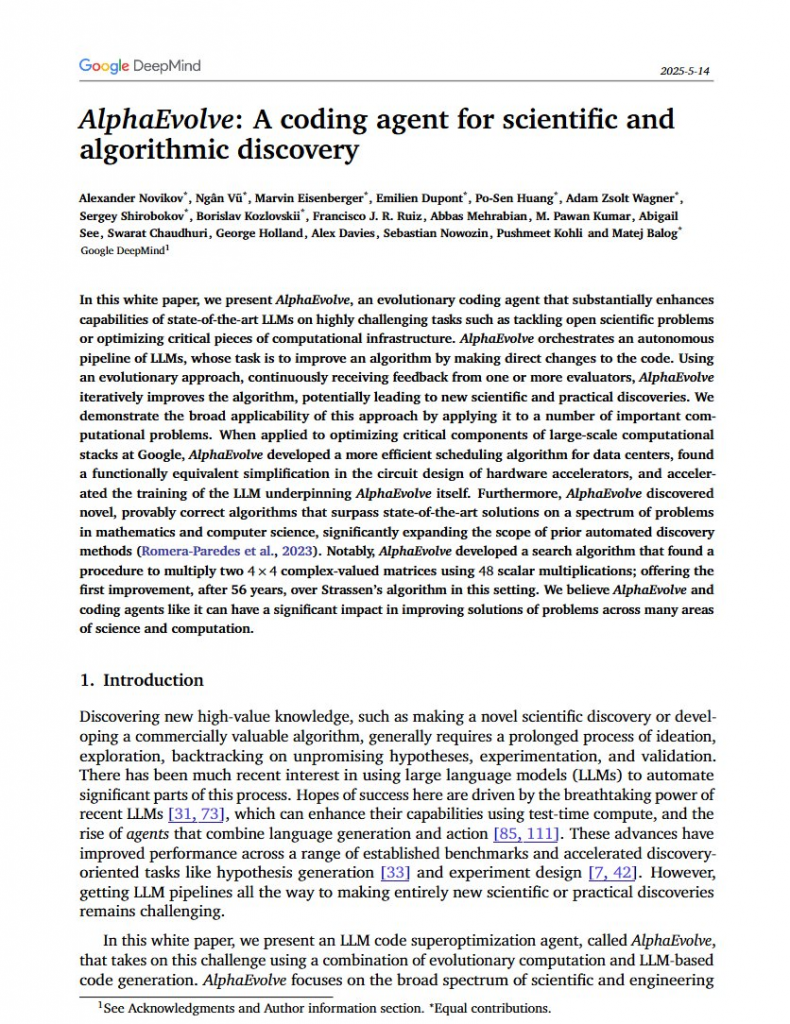

AIが自分でコードを改良し続ける時代へ AlphaEvolveが歴史を塗り替える

Googleが開発した新しいAI技術であるAlphaEvolveは、プログラムを自分で作り直しながら、どんどん改良していく「進化型エージェント」とのこと。Geminiの力と、プログラムを評価する仕組みを組み合わせて、試行錯誤を繰り返しながら最適な解を探します。

注目すべき成果は既に上がっており、何十年も誰も改善できなかった問題に、新しい解決法を見つけてしまったそうです。たとえば、1969年からずっと更新されていなかった行列の掛け算方法に挑戦し、ついに新記録を出しました。

また、Googleのデータセンターのスケジューリングや、AIモデルを学習させるときの計算処理のスピードアップも達成し、実務でも使われはじめています。

これは結果的にAlphaEvolveが自身の効率を自己改良していることになります。

なお、これまでのAIは基本的にはコードの一部しかいじれなかったのに対して、AlphaEvolveはプログラム全体を大きく書き換えられるのが特徴のようです。

そのため、複雑で人間の手では時間がかかるような最適化作業も短時間でこなすことができるとか。

こうしたサイクルが進めば、科学的な発見や計算システムの効率化において、ますます大きな成果をもたらすと期待されています。

なお、現在のモデル構成としてはGemini 2.0 FlashとProのアンサンブルで高速生成と高品質を両立させているそうです。

参考文献

AlphaEvolve: A Gemini-powered coding agent for designing advanced algorithms

Alexander Novikov, Ngân Vũ, Marvin Eisenberger, Emilien Dupont, Po-Sen Huang, Adam Zsolt Wagner, Sergey Shirobokov, Borislav Kozlovskii, Francisco J. R. Ruiz, Abbas Mehrabian, M. Pawan Kumar, Abigail See, Swarat Chaudhuri, George Holland, Alex Davies, Sebastian Nowozin, Pushmeet Kohli, Matej Balog2/2

Google DeepMind

関連記事

AIの性格や心を測る?心理テストでLLMを評価する新しい試み

AIが人間に近い思考や性格のようなものを見せ始めたことで、「人間らしい観点で評価する必要があるのでは?」という声が強まっています。

そこで心理測定学が注目されています。もともとは人間の性格などの“目に見えない特性”を数値化するアプローチですが、最近ではこれを LLMの評価にも応用する試みが進んでいます。

たとえばGPTシリーズは「外向的で協調的、好奇心旺盛だけれど、神経質さは少ない」といった特徴が出るとの報告があります。

さらに面白いことに、他人の気持ちを理解する「心の理論」のテストでは、人間の子どもと同じかそれ以上のスコアを出すこともあります。

ただし、プロンプトの変化によって回答が大きく変わりがちであるという具体的な問題も無視できません。 また、そもそも人間のために作られたテストがAIにも適切なのか?という根本的な問いは存在します。

また、そもそも人間のために作られたテストがAIにも適切なのか?という根本的な問いは存在します。

参考記事

Large Language Model Psychometrics: A Systematic Review of Evaluation, Validation, and Enhancement

https://arxiv.org/abs/2505.08245

Haoran Ye, Jing Jin, Yuhang Xie, Xin Zhang, Guojie Song

Peking University

関連記事

まとめ

AIがどのように考えを深め、自らを改善し、人に寄り添うような判断をするようになってきているのか。そのふるまいの背景には、進化し続ける“仕組み”があります。ときに人間に似たクセを見せ、ときに想像を超える成果を生む。そんなAIの中身を知ることで、私たちの理解も少しずつ広がっていきます。

週末ダイジェストでは、こうしたAIの最新動向を、科学の楽しさとして届けていきます。

来週もまた、AIの進化の先にある未来を、一緒にのぞいてみましょう。