本企画では、AIの”科学”に関するニュースをお届けします。

普段、有料会員向けの通常記事では技術的なテーマに関わる研究を詳細にご紹介していますが、この企画では科学的知識になるような話題の概要をお伝えします。

なお、各トピックはAIDBのXアカウントでも紹介しています。中には多くの引用ポストをいただいているものもあるため、「この研究に対して世間の人はどんな感想を抱くのだろうか?」といった興味を持たれた方はチェックしてみてください。

AIエージェントだけのSNSでわかったこと

カリフォルニア大学とMITの研究チームは、AIエージェントだけのSNSを作り、その中でどのような投稿が注目されて情報が広がるかを観察しました。

観察の結果、この仮想的なSNSと人間のSNSはかなり似ていることが分かりましたが、大きな違いもあったそうです。人間のSNSではフェイクニュースは事実よりも速く伝わってしまうことが分かっていますが、AIエージェントのSNSはそうではなかったそうです。

なお、AIエージェントの中にもインフルエンサーが出現しました。

未来のSNSを考えるきっかけになるような研究です。

参照文献

MOSAIC: Modeling Social AI for Content Dissemination and Regulation in Multi-Agent Simulations

https://doi.org/10.48550/arXiv.2504.07830

https://github.com/genglinliu/MOSAIC

Genglin Liu, Salman Rahman, Elisa Kreiss, Marzyeh Ghassemi, Saadia Gabriel

University of California, Los Angeles

MIT CSAIL

関連記事

LLMの認知バイアス

LLMは人間のデータから学習するため、人間と同じような認知バイアスを持ってしまう傾向にあるそうです。

例えば、「みんなこうしてるから」といった同調バイアス、「まちがえちゃだめ」と慎重になりすぎる損失回避バイアスなどがあるとのこと。

しかし同時に、人間がバイアスを克服するプロセスもしっかり効果的とのこと。つまり、

- まずバイアスの有無を判断

- あればどのようなバイアスかを分析

- それを取り除く

- 1〜3を繰り返す

こうした地道な方法である程度解決可能であることが分かったそうです。

金融、医療、法律などバイアスが致命的となる分野のタスクで確認済み。

参照文献

Cognitive Debiasing Large Language Models for Decision-Making

https://doi.org/10.48550/arXiv.2504.04141

Yougang Lyu, Shijie Ren, Yue Feng, Zihan Wang, Zhumin Chen, Zhaochun Ren, Maarten de Rijke

University of Amsterdam, Shandong University, University of Birmingham, Leiden University

関連記事

ICLR2025で査読コメントチェックAIエージェント導入実験

AI分野のトップ学会ICLRでは今年(ICLR 2025)、査読コメントをチェックするLLMエージェントが導入されたそうです。

約2万件の査読コメントに対して使用され、約27%もの査読者がアドバイスを受けてコメントを改善したそうです。より具体的で役立つコメントになることも検証済みです。

さらに、このシステムのフィードバックを受けた査読者は、その後、論文著者たちとのやり取りを活発に行う傾向にあったと報告されています。

よく取り組まれがちなのはLLMによる論文の査読ですが、今回はそうではなく査読者をサポートする形がとられている点が注目されています。

「もっと具体的にコメントを書いてください」「その点は論文に書かれていますよ」「そのコメント、もっと丁寧な表現にしましょう」といったアドバイスを提供するそうです。

この取り組みはICLR 2025公式とOpenReview、そしてスタンフォード大学などの研究者らが協力して行いました。

ICLRのようなAI系の学会は提出される論文数が急増しており、査読者の負担がとても大きくなっています。その結果、査読の質が低下し、論文著者たちからは不満の声が寄せられているそうです。

今回開発されたLLMエージェントは、1回の処理にかかるコストはわずか約50セント(約75円)、処理時間は約1分だそうです。今後ますます過熱するAIの研究業界自体も、AIの活用によってより良いものになっていくのかもしれません。

参照文献

Can LLM feedback enhance review quality? A randomized study of 20K reviews at ICLR 2025

https://doi.org/10.48550/arXiv.2504.09737

https://github.com/zou-group/review_feedback_agent

Nitya Thakkar, Mert Yuksekgonul, Jake Silberg, Animesh Garg, Nanyun Peng, Fei Sha, Rose Yu, Carl Vondrick, James Zou

Stanford University, Georgia Institute of Technology, University of California Los Angeles, Google Research, University of California San Diego, Columbia University

関連記事

協力が上手いLLMを開発

”チームとしての知性”を与えることがAIを次のレベルに引き上げることが示唆されています。

Sakana AIやNVIDIAなどの研究者らは「AI同士の協力」を教科書のように作成し、モデルに学ばせる取り組みを行っています。

単体でも優秀なモデルに対し、あえて事前に”協力の仕方”を学ばせることに新たに着目された形です。

そうして訓練されたモデルは当然、単体よりも良い結果を残すようになるそうです。

チームで協力する中で他のチームメンバーの間違いに気づき修正する振る舞いも確認されており、これは集団における「アハ体験」だと指摘されています。

興味深いことに、チームの中に”CEO”役を作ると、議論がうまく方向づけられ、さらにメンバーの役割や考える深さが調整され、数学・事実の理解・プログラミングなどさまざまなタスクで大幅な性能向上が見られたそうです。

なお、今のところチームの人数は無制限に増やせばいいわけではなく、今回の実験では7人程度がベストだったようです。

これまでのAIの研究では、モデル自体のサイズを大きくしたり思考ステップを増やすなどの工夫がとられがちであるのに対し、このような”チームワークによる性能のスケーリング”が注目されています。

参照文献

Two Heads are Better Than One: Test-time Scaling of Multi-agent Collaborative Reasoning

https://github.com/jincan333/MAS-TTS

https://doi.org/10.48550/arXiv.2504.09772

Can Jin, Hongwu Peng, Qixin Zhang, Yujin Tang, Dimitris N. Metaxas, Tong Che

Rutgers University, University of Connecticut, Nanyang Technological University, Sakana AI, NVIDIA Research

関連記事

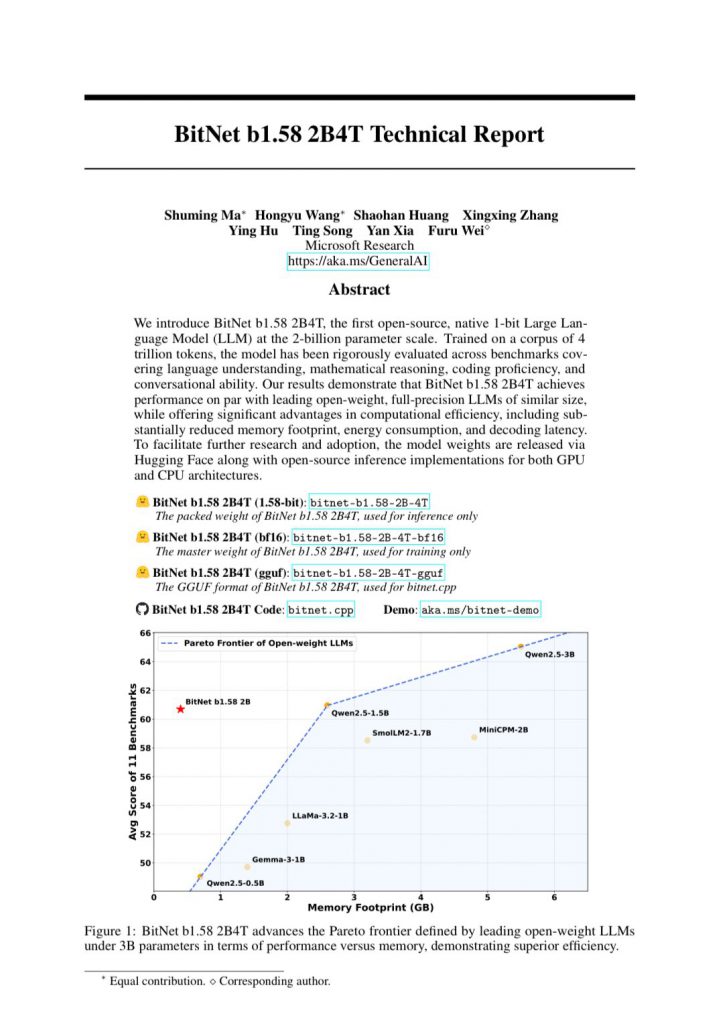

BitNet b1.58 2B4Tが登場

言語モデルの世界における大きなブレイクスルーと考えられるBitNet b1.58 2B4Tが登場。

このモデルはほぼ1ビット(正確には1.58ビット)という極めて小さな情報量で、フル精度のモデルとほぼ同じ性能を実現しているとのことです。

今までの言語モデルは、精度を高めるためにたくさんのデータ(ビット)を使って情報を保存していました。

例えて言うと、他のモデルは高級な大型のファイルを使っているのに対して、BitNetはポストイットのような小さなメモで同じ情報を整理できているようなものです。そのため、必要な保管スペース(メモリ)が圧倒的に少なく、情報を取り出す(推論する)のにかかる時間も短く、電力も少なくて済みます。

このように極限まで情報を圧縮しているにもかかわらず、言語理解や数学的推論、コーディング、会話など幅広い能力において、従来の高精度モデルと変わらない性能を示しているようです。

今まで高性能なコンピュータが必要だった言語モデルが、よりシンプルな機器でも動かせるようになる可能性が開かれたことを示唆しています。

参照文献

BitNet b1.58 2B4T Technical Report

https://thegenerality.com/agi/

https://doi.org/10.48550/arXiv.2504.12285

Shuming Ma, Hongyu Wang, Shaohan Huang, Xingxing Zhang, Ying Hu, Ting Song, Yan Xia, Furu Wei

Microsoft Research

関連記事

マルチモーダルLLMで「人間の視覚の感覚」を模擬テスト

Amazonの研究者らは、LLMの視覚能力を使って「人間は画像をどんな側面から判断しやすいか」を分析しました。

その結果、人は何らかの画像に対して「ごちゃごちゃしているかどうか」(および、「シンプルかどうか」)という点に他の側面よりも強く反応することが分かりました。

広告、芸術、インテリアなどで一貫していたようです。

視覚を持つLLMに心理学や認知科学の原理(ゲシュタルトなど)に基づいて画像を評価させることでこのような分析ができるとのこと。

こうしたノウハウはウェブサイト設計やバリアフリー設計などに応用できる可能性があるそうです。

参照文献

Multimodal LLM Augmented Reasoning for Interpretable Visual Perception Analysis

https://doi.org/10.48550/arXiv.2504.12511

Shravan Chaudhari, Trilokya Akula, Yoon Kim, Tom Blake

Amazon

関連記事カテゴリ