本記事では、LLMがより上手く論理的な考え方ができるようにする新しい方法「Logic-of-Thought(LoT)」を紹介します。LoTは、今までの方法で起こっていた「大切な情報が抜け落ちてしまう」という問題を解決しようとしています。

LoTの優れているポイントは、今まで使われてきたChain-of-Thought(CoT)やSelf-Consistency(SC)、Tree-of-Thoughts(ToT)といった方法と一緒に使えることです。実験では、LoTを使うと確かにLLMの能力が上がることが分かりました。

この研究の主な成果は3つあります。1つ目は新しいLoTという方法を考え出したこと、2つ目は他の方法とLoTを組み合わせたこと、3つ目は様々な課題でLoTが役立つことを確かめたことです。

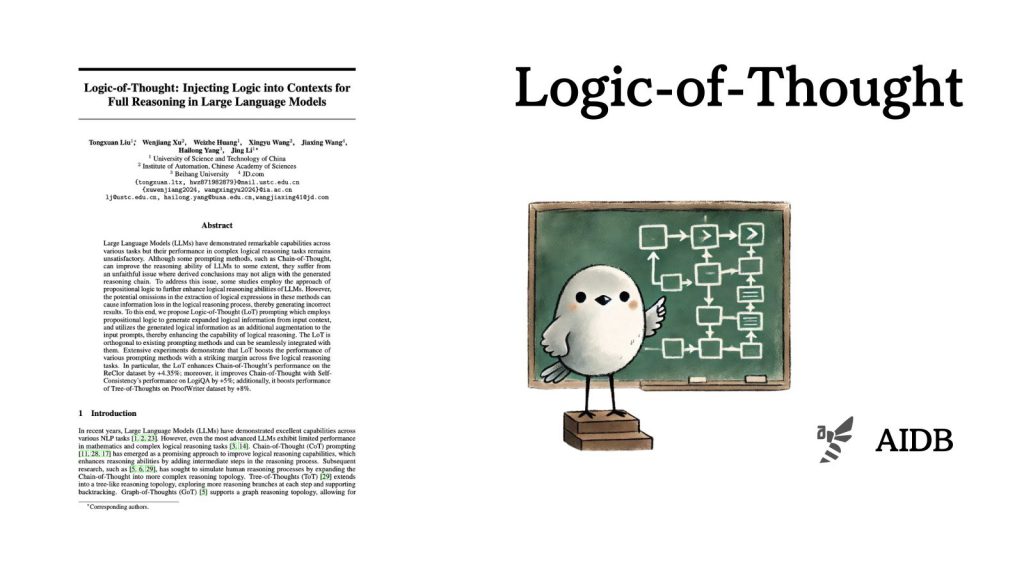

参照論文情報

- タイトル:Logic-of-Thought: Injecting Logic into Contexts for Full Reasoning in Large Language Models

- 著者:Tongxuan Liu, Wenjiang Xu, Weizhe Huang, Xingyu Wang, Jiaxing Wang, Hailong Yang, Jing Li

- 研究機関:University of Science and Technology of China, Institute of Automation, Chinese Academy of Sciences, Beihang University, JD.com

背景

多くのLLMは、数学や複雑な論理的な考え方が必要な問題になると、まだ人間には及びません。

よく使われるのが「Chain-of-Thought(思考の連鎖)」というプロンプティング手法で、難しい問題を小さな段階に分けて考えていくアプローチです。人間が頭の中で「ここからこう考えて、次にこうなって…」と段階を踏んで考えるのと似ています。

Chain-of-Thoughtが考案された後、Tree-of-ThoughtsやGraph-of-Thoughtsといった、より複雑な考え方の流れを真似る方法も生まれました。人間の頭の中でいろいろな考えが枝分かれしたり、つながったりする様子を模倣しようとする手法です。

ところが、これまでに考案されたどの方法を使っても「途中の考え方は正しいのに、最後の答えがそれと合わない」といった現象が起きます。これを「不忠実な推論」と呼びます。

この問題を解決しようと、今度は論理学の考え方を取り入れる試みも始まりました。例えば、文章から論理式という特別な形の式を取り出して、それを使って考えを進める方法などです。しかし、この方法にも弱点がありました。文章から論理式を作る時に、大切な情報が抜け落ちてしまうことがあるのです。そうすると、正しい答えにたどり着けません。

こういった事情から、研究者たちは今回、論理的な考え方の精度を上げながら、かつ大切な情報を落とさない新しい方法を考案しました。

以下で詳しく紹介します。