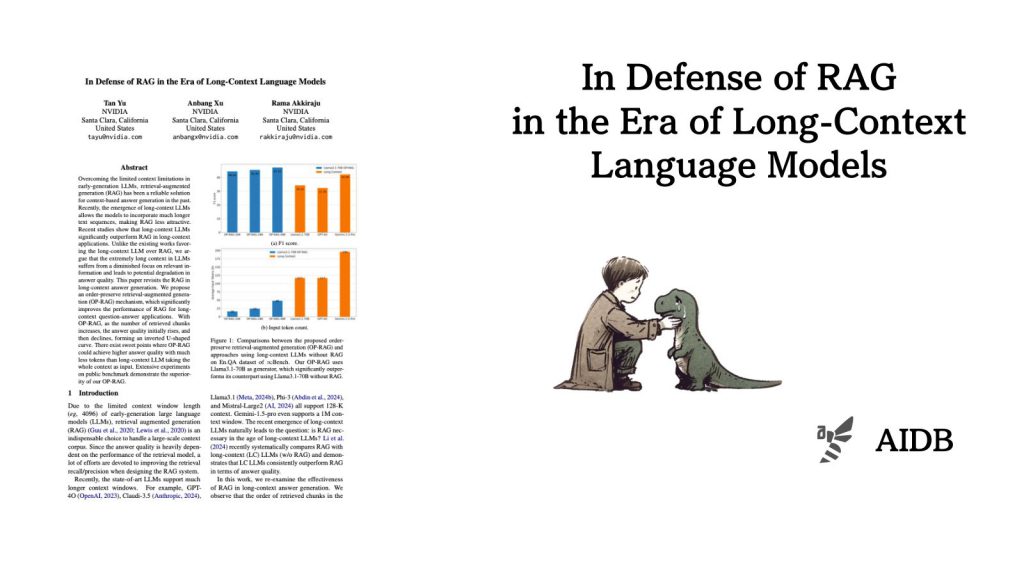

この記事では、LLMが長い文章を理解できる時代においてもRAG(検索拡張生成)がどれほど役立つかを改めて調べた研究を紹介します。

研究チームは、検索で見つける情報の「量」と「品質」の関係が、ひっくり返したU字のような形になることを見つけました(どういう意味かわからない方は後述の説明をご覧ください)。

この研究で分かったのは、現在のLLMが理解できる文章の長さを最大限しようせずとも、もっと少ない言葉で質の高い答えを作れる「ちょうどいい」ポイントがあるということです。効率よく情報を探し、必要な部分だけをうまく使うことが大切だということを教えてくれています。

参照論文情報

- タイトル:In Defense of RAG in the Era of Long-Context Language Models

- 著者:Tan Yu, Anbang Xu, Rama Akkiraju

- 所属:NVIDIA

背景

LLMは日進月歩で発展し、最近では長い文章を理解する能力が強くなってきました。GPT-4oやClaude-3.5、Llama3.1などの新しいモデルは、128,000語もの長い文章を扱えます。さらに、Gemini-1.5-proは100万語もの文章を一度に処理できます。

この発展の影響で、RAGが本当に必要なのか疑問視されるようになってきました。RAGは、LLMが短い文章しか扱えなかった頃(例えば4,096語まで)には特に、多くの情報を扱うために欠かせない方法でした。

最近の調べでは、長い文章を理解できるLLMの方がRAGよりも良い答えを出す場合があることが分かっています。

しかし今回NVIDIAの研究者らは、「LLMに長すぎる文章を与えると、かえって大切な情報を見逃して、答えの質が下がるかもしれない」と考えました。つまり、ただ長い文章を与えれば良いわけではなく、必要な情報をうまく探して、的確に使うことの方が大切なのではないかと考えたのです。

こうした理由から、長い文章を扱う時のRAGの役立ち方を、もう一度よく調べる必要が出てきました。そして、検索した文章の順番を保ったまま使う新しいRAGの仕組みを作ることで、長い文章を扱うLLMの問題点を解決できるのではないかと考えられました。

この研究は、急速に進歩するLLM技術の中で、情報をうまく探して、的確に使うことの大切さを見直し、RAGの新しい可能性を探ることを目指しています。長い文章を理解できるLLMの時代でも、しっかりと設計されたRAGシステムが重要な役割を果たせる可能性を示すことが、この研究の目的となっています。

以下で実験内容と結果を詳しく紹介します。