LLMが一度に処理できる文章の長さには限界があり、また長い文章になるほど性能が低下するという問題が指摘されています。

そこでGoogleの研究者らは、人間の読解プロセスに着想を得たアプローチ「ReadAgent」を提案しています。この方法論によりLLMが処理できる文脈の長さを最大20倍に拡張し、様々な長文読解タスクでの性能向上を実現したとのことです。

参照論文情報

- タイトル:A Human-Inspired Reading Agent with Gist Memory of Very Long Contexts

- 著者:Kuang-Huei Lee, Xinyun Chen, Hiroki Furuta, John Canny, Ian Fischer

- 所属:Google DeepMind, Google Research

背景

大規模言語モデル(LLM)が一度に処理できる文章の長さには限界があります。

また、たとえ制限内の長さ(コンテキストウィンドウ範囲内の文章量)であっても、文章が長くなるほど性能が低下してしまうのです。

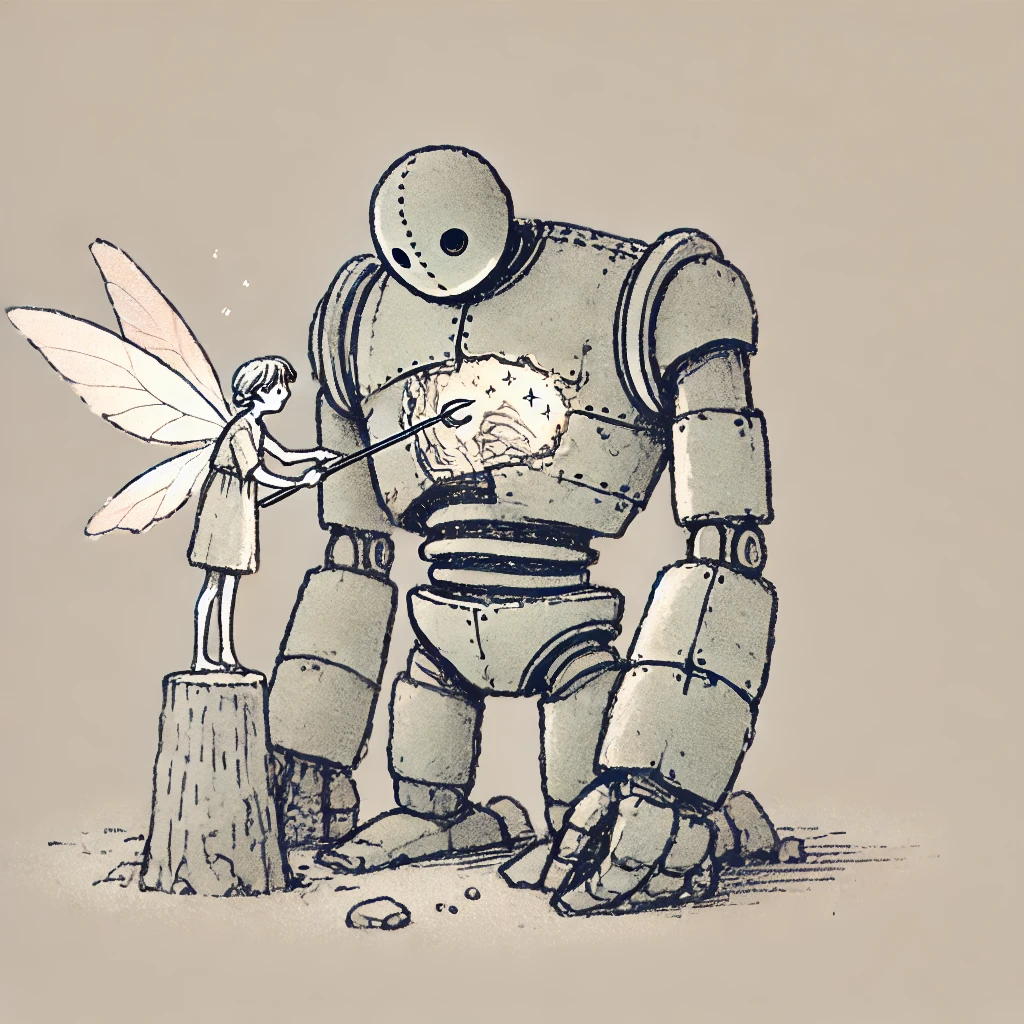

一方で、人間は分厚い本を読んだり、長い文章を理解したりするのが得意です。なぜ両者(LLMと人間)に差が生じるのでしょうか?読み方の違いが、その根本的な理由だと考えられています。

LLMは、与えられた文章を単語ごとに忠実に処理します。

それに対して、人間の読解プロセスはもっと双方向的です。正確な情報はすぐに忘れてしまいますが、読書から得た大まかな要点は長く記憶に残ります。そして、詳細な情報が必要になったら、元の文章を見返すのです。つまり全体的なコンテキストを把握しつつ、ローカルな詳細情報にも注目することで、人間は効率的に長い文章を理解できると考えられています。このようなプロセスがLLMによる文章の真の理解においても役立つ可能性があります。

なお、これまでにもLLMに長い文章を処理させるいくつかのアプローチが研究されてきました。モデルを長い文脈で訓練したり、アーキテクチャを工夫したりする方法などが提案されています。しかし、まだ限界があることが示唆されています。

また、検索技術を用いてモデルの知識を拡張する検索拡張生成(RAG)も研究されています。大規模なデータベースから関連情報を検索する手法は有用ではあるものの、密接に関連する長い文書の処理には適していない可能性があります。

以上の背景を踏まえ、今回ReadAgentという新しいアプローチが提案されました。前述した人間の読解プロセスにヒントを得たLLMのエージェントシステムです。対話型のプロンプトを用いて、長い文章を効果的に処理します。実験の結果、モデルが効果的に処理できる文脈の長さが大幅に拡張され、様々なタスクでの性能向上が確認されています。以下で詳しく紹介します。