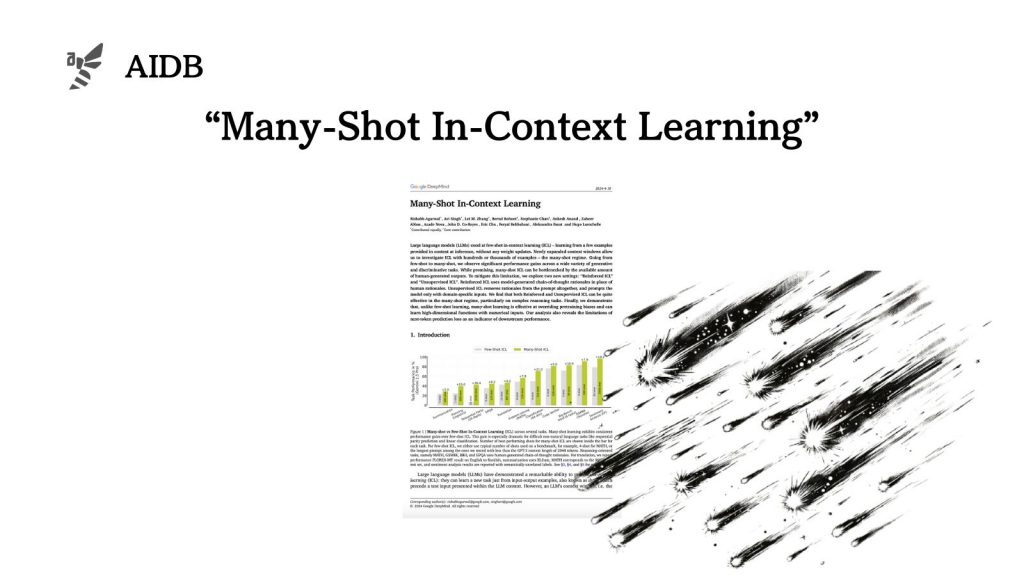

プロンプトに例示を含めることにより新しいタスクを学習させられる「コンテキスト内学習(In-context Learning、ICL)」が注目を集めています。

これまでの研究は数ショットで行われてきましたが、今回Googleの研究者らは、「多ショット学習(Many-shot Learning)」の可能性を探っています。最新のLLMの長いコンテキストウィンドウを活用し、数百から数千もの例を用いた実験を行ったのです。

多様なタスクにおける性能向上や、人間のデータに依存しない新しい学習法など、多ショットの効果と特性が詳細に分析されました。

参照論文情報

- タイトル:Many-Shot In-Context Learning

- 著者:Rishabh Agarwal, Avi Singh, Lei M. Zhang, Bernd Bohnet, Stephanie Chan, Ankesh Anand, Zaheer Abbas, Azade Nova, John D. Co-Reyes, Eric Chu, Feryal Behbahani, Aleksandra Faust, Hugo Larochelle

- 所属:Google DeepMind

背景

LLMのコンテキスト内学習においては、プロンプトで提供されるわずか数例から新しいタスクを学習することができると示されています。パラメータの更新は一切必要ないため、非常に便利な特性です。

しかし数ショット(数個の例)で効果が出ている一方、多ショットだとどうなるのか?Googleの研究者らはそう疑問を持ちました。これまで多ショットの研究はほとんどされてきていません。

最近LLMの文脈ウィンドウ(LLMが一度に処理できるトークン化された入力の量)が拡大してきたため、数百から数千もの例を用いた実験が可能です。例えば2024年2月にリリースされたGemini 1.5 Proでは、文脈長が100万トークンにまで拡大しました。

うまくいけば多ショットによってLLMがより多様なタスクに適応でき、有用性が増すのかもしれません。

研究者らは、プロンプトにおける例示の数を増やすことが、LLMの性能にどのような影響を与えるかを体系的に評価しました。

タスクとしては、機械翻訳、要約、計画、報酬モデリング、数学的問題解決、科学的質問応答、アルゴリズム的推論など、多様な種類が試されました。

さらに、人間が例を用意する代わりにモデルが例を生成する挑戦的な実験も行われました。