GPT-4は、OpenAIが開発した大規模言語モデルで、ChatGPTなどで使用できるモデルの一種です。また、APIを通じて開発ツールとしても提供されています。

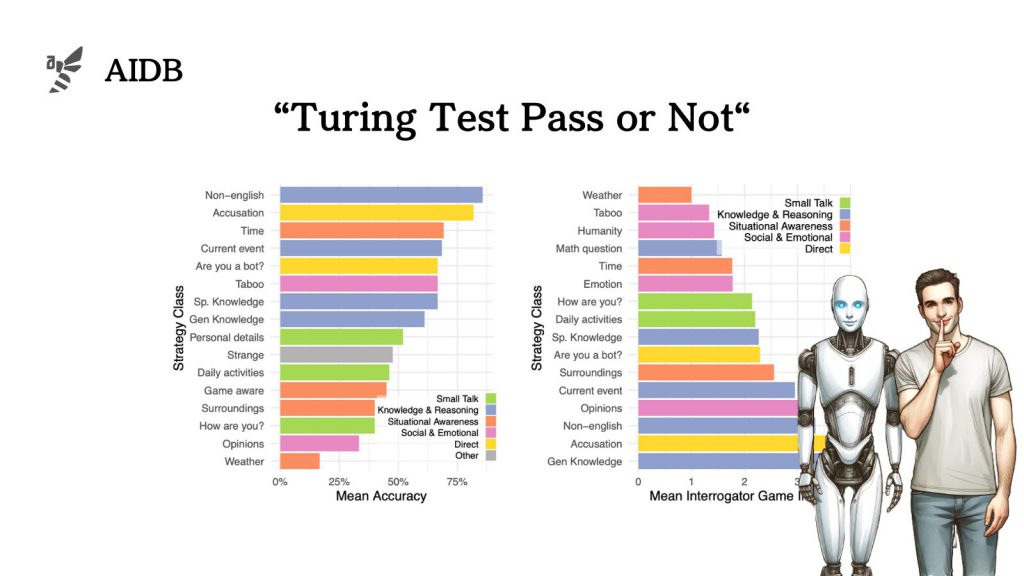

今回、GPT-4は「チューリングテスト」(AIが人間と区別できないほど自然に振る舞えるかどうかを調べる実験)において、一定の成績を達成したという報告がされています。この成績は、以前のモデルであるGPT-3.5や、初期のAIであるELIZAを上回っており、AIの進化を示す重要なデータといえます。ただし、人間のレベルにはまだ達していません。

本研究はカリフォルニア大学サンディエゴ校の研究チームによって実施されました。研究結果は、AI技術の発展だけでなく、社会におけるAIの役割や影響を理解するうえでも役立つものです。

ただし、これらの結果は特定の条件下でのものであり、すべての状況においてGPT-4が人間と同じように振る舞えるわけではありません。本記事では、以上のポイントを踏まえたうえで、GPT-4とチューリングテストに関する研究の概要を紹介します。

本研究の関連記事:LLMは世界モデルを持ち「物事がどのように位置づけられ、時間がどのように進行するか」を理解する可能性

背景

チューリングテストは、1950年にアラン・チューリングによって提案されたもので、「機械が人間と区別がつかないほど自然にコミュニケーションできるかどうか」を評価するために考案されました。

チューリングは、このテストを、質問に答えるゲーム形式で行うことを提案しました。ロマンチックな話題から数学まで、幅広いテーマに関するオープンな質問に機械が自然に回答できるかを試すことで、知能を測定できると考えたのです。

チューリングテストは発表以来、広く知られるようになりましたが、その一方で、知能の評価基準としての限界について批判も受けてきました。批評家の中には、「このテストだけでは知能の本質を完全に測ることはできない」と指摘する声もあります。

とはいえ、AI研究が盛んな現代においても、チューリングテストは、「自然なコミュニケーション能力」や「人間を欺く能力」を測定する手法として依然として有効とされています。

AIが人間のように振る舞えるようになれば、社会に与える影響は大きくなります。そのため、チューリングテストの評価基準としての有効性を改めて検討することも重要です。

また、チューリングテストは単に機械を評価するだけでなく、テストを行う人間(尋問者)自身についても、間接的に文化的・倫理的・心理的な背景を掘り下げることにつながっています。尋問者が質問を考え、それを洗練させる過程で、「人間らしさとは何か」「人間らしさのうち、最も模倣が難しい要素は何か」を暗黙的に明らかにするのです。

実験デザイン

研究者らは、チューリングテストの有効性を確かめるため、また現代におけるAIがどの程度人間に近いのかを知るために、GPT-4をチューリングテストで評価する実験を行いました。

以下で詳しく紹介します。