この記事では、大規模言語モデル(LLM)の理解を向上させるための新しい手法、メタ認知プロンプティング(Metacognitive Prompting)について紹介します。この研究がどのようにしてLLMの理解を深めるのかについて詳しくみていきます。

参照論文情報

- タイトル:Metacognitive Prompting Improves Understanding in Large Language Models

- 著者:Yuqing Wang, Yun Zhao

- 所属:カリフォルニア大学サンタバーバラ校、Meta Platforms, Inc.

- URL:https://doi.org/10.48550/arXiv.2308.05342

- GitHub:https://github.com/EternityYW/Metacognitive-Prompting

関連研究

- Metaの研究者ら「GPT-4をきびしくサポートする」AIのShepherd(シェパード)開発

- 大規模言語モデルへのプロンプト、重要な情報はどこに書く?

- ChatGPTの”ふるまいの変化”を定量的に分析した結果

大規模言語モデルの現状

大規模言語モデル(LLM)は、特定のクエリや文に対して正確な出力を生成するために設計されています。また、現在の研究は主にLLMの推理能力の向上に焦点を当てており、多段階の推理や自己整合性の技術などが開発されています。

しかし、ユーザー側のプロンプティングの工夫によりパフォーマンスを高めることも可能です。そこで一役買うと期待されているのがメタ認知です。

メタ認知は、複雑な問題解決や意思決定における鍵となる要素であり、抽象的な概念を分解し、シナリオを批判的に評価し、推理を微調整する能力の基盤となっています。この高次認知プロセスは、人間が「思考についての思考」を行う能力を反映しています。

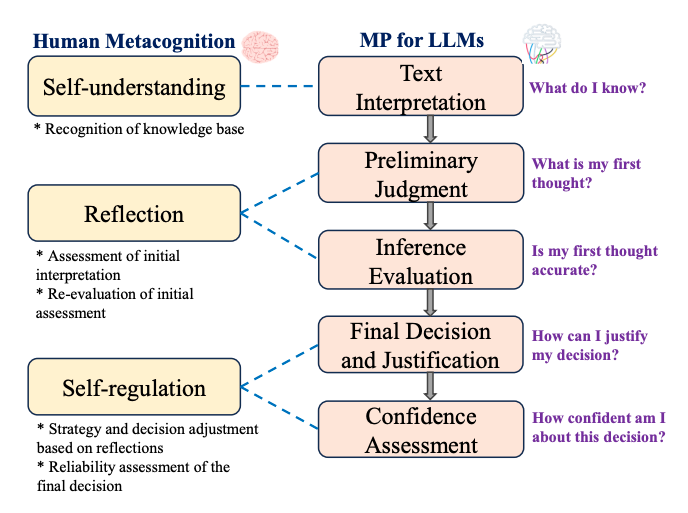

今回紹介する研究の主要な目標は、言語モデルに人間の「思考についての思考」を模倣するメタ認知プロセスを導入することです。このプロセスは、人間の認知の段階を反映した連続した認知のステージから構成されます。

そもそもメタ認知とは何か

メタ認知は、自分の思考プロセスとそれらの背後にあるパターンへの認識を指します。この用語は、ギリシャ語の「meta」(超える、または上に)から来ており、問題解決の特定の戦略をいつ、どのように使用するかを知り、反映する形態を取る能力を意味します。

メタ認知の種類

- メタ認知的知識: 自分自身と他人としての認知プロセッサーについての知識。

- メタ認知的調整: 認知と学習経験を制御する一連の活動を通じて、自分の学習をコントロールする。

- メタ認知的経験: 現在進行中の認知的努力と何か関係がある経験。

メタ認知の重要性

メタ認知は、思考、学習、倫理的/道徳的規則の適切な評価の最大化に役立つ能力を規制するために使用される高次認知です。また、応答時間の短縮や問題やタスクの完了時間の削減にもつながる可能性があります。

メタ認知の研究は、自己に関連するものだけでなく、他人の精神的プロセスについての信念、文化的影響、自己に対する信念など、より広い視野をもって行われています。

メタ認知プロンプティングの導入

今回Metaなどの研究者らが開発したメタ認知プロンプティング(MP)は、LLMのタスク処理を強化し、応答における文脈認識と内省を向上させるための構造化されたアプローチです。MPは、人間の認知プロセスを模倣する段階を通じて、モデルをより深い内省に促します。

MPは5つの異なる段階からなり、入力テキストの理解から始まり、人間の認知プロセスを模倣します。またMPは、標準的なプロンプティングとCoTプロンプティングとは異なるガイドラインと目的を持ちます。

メタ認知プロンプティングの5つの段階

また記事の購読には、アカウント作成後の決済が必要です。

※ログイン/初回登録後、下記ボタンを押してください。

AIDBとは

プレミアム会員(記事の購読)について

■サポートのお願い

AIDBを便利だと思っていただけた方に、任意の金額でサポートしていただけますと幸いです。

PAGE TOP

PAGE TOP