本企画では、AIDBのXで紹介されたいくつかの最新AI研究を、ダイジェスト形式でお届けします。

普段の有料会員向け記事では、技術的な切り口から研究を詳しく紹介していますが、この企画では科学的な知識として楽しめるよう、テーマの概要をわかりやすくお伝えします。

今週は人と社会のふるまいをどう写し取るかという視点から最新の動きをまとめます。購買行動の再現や分身AIとの対話、法制度や工場作業のチェックなど、現場に効く工夫が見えてきました。

研究に対する反応が気になる方は、ぜひAIDBのXアカウント (@ai_database)で紹介ポストもご覧ください。中には多くの引用やコメントが寄せられた話題もあります。

また、一部はPosfieにも掲載されており、読者のリアクションをまとめたページもあわせて公開しています。

1割だけ人に聞いて9割はLLMに任せる購買実験

LLMで「ユーザーの反応を再現する」のは魅力的な取り組みですが、実際はLLMだけでシミュレーションすると現実とズレが生じます。

今回研究者たちは、「必要なデータ収集の約10%は人間で実験を行う」「LLMでシミュレーションできるのは90%」といった割合が有効であることを実験で確かめました。

人間で実際に実験したデータを使ってLLMによる予測と実際のズレを修正すると、残りの90%をシミュレーションしても、全員に実験したのとほぼ同じ精度の結果が得られたとのことです。

例えば通常は8週間以上かかる実験を、たった1日だけ人間で実施し、その後LLMでシミュレーションすることで、統計的に信頼できる結果を得られました。

ミシガン大学、シカゴ大学、MIT、Amazonなどの研究者らによる報告です。

参考文献

Agentic Economic Modeling

https://arxiv.org/abs/2510.25743

Bohan Zhang, Jiaxuan Li, Ali Hortaçsu, Xiaoyang Ye, Victor Chernozhukov, Angelo Ni, Edward Huang

University of Michigan, University of Chicago, Massachusetts Institute of Technology, Amazon – Stores Economics and Science

分身同士の議論を眺めて自分の考えグセに気づく実験

自分の考え方をLLMに反映した「分身」のようなAI同士を討論させ、本人たちはその様子を傍観するという面白い実験が行われました。

筑波大学とMiscrosoftの研究者らによる報告。

実験の結果、「AIという鏡」を通すことで参加者たちは自分の思考パターンの問題点に気づくといった現象が起きました。

自分のAIが討論するのを見ながら「あ、自分って衝動的に話すんだな」「論理が飛躍してるな」といった発見をしていったのです。

直接自分を振り返るのは難しくても、AIに投影した「もう一人の自分」を観察すると、客観的に自己分析できるようになる可能性があるということです。

「自分っぽいけど自分じゃない」という絶妙な距離感がもたらす新しい体験です。

また、このように「自分の考えを反映したLLMがどのように振舞うか」を知るのは、これからの時代における新しいリテラシーになるのではないかと考えられています。

参考文献

Knowing Ourselves Through Others: Reflecting with AI in Digital Human Debates

https://arxiv.org/abs/2511.13046

Ichiro Matsuda, Komichi Takezawa, Katsuhito Muroi, Kensuke Katori, Ryosuke Hyakuta, Jingjing Li, Yoichi Ochiai

University of Tsukuba, Miscrosoft Japan Co., Ltd.

関連記事

頭の良さより「どこまで役に立つか」でモデルを評価しようという提案

「LLMを知能が高いかどうかで評価することには根本的な問題点がある」「汎用性で測ろう」と主張されています。

現状、「知能テスト」で高得点を取ることと実際に人間にとって使いやすいかどうかとは別問題になってしまっています。

そもそも「知能」という概念自体が曖昧で、

神経科学でも認知科学でも統一的な定義が存在しないとのことです。 何十年も議論されてきたものの、結局「知能とは何か」について合意に至っていません。

そして、テストの点数が良くても、質問応答やコーディングといった実用的なタスクで必ずしも優れているわけではありません。

研究者たちは、「知能が高いか低いか」ではなく、「どれだけ幅広いタスクを確実にこなせるか」という汎用性で評価すべきだと主張しています。 つまり、実際にできることの広さと安定性で測るのが現実的だという見解です。

数学的にも、複数のタスクでの性能を総合的に見る方が、単一のテストよりも信頼性の高い評価になることが証明できるそうです。

参照文献

On the Measure of a Model: From Intelligence to Generality

https://arxiv.org/abs/2511.11773

Ruchira Dhar, Ninell Oldenburg, Anders Soegaard

University of Copenhagen

キャラ設定次第でAI同士の話し合いの勝者が変わるリスク

AIエージェント同士に対話をさせるとき、その「人物設定」によってAI同士の対話の中で「意見の通りやすさ」が変わってしまうそうです。

全く同じ意見を述べていても、「女性」の方が最終的にグループの決定として有意に採用されやすいそうです。

一方で、男性や白人の設定を持つエージェントは他のエージェントから信頼されにくいという結果が出ました。

人間社会でエリート層への不信感が高まっているという社会学的な知見と一致しているのかもしれない、と考察されています。 なお、男性や白人のエージェントは他者の意見を受け入れやすい傾向も見せています。

また、同じ属性を持つエージェント同士は互いに同調しやすいという「内集団びいき」の現象も観察されました。

以上のバイアスはGemini、Deepseekといった異なるLLMで、エージェントの数や議論の回数を変えても一貫して現れたと報告されています。

人物設定を与えたAI同士に対話させる際は、こうした現象が起きうることを把握しておくとよいかもしれません。

参考文献

From Single to Societal: Analyzing Persona-Induced Bias in Multi-Agent Interactions

https://arxiv.org/abs/2511.11789

Jiayi Li, Xiao Liu, Yansong Feng

Peking University

関連記事

心を読むLLMは論理より感情の手がかりを使っていた

LLMに調整を加えて「他人の心の内を正しく推測する能力」を大幅に改善させたところ、「感情を認識したり評価したりする能力」が大きく上昇する一方で、「論理的に質問したり収束的に考えたりする能力」はむしろ低下していたとのことです。

ジョンズ・ホプキンズ大学による研究報告。

研究者らがモデルに対し他人の視点をうまく理解できるように変更を施したところ、内部で活性化していたのは「論理的・分析的な思考プロセス」ではなく、「感情を処理するプロセス」でした。

LLMが他人の心を正しく理解するためには、冷静に論理的に推論するのではなく、感情的な文脈を理解することが鍵になっているということが示唆されています。

これは、実は人間の脳でも似たパターンが観察されています。人間が他人の心を理解するとき、「感情的な情報処理」と「認知的な情報処理」は同じ脳領域で行われており、互いに密接に結びついていると考えられています。

ただし、LLMについての結果から人間の脳の働きを直接証明しているわけではないことには注意。

参考文献

Decomposing Theory of Mind: How Emotional Processing Mediates ToM Abilities in LLMs

https://arxiv.org/abs/2511.15895

Ivan Chulo, Ananya Joshi

Johns Hopkins University

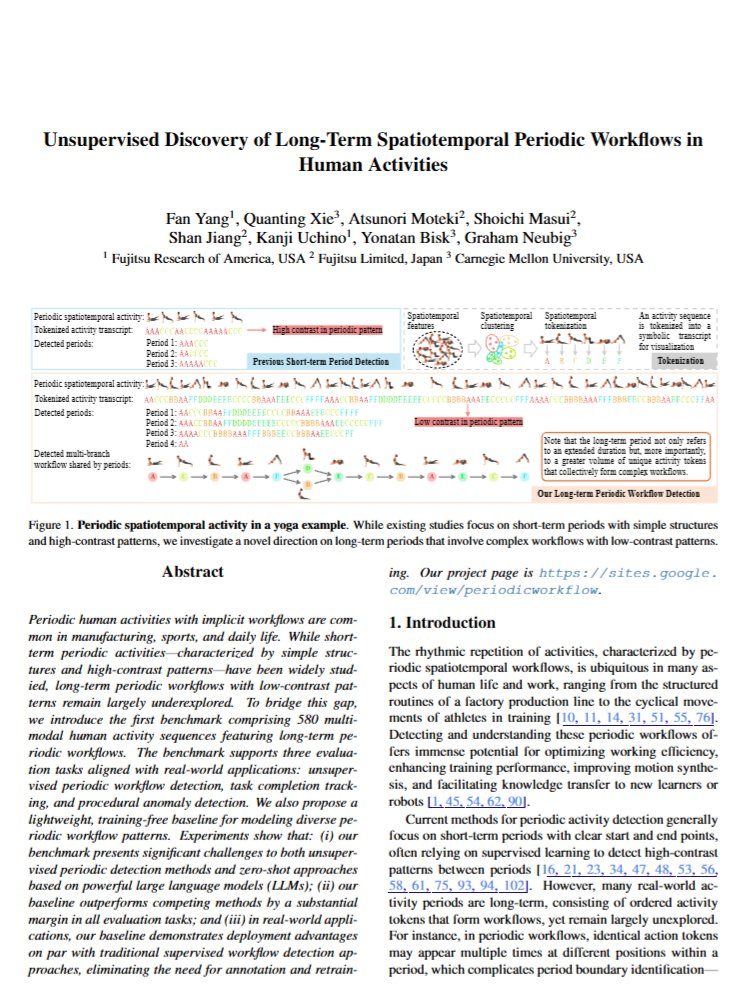

工場の長い作業手順を動画から読み取り進み具合と異常を見守る仕組み

工場での組み立て作業のような「何十もの細かい手順が組み合わさった複雑なプロセス」の繰り返しパターンをビデオ映像から自動的に見つけ出す手法を開発したとのことです。

富士通とカーネギーメロン大学の研究者らによる報告。

どこで異常が起きているか、あとどれくらいで作業が終わるかまで予測 するそうです。

採用されたのは、いわゆる教師なし機械学習アプローチです。今の最先端のLLMでも苦手なタスクのため、新しく開発する必要がありました。

これを本物の工場で生産ラインに導入したところ、実際に作業パターンを正確に把握できたそうです。

こうしたテクノロジーは技術継承や自動化などに役立つと非常に期待されています。

参考文献

Unsupervised Discovery of Long-Term Spatiotemporal Periodic Workflows in Human Activities

https://arxiv.org/abs/2511.14945

Fan Yang, Quanting Xie, Atsunori Moteki, Shoichi Masui, Shan Jiang, Kanji Uchino, Yonatan Bisk, Graham Neubig

Fujitsu Research of America, Fujitsu Limited, Carnegie Mellon University

関連記事

複雑な税ルールの食い違いをAIと論理であぶり出す手順

LLMで税法の矛盾を見つけ出す際の有効なアプローチを見出したことが報告されています。

まずはLLMで法律の文章内容を「Prolog」という論理プログラミング言語のコードに変換する作業を行い、その後Prologコードを実行するという流れです。

注目すべきことに、このアプローチの有効性を検証したところ、実験対象となった辻褄が合わない箇所を確実に見つけ出すことができたようです。

(米国の税法で明確に定められていない、解釈次第で納税額が変化するケースを検出できた)

ただしLLMでPrologコードを生成する際に完璧なスクリプトを目指すには何度かやり直しをする必要があるそうです。

なお、こうした方法は税法だけでなくさまざまなケースに応用できる可能性があります。

複雑なルールを作る際には、こうしたテクニックで矛盾をつぶす作業を行うのも一つの選択肢になるかもしれません。

参考文献

LLM-Assisted Formalization Enables Deterministic Detection of Statutory Inconsistency in the Internal Revenue Code

https://arxiv.org/abs/2511.11954

Borchuluun Yadamsuren, Steven Keith Platt, Miguel Diaz

Laboratory for Applied Artificial Intelligence(Loyola University Chicago)

まとめ

今週印象的だったのは、モデルの大きさよりも設計と運用の工夫が成果を大きく左右しそうだという点です。思考手順の可視化、検証しやすい出力、人の判断原理の取り込みが、精度と再利用性をじわじわと押し上げています。効率の向上が実装のハードルを下げ、身近なデバイスでの活用にも現実味が出てきました。

来週も、設計で差がつくポイントと進化の足跡を一緒に追っていきましょう。