本企画では、AIDBのXで紹介されたいくつかの最新AI研究を、ダイジェスト形式でお届けします。

普段の有料会員向け記事では、技術的な切り口から研究を詳しく紹介していますが、この企画では科学的な知識として楽しめるよう、テーマの概要をわかりやすくお伝えします。

今週は、「人間のふるまいをどう理解し、再現するか」に焦点を当てた注目の研究を5本まとめました。

日常行動を自然な文章で記録するライフログ技術、AIに備わっていた人間的な“時間感覚”、人より人らしく見えるロボットの錯覚、他者の立場を体験できる多視点シミュレーション、そして視線から学習のつまずきを読み解く認知分析まで、AIが人を理解しようとする姿にさまざまな角度から光を当てています。

研究に対する反応が気になる方は、ぜひAIDBのXアカウント (@ai_database)で紹介ポストもご覧ください。中には多くの引用やコメントが寄せられた話題もあります。

また、一部はPosfieにも掲載されており、読者のリアクションをまとめたページもあわせて公開しています。

日常を“読む”AI 日記生成で記憶と健康を支えるセンサ×LLM技術

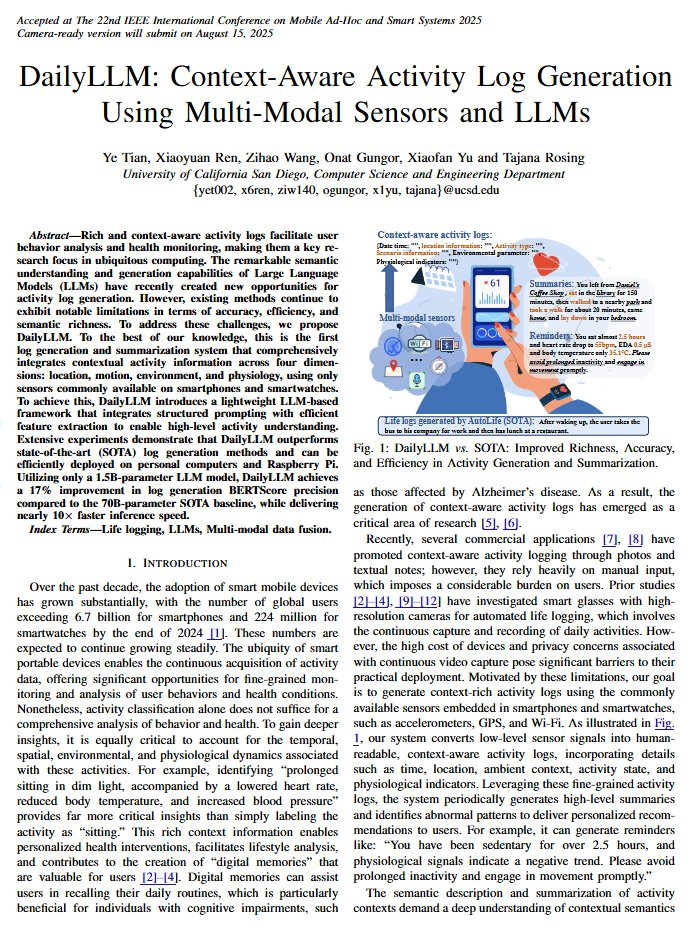

スマートフォンやスマートウォッチの一般的なセンサーを使って、人間の日常活動を自動的に記録し、わかりやすい日記のような形にまとめるシステムを開発したと報告されています。

カリフォルニア大学の研究者らによる発表。

例えば、「薄暗い図書館で2時間半座っていたため、心拍数が低下している」

といった具体的で健康に役立つ情報を生成できます。

単に「座っている」という記録よりもはるかに価値があり、記憶のサポートや健康の管理に活用できる可能性があります。

なお、手のひらサイズの小型コンピュータ(Raspberry Pi)でも動作し、2時間分の活動データをたった4分で要約できるそうです。プライバシーを守りながら、個人のデバイス上で処理できることを意味します。

必要なのはGPSやWi-Fi、加速度センサー、マイク、心拍センサーなどの組み合わせで、これらは最近のモバイル端末やウェアラブル端末には搭載されていることが多いです。

参考文献

DailyLLM: Context-Aware Activity Log Generation Using Multi-Modal Sensors and LLMs

https://arxiv.org/abs/2507.13737

Ye Tian, Xiaoyuan Ren, Zihao Wang, Onat Gungor, Xiaofan Yu, Tajana Rosing

University of California San Diego

関連記事

AIの中の“時間感覚” 教えなくても身についた人間らしい認知のしくみ

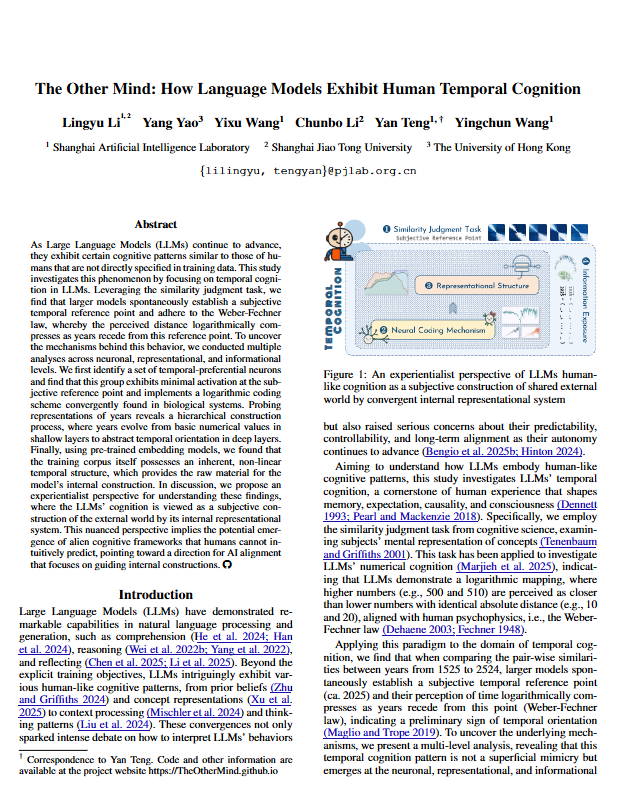

「LLMの内部を詳しく調べたところ、人間の脳と同じように”時間を処理する専用のニューロン”があった」と報告されています。

また、それは人間の脳と同じ法則に従って働いていました。

物事の大小を「どれだけ増えたか」という絶対量ではなく「何倍になったか」という比率の変化で感じやすいという、ウェバー・フェヒナーの法則でした。

誰も教えていないのに、AIが自然に身につけていたそうです。

実際に、研究者たちがAIに「西暦〇〇年と〇〇年はどれくらい似ているか」といった質問を大量にしたところ、たとえば”現在から離れるほど時間の区別が曖昧になる”といった、人間と類似したパターンを示したとのことです。

このような発見は、AIの思考は開発時に予測しづらいことを示唆しています。

今回は人間の認知と類似した現象が観察されましたが、今後、似つかない様相を呈する可能性もあります。

参考文献

The Other Mind: How Language Models Exhibit Human Temporal Cognition

https://arxiv.org/abs/2507.15851

Lingyu Li, Yang Yao, Yixu Wang, Chubo Li, Yan Teng, Yingchun Wang

Shanghai Artificial Intelligence Laboratory, Shanghai Jiao Tong University, The University of Hong Kong

関連記事

人間より“人間らしい”ロボット? AIと人の境界を揺るがす錯覚の実験

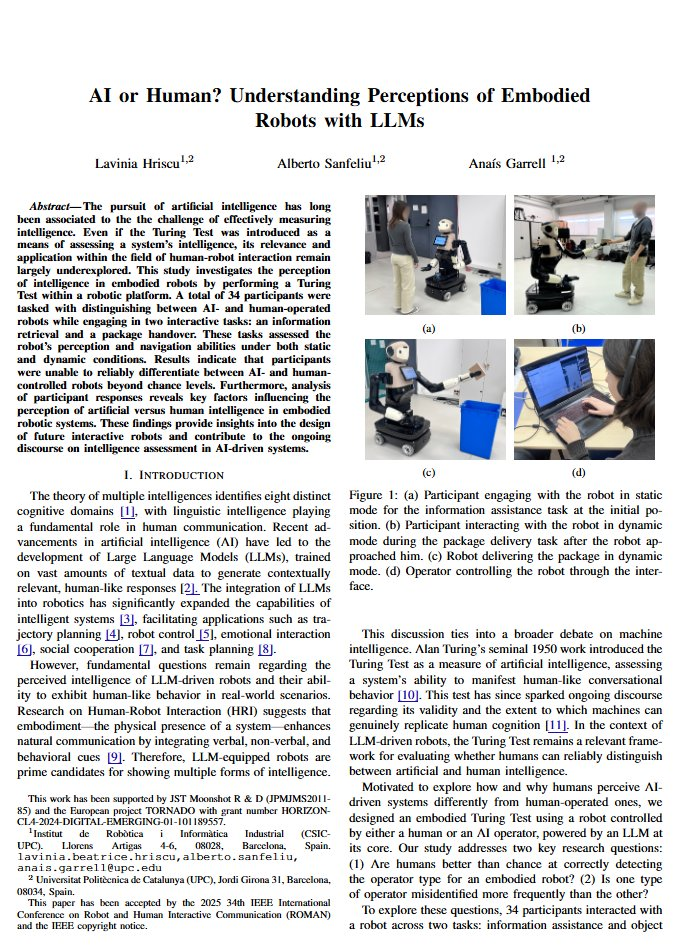

ロボットの中身を人間にするパターンとAIにするパターンの両方を用意し、人々に「これの中身は人間かAIか」を判別させる実験を行ったところ、ほとんどの人が分からなかったそうです。

それどころか、人間が操作していたロボットの方が、「これはAIだ」と誤解されることが多い結果となってしまいました。

なぜこんなことが起きたのでしょうか。

人間は意外ときっちり操作するため、かえって機械的で不自然に映るようです。

一方、AIの方は人間らしく振る舞うように設定されているため、自然に感じられたのです。

なお、多くの人が単純に「応答が遅いからAIだ」と判断しました。実際にはそれほど大きな差はないのに、人々の感じ方には大きな違いがあったのです。

私たちが「AIらしさ」「人間らしさ」について持っている思い込みが、簡単に誤解につながることを示唆する結果です。

これまでの固定観念から、丁寧で形式的な対応をAIだと思い込みがちですが、それは通用しないようになってきました。

将来、人間とAIがどちらも似たようなロボットの体を使って仕事をすることがあれば、こうした現象が何を招くのか想定しておく必要があるかもしれません。

参考文献

AI or Human? Understanding Perceptions of Embodied Robots with LLMs

https://arxiv.org/abs/2507.16398

Lavinia Hriscu, Alberto Sanfeliu, Anais Garrell

Institut de Robòtica i Informàtica Industrial, Universitat Politècnica de Catalunya

関連記事

AIで“他人の視点”を体験する 社会課題に挑むシミュレーションシステムの試み

AIを使って「他人の立場に立って考える」シミュレーションシステムを作ったとの報告です。

様々な立場の人になりきり、異なる視点から共通の問題を体験できるそうです。

システムの実験をしたところ、たとえば「合理的な提案をしても、他の利害関係者からの反対や配慮により、思うように政策が実現されない」といった現実的な体験ができることがわかりました。

なぜ良いアイデアが実現されないのか、どうすれば効果的に他者を説得できるのかといった、重要な洞察を得られるとのことです。

そして、一つの視点だけでは見えない全体像が、複数の立場を体験することで見えてきます。

こうしたシミュレーションの価値は、複雑な社会問題に対する理解を深められることだと期待されています。

参考文献

Simulating multiple human perspectives in socio-ecological systems using large language models

https://arxiv.org/abs/2507.17680

Yongchao Zeng, Calum Brown, Ioannis Kyriakou, Ronja Hotz, Mark Rounsevell

Karlsruhe Institute of Technology, Highlands Rewilding Limited, Bayes Business School, City St George’s University of London, University of Edinburgh

関連記事

視線が語る“つまずき” LLMとアイトラッキングが学習理解を読み解く

人の目の動きを記録する「アイトラッキング」とLLMを組み合わせることで、学習者の認知状態や行動パターンを分析することができたと報告されています。

研究者らは、専門家の判断とAIの分析を組み合わせることで、学習者がどこでつまずいているか、どのような認知的困難を抱えているかを「視線から」

自動的に検出できるシステムを作りました。

実験では、プログラミング学習の目の動きを分析し、学生と専門家の行動パターンの違いを分析した結果、問題の難易度を最大50%の精度で予測できたそうです。

また、個々の学生の学習上の問題点を特定することができたとのことです。

さらに興味深いことに、学習者の異常な視線パターンから、問題自体に欠陥があるケースまで発見できました。

こうした技術は個別指導システムや、医療、インターフェース設計など幅広い分野での応用が期待されます。

人間の認知プロセスに基づいたシステムを構築する道を開いていると言えます。

これまではアイトラッキングデータは数値の羅列であり、そこから意味のある情報を読み取るには専門知識が必要でしたが、LLMと組み合わせることで活用のハードルが下がり幅が広がった格好です。

参考文献

Multimodal Behavioral Patterns Analysis with Eye-Tracking and LLM-Based Reasoning

https://arxiv.org/abs/2507.18252

Dongyang Guo, Yasmeen Abdrabou, Enkeleda Thaqi, Enkelejda Kasneci

Technical University of Munich

関連記事

まとめ

AIがふるまいを“演じる”ことで、どこまで人のように考え、行動し、すれ違いを乗り越えられるのか。

今回の研究たちは、その内面の仕組みと人との関係性に光を当てるものでした。

週末ダイジェストでは、こうしたAIと人間のあいだに生まれる問いや発見を、わかりやすくお届けしています。

来週もまた、進化を続けるAIの今と、その裏側を一緒に見つめていきましょう。