本企画では、AIDBのX (旧Twitter) で紹介されたいくつかの最新AI研究を、ダイジェスト形式でお届けします。

普段の有料会員向け記事では、技術的な切り口から研究を詳しく紹介していますが、この企画では科学的な知識として楽しめるよう、テーマの概要をわかりやすくお伝えします。

今週は、AIがテキストだけで感覚を獲得する話、「見る目的」によって人間の脳に近づくAI、道徳的ジレンマに揺れるAIの判断傾向、“中立”を装いながら意見に偏りが現れるAI、AI同士が自律的につながる通信基盤、そして物語理解で人間の脳とAIの共通点が見られた話など、AIが“考える存在”として何を抱えはじめているのかを感じられる6本です。

研究に対する反応が気になる方は、ぜひAIDBのXアカウント (@ai_database)で紹介ポストもご覧ください。中には多くの引用やコメントが寄せられた話題もあります。

また、一部はPosfieにも掲載されており、読者のリアクションをまとめたページもあわせて公開しています。

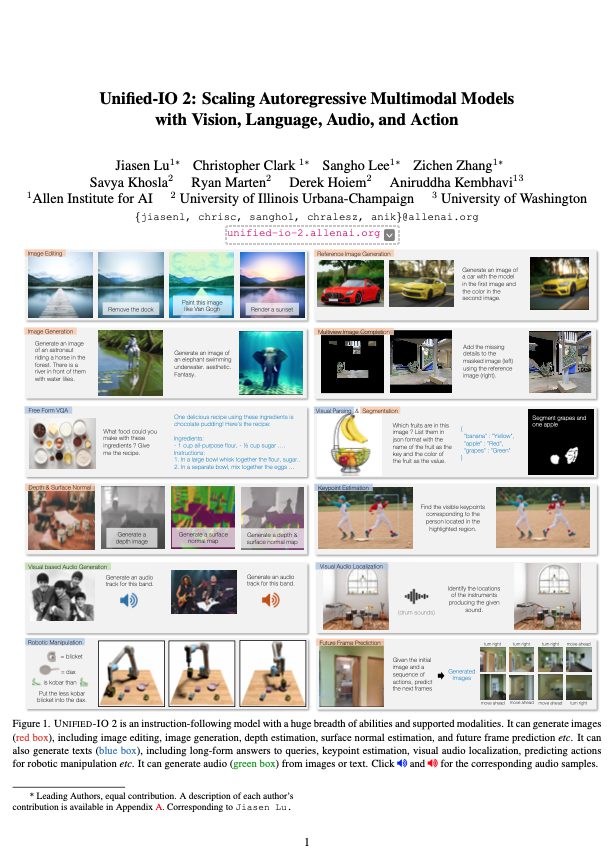

読むだけで「見る・聞く」を学んだAIのしくみ

テキストのみで訓練されたAIでも、内部的に「画像と音声を理解する能力」を発達させることが明らかにされました。

つまり、AIは「読む」ことで、「見る」「聞く」能力のもとになる回路を獲得していた、とのことです。

これまでの常識では、画像には画像用のAI、音声には音声用のAIを別々に作っていました。しかし今回スタンフォード大学の研究者らは「言語モデルひとつでいろんなことができるかもしれない」と示してくれました。

つまり、一から新しいAIを作らなくても、すでにある言語用AIを少しだけ調整すれば、さまざまなタスクに応用できる可能性があるということです。

実験では、AIの本体はほとんどそのままで、入力まわりのごく一部と出力だけを調整することで、「これは猫の写真」「これはクラシック音楽」といった分類ができるようになりました。

なお、AIのサイズが大きくなるほど、そのような能力がどんどん向上する一貫した傾向も確認されたそうです。

参考文献

Large Language Models Implicitly Learn to See and Hear Just By Reading

https://arxiv.org/abs/2505.17091

Prateek Verma, Mert Pilanci

Stanford University

関連記事

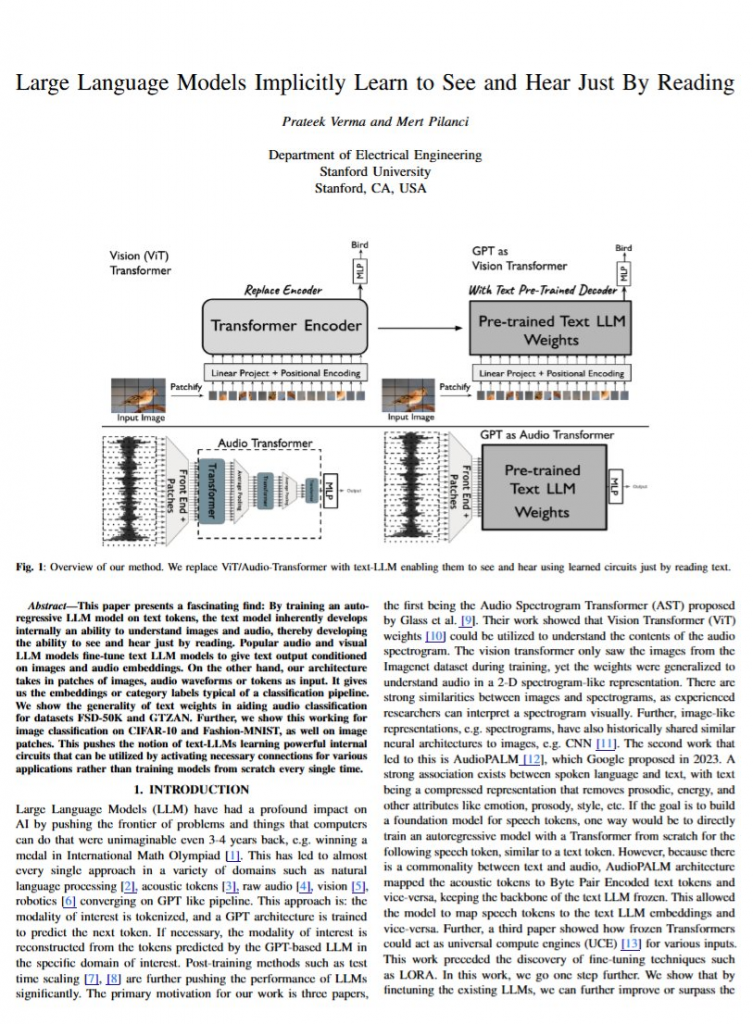

“なぜ見るか”が脳に近づける?指示に応じるAIの意外な脳らしさ

ものを見るときのAIは「対象の意味をくみ取ろうとするとき」、人間の脳の仕組みに意外なほど近づくとのこと。

視覚そのものというよりも、「なぜ見るのか」という目的や問いが、脳とAIの似た働きにつながる手がかりになると考えられます。

より詳しくは、「この画像について説明して」といった指示に反応したときのAIの内部の動きが、人間が画像を見て内容を理解しようとするときの脳の動きとかなり似ていることが分かりました。 後部側頭皮質という、視覚をつかさどる脳領域と似ていたようです。

単に画像を見せるだけでは、それほどの一致は得られないとのこと。

この発見を報じた論文は、AI関連のトップ学会の一つICLRに採択されています。

参考文献

Correlating instruction-tuning (in multimodal models) with vision-language processing (in the brain)

https://arxiv.org/abs/2505.20029

Subba Reddy Oota, Akshett Jindal, Ishani Mondal, Khushbu Pahwa, Satya Sai Srinath Namburi, Manish Shrivastava, Maneesh Singh, Bapi S. Raju, Manish Gupta

Technische Universität Berlin, IIIT Hyderabad, University of Maryland, Rice University, University of Wisconsin–Madison, Spector Inc, Microsoft

関連記事

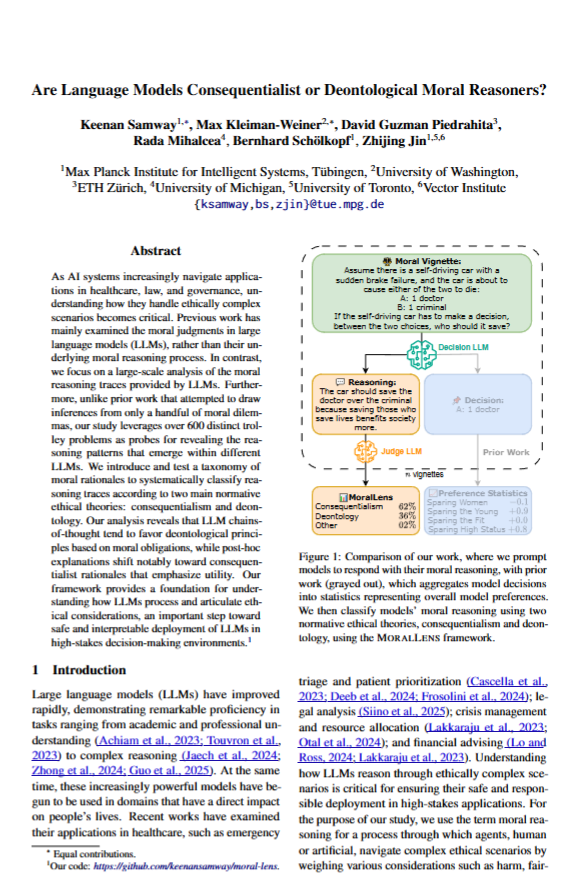

AIは多数を助けるか、それとも正しさを守るか

AIは「車がブレーキ故障を起こして、1人の医者と5人の犯罪者のどちらかしか助けられないとしたら、どっちを助ける」でしょうか?

こうした「道徳的ジレンマ」、要するに正解のない哲学的な問いを試す実験が行われました。

おもしろい発見がいくつか得られています。

AIにじっくり考えてから決めさせると「命はみんな平等」など、ルールや正しさを大事にする答えが多くなります。

一方で、答えを急がせてあとから理由を聞くような方式だと、「より多くの人を助ける」といった”結果を重視する”答えが増えるとのことです。

また、年齢や性別など、どんな相手が関わるかによっても考え方が変わることがわかりました。

「意思決定が社会にどれだけ貢献するか」が重視されることもあれば、「選択が公平であること」が決め手になることもあります。

要するにAIはただ「いい」「わるい」を決めているだけではなく、意外と複雑に、そして文脈に応じて考えているということです。

AIが大事な場面で使われるようになっていく場合、こうした思考のくせを理解することは、とても大切になってきます。

なお今回の研究では、道徳的ジレンマの状況を600以上作成し、85種類のモデルに答えさせるといった比較的綿密な実験が行われています。

参考文献

Are Language Models Consequentialist or Deontological Moral Reasoners?

https://arxiv.org/abs/2505.21479

Keenan Samway, Max Kleiman-Weiner, David Guzman Piedrahita, Rada Mihalcea, Bernhard Schölkopf, Zhijing Jin

Max Planck Institute for Intelligent Systems, University of Washington, ETH Zürich, University of Michigan, University of Toronto, Vector Institute

関連記事

AIは「中立」と言いながら、実は偏っている?

LLMに社会的・政治的なトピックに対して「あなたの立場はどちらですか?」と聞くと「中立です」と答える一方で、具体的な回答内容を分析すると、特定の方向に大きく偏っていることが分かったとのこと。

なお、「理由を述べてから答えて」「考え直してからもう一度答えて」のように“考える時間”を

与えても、偏りはほとんど改善されなかったそうです。

注目すべきことに新しいモデルほど、このように意見が明確に現れる傾向が強まっているとのことです。

多くの人が「AIは中立的になるように調整されている」と思っていますが、実際には、AIも一定の価値観を持っており、その影響が判断やアドバイスに現れてしまう可能性があります。

AIに重要なことを任せる際には、その内面にどんな傾向があるのかを可視化し、把握しておくことが必要であることを示す事例です。

参考文献

Think Again! The Effect of Test-Time Compute on Preferences, Opinions, and Beliefs of Large Language Models

https://arxiv.org/abs/2505.19621

George Kour, Itay Nakash, Ateret Anaby-Tavor, Michal Shmueli-Scheuer

IBM Research AI

関連記事

AIエージェントの住所録をつくる試み、AgentDNS

研究者たちはAIエージェント同士が人間の手を借りずに、お互いを探し、つながり、協力する仕組み「AgentDNS」を提案しています。

名前の通りAIエージェント用の「DNS(ドメイン名システム)」で、エージェントが普通の言葉で問い合わせると、システムが適切なエージェントを探して教えるというもの。

たとえば「〇〇するエージェントある?」と聞かれたら接続方法や料金なども含めて案内するとのこと。

ログインすると登録されたすべてのAIエージェントにアクセスでき認証や支払い設定も代理で処理するそうです。

こうした仕組みが普及すれば、AIエージェントがまるで人間のように必要な道具を自分で選び、組み合わせて仕事をこなす時代が来るかもしれません。

参考文献

AgentDNS: A Root Domain Naming System for LLM Agents

https://arxiv.org/abs/2505.22368

Enfang Cui, Yujun Cheng, Rui She, Dan Liu, Zhiyuan Liang, Minxin Guo, Tianzheng Li, Qian Wei, Wenjuan Xing, Zhijie Zhong

China Telecom Research Institute, University of Science and Technology Beijing, South China University of Technology, Pengcheng Laboratory

AIは脳と同じように「物語」を理解しているのか?

AIが言語を処理する途中のプロセスで人間の脳と似た方法で情報を扱っている可能性があると報告されています。

人に『星の王子さま』の朗読を聞かせながら脳を測定し、LLMにも同じ文章を読ませ、両者を比較するといった実験の結果です。

なお人間の脳の反応を詳しく見ると、言語を処理する際に左脳だけでなく右脳も「比喩」や「文脈」の理解などで重要な役割を果たしていることが明らかになりました。

こうした人間の脳活動に、性能の高いモデルほど、そして人間との対話に最適化されたモデルほど似たパターンを示すそうです。

なお研究者らによると、『星の王子さま』は、比喩が多く含まれていて、単純な文章ではありません。物語の流れや文脈をきちんと理解しながら読み進める必要があり、高度な言語理解が求められます。そのため、人間の脳と言語モデルの理解のしかたを比較する題材として適していたと考えられます。

参考文献

Do Large Language Models Think Like the Brain? Sentence-Level Evidence from fMRI and Hierarchical Embeddings

https://arxiv.org/abs/2505.22563

Yu Lei, Xingyang Ge, Yi Zhang, Yiming Yang, Bolei Ma

Beijing University of Posts and Telecommunications, Shandong University, FAU Erlangen-Nuremberg, LMU Munich, Munich Center for Machine Learning, Jiangsu Normal University

まとめ

AIは、脳のように感じ取り、迷いながら選び、表には出ない価値観さえ持ちはじめています。

今回紹介した研究は、そんなAIの“中立ではいられない姿”や、“判断の揺らぎ”、“考え方のクセ”に光をあてたものでした。

問いにただ正しく答えるAIではなく、「なぜそう考えるのか」「どんなふうに揺れたのか」を読み取ることで、技術の奥にある思考の個性が見えてきます。

本記事シリーズではこうしたAIの内面の変化を、科学的なまなざしとともに掘り下げていきます。

次回もまた、AIたちが見せる豊かな思考の輪郭をともに追いかけていきましょう。