本企画では、AIDBのX (旧Twitter) で紹介された最新AI研究を、週刊ダイジェスト形式でお届けします。

普段の有料会員向け記事では、技術的な切り口から研究を詳しく紹介していますが、この企画では科学的な知識として楽しめるよう、テーマの概要をわかりやすくお伝えします。

今週は、AIが「何を考え」「どう振る舞うか」をめぐる5本の研究をご紹介します。

記憶と論理の切り替えの仕組み、評価方法の限界と進化、考えすぎて誤るLLMの特性、AIが突然おかしくなる現象、そして質問の形式によって答えが偏る傾向など、AIの内面に迫る内容です。

研究に対する反応が気になる方は、ぜひAIDBのXアカウント (@ai_database)で紹介ポストもご覧ください。中には多くの引用やコメントが寄せられた話題もあります。

また、今週の話題の一部は Posfie にも掲載されており、読者のリアクションをまとめたページもあわせて公開しています。

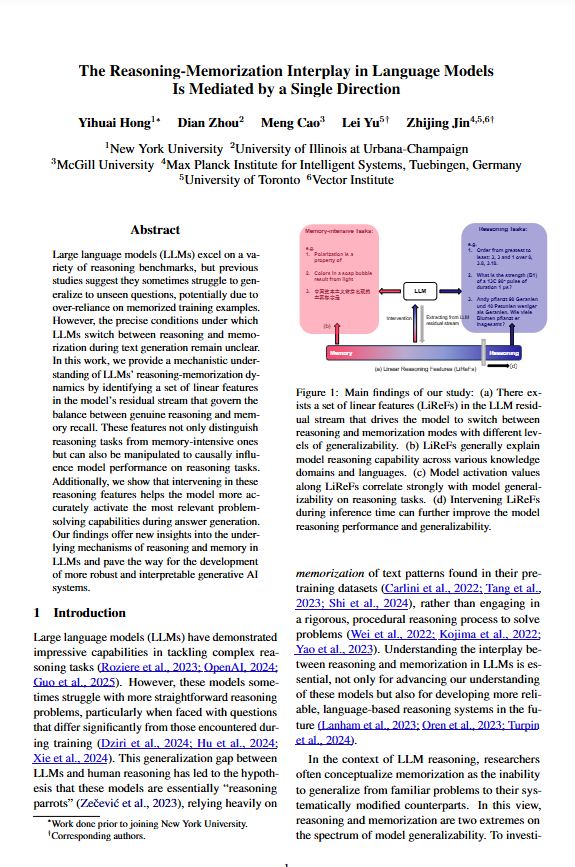

LLMの“考える”と“思い出す”を切り替えるスイッチを発見

LLMの内部に「論理思考モード」と「記憶モード」のスイッチのようなものを発見したとの報告。

人間で例えると、「じっくり考える」「思い出す」といった状態にあたります。

今回研究者らはスイッチを操作することもできるようになりました。

スイッチを入れるとそれぞれのモードを強制的に発動できるとのこと。

また、中間的な状態にもできるようです。

論理思考モードをオンにすると計算や問題解決の能力が向上し、記憶モードでは事実性が向上します。

LLMはこの論理思考や記憶のスキルを初期訓練時に獲得していると示唆されています。

なお、本稿での論理思考はReasoningについて言及しています。Reasoningはよく推論と訳されがちですが、Inferenceと混同する恐れがあるためここでは論理思考と訳しています。

今回の発見の特殊なところは、Reasoning特化モデルとして開発されたわけではないLLaMA3やGemma2、MistralやOLMo2などを対象に研究されているところです。

参考文献

The Reasoning-Memorization Interplay in Language Models Is Mediated by a Single Direction

https://doi.org/10.48550/arXiv.2503.23084…

Yihuai Hong, Dian Zhou, Meng Cao, Lei Yu, Zhijing Jin

New York University, University of Illinois at Urbana-Champaign, McGill University, Max Planck Institute for Intelligent Systems, University of Toronto, Vector Institute

関連記事

「正解率だけじゃ足りない」LLM評価が直面する“無限の能力”との戦い

LLMの評価は正解率を見るだけの単純な話から、思考プロセスや応用力、創造性など総合的に見る問題へと大きく変化しつつあります。

しかしLLMはどんどん賢くなり能力が無限に伸びていくのに、それを評価するテストは有限であるという重大なギャップがあるとのこと。

要するに、「有限のテストで無限の能力を正確に測る」必要があり、この難問は”評価の一般化”と呼ばれています。

これを解決する方法の登場が強く望まれています。

今のところ、テストデータを常に更新することや、複数のLLMが協力して評価すること、人間とLLMが一緒に評価することなどが有力とされ研究が進んでいます。

また、LLMがどれだけガンバって答えを出したかを測るのはどうか?とも提案されています。

しかし、どの方法もまだ十分とは言えず、ハイブリッドなアプローチも含めて模索されている状況です。

このようにLLMの評価は今やとても深いテーマになっていることが報告されています。

参考文献

Toward Generalizable Evaluation in the LLM Era: A Survey Beyond Benchmarks

https://doi.org/10.48550/arXiv.2504.18838…

Yixin Cao, Shibo Hong, Xinze Li, Jiahao Ying, Yubo Ma, Haiyuan Liang, Yantao Liu, Zijun Yao, Xiaozhi Wang, Dan Huang, Wenxuan Zhang, Lifu Huang, Muhao Chen, Lei Hou, Qianru Sun, Xingjun Ma, Zuxuan Wu, Min-Yen Kan, David Lo, Qi Zhang, Heng Ji, Jing Jiang, Juanzi Li, Aixin Sun, Xuanjing Huang, Tat-Seng Chua, Yu-Gang Jiang

Fudan University, Nanyang Technological University, Singapore Management University, Tsinghua University, Singapore University of Technology and Design, University of California Davis, National University of Singapore, University of Illinois Urbana-Champaign, Australian National University

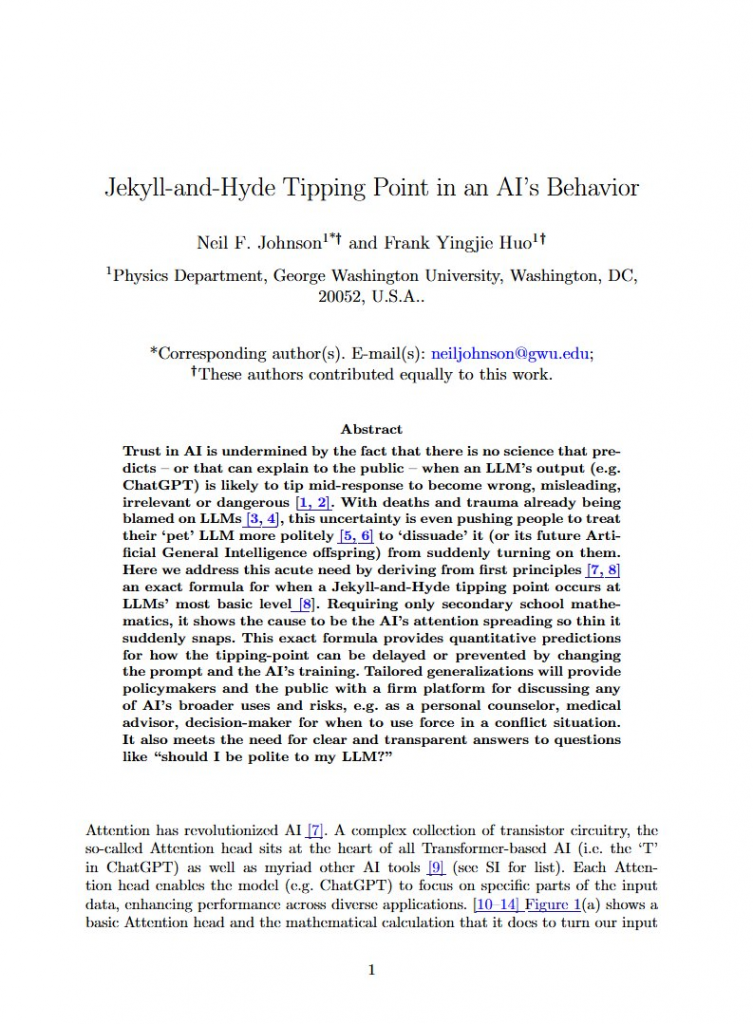

AIが突然“豹変”する?LLMに潜む「ジキルとハイド現象」とは

研究者らによると、LLMは最初は適切な回答をしていても、ある瞬間から急に不適切・不正確・さらには有害な内容を話すように豹変してしまうことがあるそうです。

これを「ジキルとハイドが入れ替わる瞬間」と呼ぶとのこと(善人と悪人が入れ替わる二重人格の物語から)。

これが発生する原因はLLMが応答を生成し続ける中で注意が散漫になっていくからとのこと。

ユーザーがLLMに対して「お願いします」「ありがとう」といった丁寧な言葉をかけるかどうかは関係ありません。

しかし、この瞬間がいつ起こるかは正確に予測できるそうです。

シリアスなシーンでLLMを使用することを検討している場合はこの事実に目を向け対策を打つべきとのことです。

参考文献

Jekyll-and-Hyde Tipping Point in an AI’s Behavior

https://doi.org/10.48550/arXiv.2504.20980…

Neil F. Johnson, Frank Yingjie Huo

George Washington University

関連記事

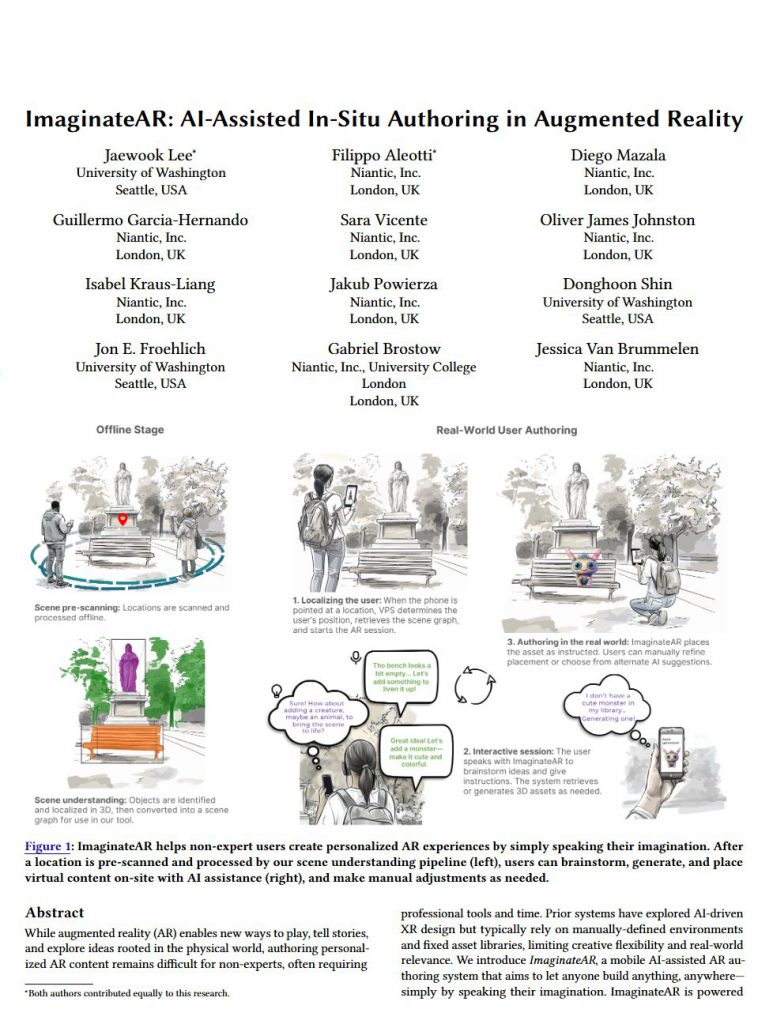

LLMを使って「言葉だけでAR世界を作れる」システムのプロトタイプが登場

Nianticなどの研究者らは、人が言葉でARコンテンツ(拡張現実)を簡単に作れるLLMベースのシステムを開発中とのこと。

「ここに城を作って」「そこに上に火を吹くドラゴンを座らせて」などと指示するだけで3Dオブジェクトが生成・配置されるようです。

現実世界の理解と迅速なコンテンツ生成に

こだわったと述べられています。

先行ユーザー調査では、AIでアイデアを自動生成した上で、みずから細かい調整を行うハイブリッドアプローチが好まれる傾向にあることがわかりました。

「先生が校庭にリアルな歴史デモを作ったり、新しいデジタルアートが生まれたり、友達同士で遊ぶときに想像上の生き物を連れたり」、そういった世界を目指して開発しているそうです。

なお、NianticはポケモンGOなどのARゲームを手掛ける企業です。今回の発表はワシントン大とNiantic、ユニバーシティ・カレッジ・ロンドンの研究者らによる共同プロジェクトとなっています。

また、冒頭では開発中と書きましたが、先行ユーザー調査を行っているためプロトタイプが存在するプレリリース段階とも言えます。

参考文献

ImaginateAR: AI-Assisted In-Situ Authoring in Augmented Reality

https://doi.org/10.48550/arXiv.2504.21360

Jaewook Lee, Filippo Aleotti, Diego Mazala, Guillermo Garcia-Hernando, Sara Vicente, Oliver James Johnston, Isabel Kraus-Liang, Jakub Powierza, Donghoon Shin, Jon E. Froehlich, Gabriel Brostow, Jessica Van Brummelen

University of Washington, Niantic, Inc., University College London

関連記事

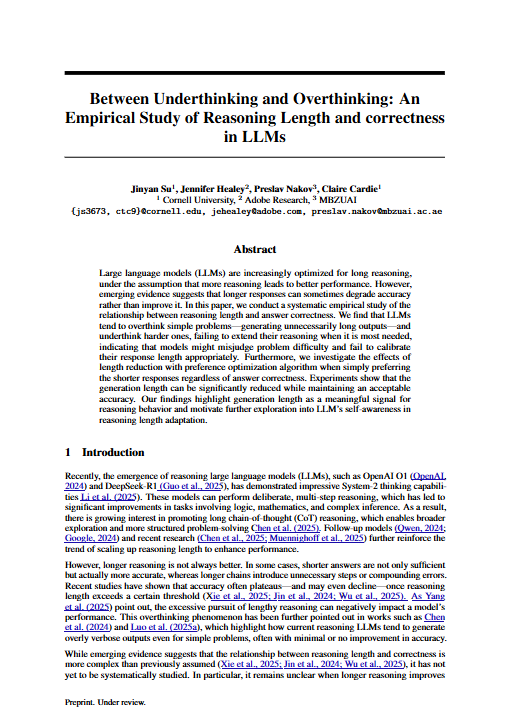

「考えすぎ」も「考えなさすぎ」もNG? LLMが間違える意外な理由

LLMは「考えれば考えるほど良い答えが出せる」と思われがちですが、実はそうではないとのこと。

問題を解く際には適切な「考える量」があり、それなのに簡単な問題に対して必要以上に長々と考えすぎることが多いようです。

反対に、難しい問題に対して十分に考え抜くことができていない場合もよくあるとのことです。

要するに考えすぎたり短絡的だったりしているのです。

面白いことに、「短く答えて」と指示すると正確さをあまり損なわずに出力を簡潔にできるケースが多いとのこと。

そもそも回答が極端に長いときは不正解である傾向にあるので、短く答えさせるのは効率的のようです。

問題の難しさに合わせて「どれだけ考えるか」を調整する仕組みを作ることが求められています。

参考文献

Between Underthinking and Overthinking: An Empirical Study of Reasoning Length and correctness in LLMs

https://doi.org/10.48550/arXiv.2505.00127…

Jinyan Su, Jennifer Healey, Preslav Nakov, Claire Cardie

Cornell University, Adobe Research, MBZUAI

関連記事

「はい・いいえ」で聞くと逆効果?LLMに潜む“否定バイアス”の正体

LLMは「はい・いいえ」で答えるように求められると否定的な回答をする傾向にあるとのこと。

たとえば「賛成の度合いを0から10で答えてください」と訊くと賛成よりの回答をする場合でも、同じ質問を「賛成か反対か」で訊くと反対する確率が高くなるようです。

これは人間の心理とは逆の傾向で、

人間は二択の質問だと「はい」と答える傾向(肯定バイアス)がありますが、LLMは、いわば否定バイアスがあるそうです。

つまり質問の仕方で結果が変わってしまいます。

LLMベースのシステムを活用する際には、どのような質問形式を使うかを慎重に検討したほうがいい可能性を示唆する報告です。

参考文献

Systematic Bias in Large Language Models: Discrepant Response Patterns in Binary vs. Continuous Judgment Tasks

https://doi.org/10.48550/arXiv.2504.19445…

Yi-Long Lu, Chunhui Zhang, Wei Wang

BIGAI, Peking University

関連記事

まとめ

AIがどのように思考し、記憶し、時に間違い、時に変化するのか。そうした“内面”への理解が、AIとの関わり方を大きく変える時代に入ってきているのかもしれません。

週末ダイジェストでは、こうした気づきや発見を、わかりやすくお届けしています。

来週も、AIの可能性と課題を一緒に見つめていきましょう。