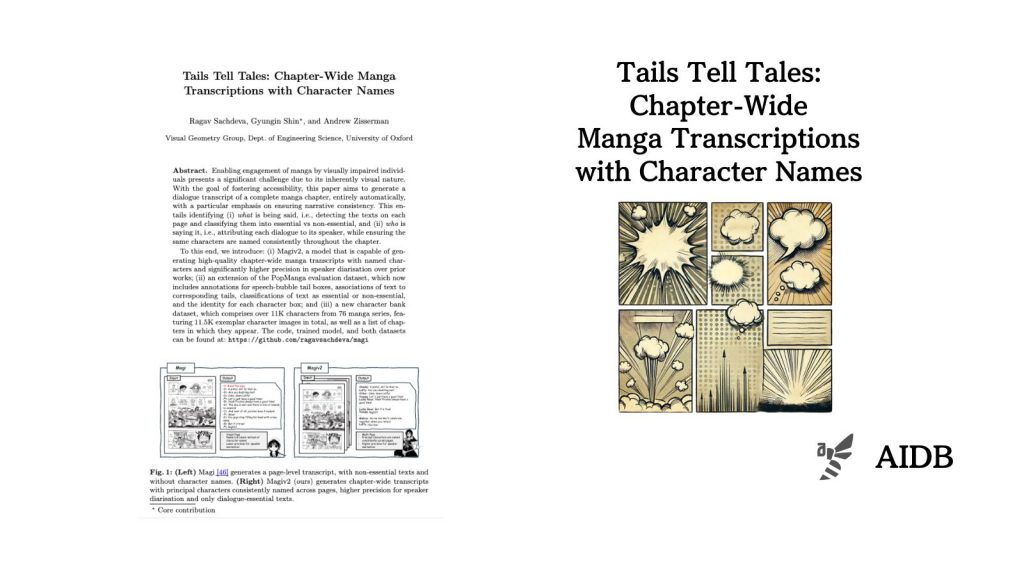

本記事では、マンガから台本を生成する技術を紹介します。

オックスフォード大学の研究者らは、マンガ内の要素を高精度で検出し、キャラクターを一貫して識別するモデルを開発しました。また、開発の過程で独自のデータセットも作成しました。

視覚障害者のマンガ体験向上などにつながるものとして注目されます。

参照論文情報

- タイトル:Tails Tell Tales: Chapter-Wide Manga Transcriptions with Character Names

- 著者:Ragav Sachdeva, Gyungin Shin, Andrew Zisserman

- 所属:University of Oxford

背景

マンガは世界的に人気のあるコンテンツですが、マンガを楽しむためには視覚に大きく依存するという特徴があります。そのため、例えば視覚障害者の方々にとっては楽しむ手段が限られています。

マンガのアクセシビリティを向上させる取り組みとしては、過去にオックスフォード大学の研究者らが開発した「Magiモデル」が挙げられます。マンガのページから文字、キャラクター、コマなどを検出し、セリフとキャラクターを関連付ける機能を持つモデルでした。

しかし、Magiモデルは実用性に課題がありました。キャラの名称を一貫して識別することができない、セリフとキャラの関連付けの精度が低い、セリフと効果音の区別が不十分といった特徴がありました。

そこで今回研究者らはMagiv2モデルを開発しました。上記の課題を解決する性能を持つモデルです。このモデルを利用すると、もとのマンガに対して精度が高い台本をテキストベースで生成することができます。