長いコンテキストのタスクに対し、短いプロンプトのみ処理できるモデルでも取り組める「LC-Boost」フレームワークが考案されました。

参照論文情報

- タイトル:Are Long-LLMs A Necessity For Long-Context Tasks?

- 著者:Hongjin Qian, Zheng Liu, Peitian Zhang, Kelong Mao, Yujia Zhou, Xu Chen, Zhicheng Dou

- 所属:Renmin University of China, Beijing Academy of Artificial Intelligence

背景

最近、長文の質問応答や要約などのタスクにLLMが活用されるようになってきました。しかし、一部のモデルは長いプロンプトを処理できるようになっていますが、既存のLLMの多くは、限られた長さのコンテキストしか処理できないという制約があります。

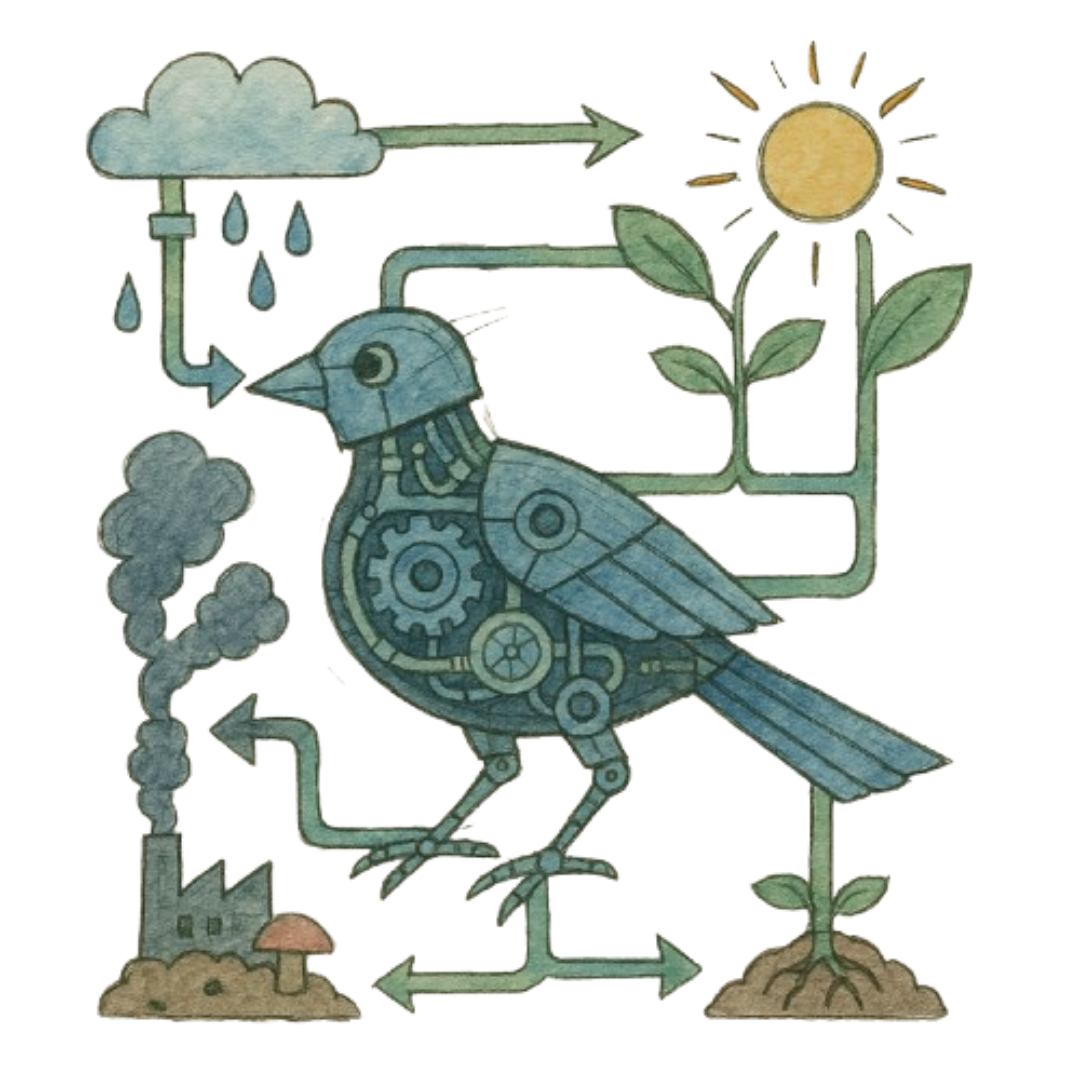

一般的に、LLMのコンテキストウィンドウを拡張すれば長いコンテキストへの対応が可能になります。しかしモデルの学習や適用に膨大なコストがかかるだけでなく、短いコンテキストに対する汎用性が損なわれる恐れもあります。そこで、長いコンテキストを短いコンテキストに分解することで、効率的に長いコンテキストのタスクを解決できないかという発想が生まれました。

こうした背景から、短いコンテキストのみ処理するLLMを用いて長いコンテキストのタスクに取り組む新たな手法LC-Boost(Long-Context Bootstrapper)が考案されました。