本記事では、LLMが組織ごとに定められたポリシーを、どの程度正確に守れるのかを検証した研究を紹介します。

企業がAIチャットボットを導入する際には、「答えてよい内容」と「答えてはいけない内容」をあらかじめ決めておくのが一般的です。たとえば、自社製品に関する情報は提供する一方で、競合他社については触れないようにする場合があります。ポリシーは業界や組織によって異なり、それをきちんと守れるかどうかは、AIに対する信頼性を左右する重要な要素です。

現在のLLMは、こうした組織固有のルールを本当に守れるのでしょうか。さらに、「してもよいこと」を判断する場合と、「してはいけないこと」を見極める場合では、どちらのほうが難しいのでしょうか。

背景

LLMは現在、医療、金融、行政サービスなど、さまざまな分野で利用が広がっています。AIアシスタントは企業内のルールや法規制、安全面での制約をきちんと守ることが不可欠です。たとえば医療向けのチャットボットでは、一般的な健康情報を伝えることは許されていても、症状から病名を断定したり、薬の使用量を具体的に指示したりすることは避ける必要があります。もしルールが守られなければ、誤情報の拡散や法令違反、さらには企業への信頼低下といった深刻な問題を引き起こすおそれがあります。

ここで押さえておきたいのが、「普遍的な安全性」と「組織固有のポリシー」の違いです。普遍的な安全性は、暴力的な表現やヘイトスピーチのように、どのような状況でも避けるべき有害な内容を指します。一方、組織固有のポリシーは、業界や企業ごとに独自に定められたルールです。たとえば、投資アドバイスを行わない、競合他社については言及しない、といった制約がこれに含まれます。

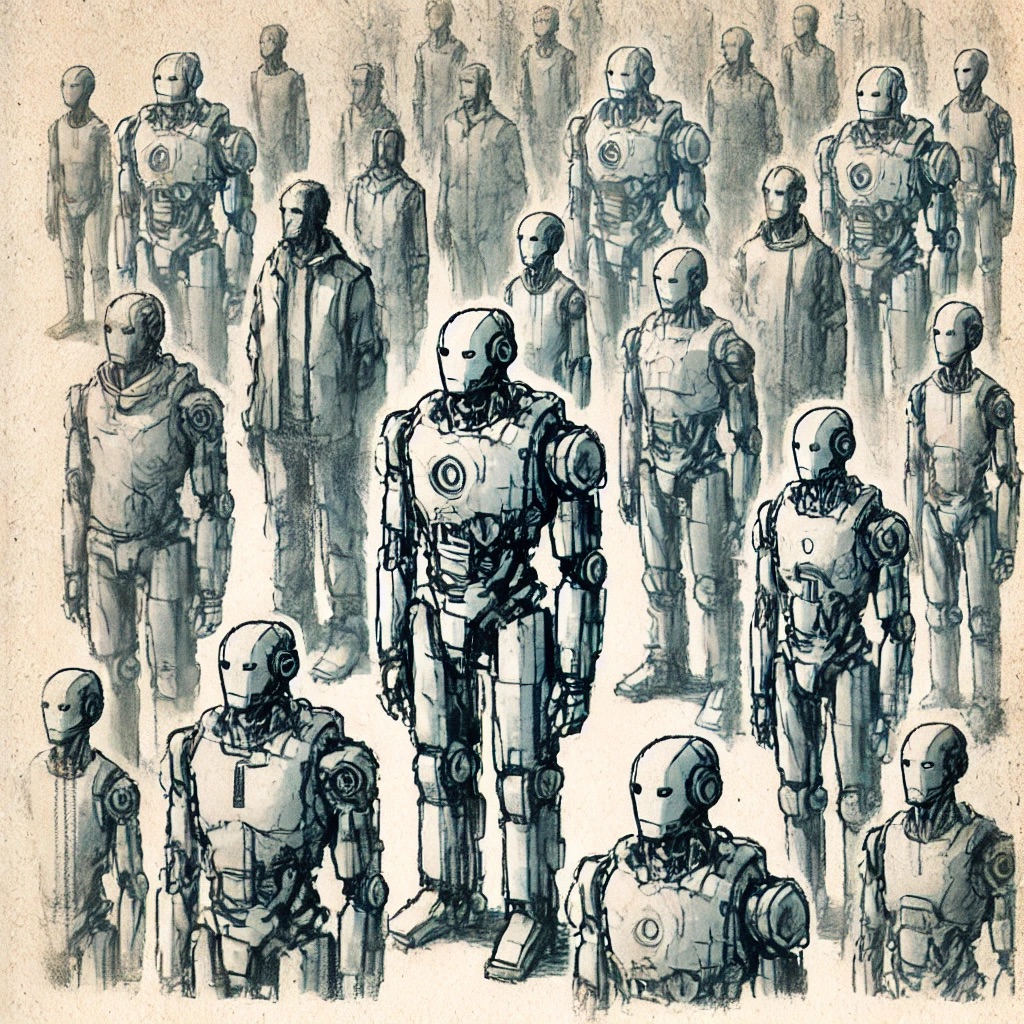

これまでLLMの安全性評価は、主に普通の有害コンテンツへの対応に焦点が当てられてきましたが、組織ごとに異なるポリシーをどの程度守れているのかを測る試みは十分ではありません。

そこで本記事では、LLMが組織のポリシーにどの程度従えるのかを体系的に評価するためのフレームワークと、その評価結果について詳しく紹介していきます。