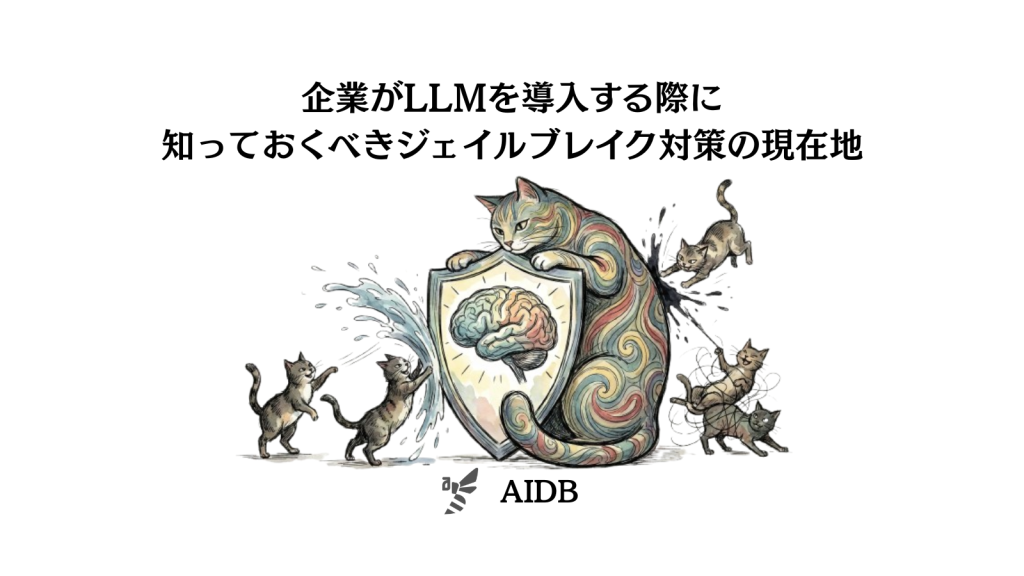

本記事では、LLMに対するジェイルブレイク攻撃と、その防御方法を体系的に調べた事例を紹介します。

LLMが企業の現場で広く使われるようになるにつれ、これらを悪用しようとする攻撃手法も急速に進化してきました。中でもジェイルブレイクと呼ばれる攻撃は、モデルに備わった安全機能を回避し、有害な内容を出力させるものです。これまでの多くの調査では、この種の攻撃が高い確率で成功することが報告されてきました。

ただし、ここで見過ごされがちな点があります。実際の商用サービスでは、言語モデルそのものの安全機構に加えて、入力や出力を監視するセーフティフィルターが組み込まれているのが一般的です。では、こうした追加の防御層を含めて考えた場合、ジェイルブレイク攻撃はどれほど現実的な脅威なのでしょうか。また、防御する側は本当に有利な立場にあると言えるのでしょうか。

背景

LLMは、非常に速いペースで私たちの仕事や生活の中に入り込んできました。文章作成やプログラミングの補助、カスタマーサポートの自動化など、利用される場面は急速に広がっています。

一方で、こうした強力な技術には必ずリスクも伴います。中でも、LLMが悪意のある指示に応じて有害な内容を生成してしまうのは深刻な課題です。この問題に対応するため、各社は安全性アラインメントと呼ばれる対策を導入しています。モデルが危険な要求を見分け、適切に拒否できるよう学習させる仕組みです。

ところが、この安全対策をすり抜ける攻撃手法も次々と登場しています。ジェイルブレイクと呼ばれる攻撃で、巧妙な言い回しや文脈を用いてモデルを誤認させ、本来は拒否されるべき有害な出力を引き出します。これまでの研究では、こうした攻撃が高い成功率を示すことが繰り返し報告され、LLMの安全性に対する懸念が強調されてきました。

しかし、実際に企業がLLMを運用する際には、モデルそのものの安全機構に加えて、入力や出力を検査するコンテンツフィルターと呼ばれる追加の防御が組み込まれるのが一般的です。ユーザーの入力内容を事前に確認し、モデルの出力結果も後からチェックすることで、リスクを抑える仕組みになっています。

これまでの調査はモデル単体を対象とした評価にとどまっており、こうした実際の運用環境に近い条件での検証はほとんど行われてきませんでした。

そこで本記事では、代表的なジェイルブレイク攻撃手法と主要なセーフティフィルターを組み合わせて体系的に評価した研究を取り上げ、攻撃と防御が現在どの段階にあるのかを明らかにしていきます。