「GPTの書いた文章」と「人間の書いた文章」、信頼されやすいのはどっち?検証の結果

大規模言語モデル(LLM)によって生成されたコンテンツをそのまま使用するのは、様々なリスクを引き起こす可能性があります。その理由の一つは、ハルシネーションによる誤情報が含まれることがあるためです。しかし、もしコンテンツが人間によるものかAIによるものかを判断できれば問題はありません。あるいは、人間なのかAI生成なのかに関わらず、信頼できる文章なのか否かが分かることが重要です。

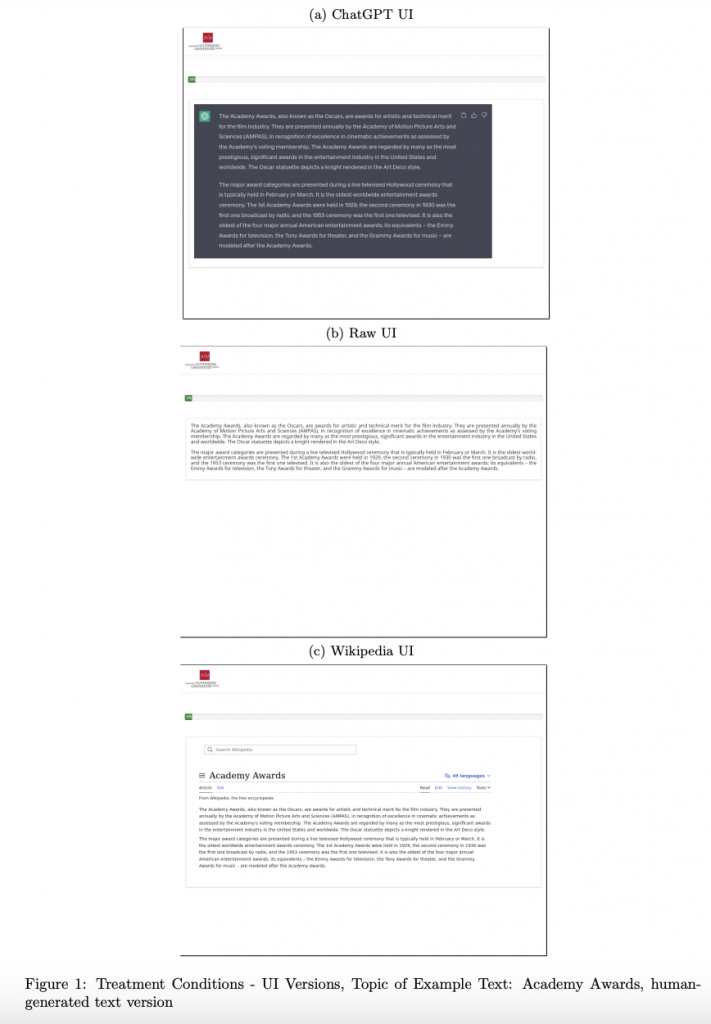

今回紹介する論文では、異なるユーザーインターフェイス(UI)のテキストで、人間とコンピュータが生成したコンテンツから受ける信頼性の印象を調査しています。

その結果は驚くべきものでした。

参照論文情報

- タイトル:Do You Trust ChatGPT? — Perceived Credibility of Human and AI-Generated Content

- 著者:Martin Huschens, Martin Briesch, Dominik Sobania, Franz Rothlauf

- 所属:University of Applied Sciences Mainz, Johannes Gutenberg University Mainz

- URL:https://doi.org/10.48550/arXiv.2309.02524

研究背景

LLMによるテキスト生成とそのリスク

近年、大規模言語モデル(LLM)によるテキスト生成技術が急速に進化しています。この技術は、高品質なテキストを生成する能力を持つ一方で、ハルシネーションやバイアスを含むテキストを生成するリスクも抱えています。ハルシネーションは、事実ではない情報を生成する現象を指し、バイアスは、特定の視点や価値観を強調するテキストを生成する傾向を指します。

ブログやSNSでのテキストの利用

LLMによって生成されたテキストは、ブログやSNSなどのプラットフォームで広く利用されています。しかしこれには上述したようなリスクが伴います。にも関わらず、LLMが生成したテキストをそのまま転載してしまう人々が増えている現状が、情報の信頼性や真正性に関する問題を引き起こしています。

信頼性の評価とメディアリテラシー

この状況を踏まえ、研究者らはLLMと人間が生成したテキストの信頼性を比較する実験を設計しました。この実験は、テキストの信頼性をどのように評価するか、そしてメディアリテラシーを高める必要性に焦点を当てています。

メディアリテラシーとは、メディアコンテンツを批判的に分析し、評価する能力を指します。メディアが提供する情報の真偽を判断する技術や、メディアがどのように情報を構築・提示しているかを理解する能力が含まれます。

実験デザイン

参加者と調査方法

研究者らは、現代社会において出現した新しい現象ーAI生成テキストの増加ーとそれに伴うリスクを調査する目的で、606人を対象にオンライン調査を実施しました。この調査は、人間とGPTが生成した文章の信頼性を比較することを目的としており、参加者は異なるテキスト抜粋に対する信頼性の印象を評価しました。

実験のトピック

実験では、以下の4つのトピックを用いてテキスト抜粋を生成しました。

- アカデミー賞

- カナダ

- マルウェア

- 米国上院

これらのトピックは多岐にわたるテーマをカバーしており、参加者に多様な背景知識を要求します。

テキスト形式

テキストは3つの異なる形式で提示されました。それぞれの形式は以下の通りです。

- ChatGPT形式

- プレーンテキスト形式(Raw Text UI)

- Wikipedia形式

テキストの形式が信頼性の評価にどのように影響するかを調べることもテーマとなっています。

人間とGPTの生成する文章の混在

実験デザインの特徴的な点は、人間とGPTが生成した文章を混在させて提示したことです。つまり、参加者がどのテキストが人間によって生成されたものであるか、またはGPTによって生成されたものであるかをあらかじめ知ることなく、テキストの信頼性を評価することが求められました。

この実験デザインは、現実の状況を模擬したものであり、人々が日常的に遭遇する情報源の多様性と複雑さを反映しています。

実験結果

また記事の購読には、アカウント作成後の決済が必要です。

※ログイン/初回登録後、下記ボタンを押してください。

AIDBとは

プレミアム会員(記事の購読)について

■サポートのお願い

AIDBを便利だと思っていただけた方に、任意の金額でサポートしていただけますと幸いです。

PAGE TOP

PAGE TOP